Cadenas de markov

description

Transcript of Cadenas de markov

2012

Examen de Análisis y Toma de decisiones. Dr. Manuel Jáuregui Renault

[CADENAS DE MARKOV] Carlos Delgado Avila. No de Cta: 409083200

Contenido Contexto Histórico……………………………………………………………………….1

Introducción……………………………………………………………………………...3

Definiciones de cadenas de Markov……………………………………………………..4

Notaciones…………………………………………….…………………………………5

Cadenas homogéneas y no homogéneas………………………………………...5

Probabilidades de transición y matriz de transacción. ………………………….5

Cadena de Markov homogénea………………………………………………….6

Vector de probabilidad invariante……………………………….........................7

Clases de comunicación. ……………………………..........................................8

Tiempos de entrada…………………………….......................…………………8

Recurrencia…………………………….......................…………………………8

Periodicidad……………………………………………………………………..9

Tipos de Cadenas de Markov…………………………………………………………...9

Cadenas Irreductibles……………………………………………………………9

Cadenas positivo-recurrentes……………………………………………………9

Cadenas de Markov en tiempo continuo………………………………………...9

Cadenas absorbentes……………………………………………………………10

Cadenas ergódicas o irregulares………………………………………………...10

Cadenas Semiergódicas…………………………………………………………11

Cadenas no ergódicas…………………………………………………………...11

Cadenas cíclicas…………………………………………………………………12

Clasificación de cadenas de Markov…………………………………………………….13

Análisis topológico de las cadenas de Markov…………………………………..13

Propiedades de estado……………………………………………………………13

Propiedades de clase……………………………………………………………...15

Aplicaciones de las cadenas de Markov…………………………………………………16

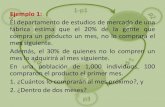

Análisis y toma de decisión del uso de cadenas de Markov; Ejemplo Practico…………17

Bibliografía………………………………………………………………………………24

0

“Una cadena de demostraciones debe tener su principio en alguna

parte”

JEREMY BENTHAM

An Introduction of Morals and Legislation

1

Contexto Histórico

Andréi Andréyevich Márkov (14 de junio de 1856 - 20 de julio de 1922)

Matemático ruso conocido por sus trabajos en la

teoría de los números y la teoría de

probabilidades.

Márkov nació en Riazán, Rusia. Antes de los 10

años su padre, un funcionario estatal, fue

trasladado a San Petersburgo donde Andréi entró

a estudiar en un instituto de la ciudad. Desde el

principio mostró cierto talento para las

matemáticas y cuando se graduó en 1874 ya

conocía a varios matemáticos de la Universidad

de San Petersburgo, donde ingresó tras su

graduación. En la Universidad fue discípulo

de Chebyshov y tras realizar sus tesis de

maestría y doctorado, en 1886 accedió como

adjunto a la Academia de Ciencias de San

Petersburgo a propuesta del propio Chebyshov.

Diez años después Márkov había ganado el puesto de académico regular.

Desde 1880, tras defender su tesis de maestría, Márkov impartió clases en la

Universidad y, cuando el propio Chebyshov dejó la Universidad tres años después,

fue Márkov quien le sustituyó en los cursos de teoría de la probabilidad. En 1905,

tras 25 años de actividad académica, Márkov se retiró definitivamente de la

Universidad, aunque siguió impartiendo algunos cursos sobre teoría de la

probabilidad.

A parte de su perfil académico, Andréi Márkov fue un convencido activista político.

Se opuso a los privilegios de la nobleza zarista y llegó a rechazar las

condecoraciones del propio zar en protesta por algunas decisiones políticas

relacionadas con la Academia de Ciencias. Hasta tal punto llegó su implicación en

la política que llegó a ser conocido con el sobrenombre de "el académico militante".

Márkov arrastró durante toda su vida problemas relacionados con una

malformación congénita en la rodilla que le llevaría varias veces al quirófano y que,

con el tiempo, fue la causa de su muerte cuando el 20 de julio del año 1922 una

de las muchas operaciones a las que se sometió le produjo una infección

generalizada de la que no pudo recuperarse.

Aunque Márkov influyó sobre diversos campos de las matemáticas, por ejemplo en

sus trabajos sobre fracciones continuas, la historia le recordará principalmente por

sus resultados relacionados con la teoría de la probabilidad. En 1887 completó la

prueba que permitía generalizar el teorema central del límite y que ya había

avanzado Chebyshov. Pero su aportación más conocida es otra.

2

Su trabajo teórico en el campo de los procesos en los que están involucrados

componentes aleatorios (procesos estocásticos) darían fruto en un instrumento

matemático que actualmente se conoce como cadena de Márkov: secuencias de

valores de una variable aleatoria en las que el valor de la variable en el futuro

depende del valor de la variable en el presente, pero es independiente de la

historia de dicha variable. Las cadenas de Márkov, hoy día, se consideran una

herramienta esencial en disciplinas como la economía, la ingeniería, la

investigación de operaciones y muchas otras.

Universidad de San Petersburgo

3

Introducción

Un proceso o sucesión de eventos que se

desarrolla en el tiempo en el cual el resultado en

cualquier etapa contiene algún elemento que

depende de un proceso al azar se denomina un

proceso aleatorio o proceso estocástico. Por

ejemplo, la sucesión podrían ser las condiciones

del tiempo en Veracruz en una serie de días

consecutivos: el tiempo cambia día con día de

una manera que en apariencia es algo aleatorio.

O bien la sucesión podría consistir de los precios diarios al cierre de ciertas

acciones que cotizan en la bolsa en donde otra vez interviene cierto grado de

aleatoriedad. Una sucesión de elecciones gubernamentales es otro ejemplo de un

proceso estocástico.

Un ejemplo muy simple de un proceso estocástico es una sucesión de ensayos de

Bernoulli en, por ejemplo, una sucesión de lanzamientos una moneda en este

caso el resultado en cualquier etapa es independiente de todo resultados previos.

Sin embargo en la mayoría de los procesos estocásticos cada resultado depende

de lo que sucedió en etapas anteriores del proceso. Por ejemplo, el tiempo en un

día determinado no es aleatorio por completo sino que es afectado en cierto grado

por el tiempo de días previos. El precio de una acción al cierre de cualquier día

depende en cierta medida del

comportamiento de la bolsa en días

previos.

El caso más simple de un proceso

estocástico en que los resultados

dependen de otro(s), ocurre cuando el

resultado en cada etapa solo depende

del resultado de la etapa anterior y no

de cualquiera de los resultados previos.

Tal proceso se denomina cadena de

Markov (una cadena de eventos, cada

evento ligado al precedente).

4

Definiciones de Cadenas de Markov

“Las cadenas de Markov son una herramienta para analizar el comportamiento y el

gobierno de determinados tipos de procesos estocásticos, esto es, procesos que

evolucionan de forma no determinista a lo largo del tiempo en tomo a un conjunto

de estados. Por tanto, representa un sistema que varía su estado a lo largo del

tiempo. Siendo cada cambio una transición del sistema. Dichos cambios no están

predeterminados, aunque sí lo está la probabilidad del próximo estado en función

de los estados, probabilidad que es constante a lo largo del tiempo (sistema

homogéneo en el tiempo). Eventualmente, es una transición, el nuevo estado

puede ser el mismo que el anterior y es posible que exista la probabilidad de influir

en las probabilidades de transición actuando sobre el sistema (decisión).”

Joan B. Fonollosa – Jose M. Sallan

“Una cadena de Markov es una sucesión de ensayos similares u observaciones en

la cual cada ensayo tiene el mismo número finito de resultados posibles y en

donde también la probabilidad de cada resultado para un ensayo dado depende

solo del resultado del ensayo inmediatamente precedente y no de cualquier

resultado previo.”

Jagdish C. Arya – Robin W. Lardner

En matemáticas, se define como un proceso estocástico discreto que cumple con

la propiedad de Márkov, es decir, si se conoce la historia del sistema hasta su

instante actual, su estado presente resume toda la información relevante para

describir en probabilidad su estado futuro.

Una cadena de Márkov es una secuencia X1, X2, X3,... de variables aleatorias. El

rango de estas variables, es llamado espacio estado, el valor de Xn es el estado

del proceso en el tiempo n. Si la distribución de probabilidad condicional de Xn+1 en

estados pasados es una función de Xn por sí sola, entonces:

Donde xi es el estado del proceso en el instante i. La identidad mostrada es

la propiedad de Markov.

5

Notaciones

Cadenas homogéneas y no homogéneas

Una cadena de Markov se dice homogénea si la probabilidad de ir del estado i al

estado j en un paso no depende del tiempo en el que se encuentra la cadena, esto

es:

para todo n y para cualquier

i, j.

Si para alguna pareja de estados y para algún tiempo n la propiedad antes

mencionada no se cumple diremos que la cadena de Markov es no homogénea.

Probabilidades de transición y matriz de transición

La probabilidad de ir del estado i al estado j en n unidades de tiempo es:

En la probabilidad de transición en un paso se omite el superíndice de modo que

queda:

Un hecho importante es que las probabilidades de transición en n pasos satisfacen

la ecuación de Chapman-Kolmogorov, esto es, para cualquier k tal que

0 < k < n se cumple que

Donde E denota el espacio de estados.

Cuando la cadena de Markov es homogénea, muchas de sus propiedades útiles

se pueden obtener a través de su matriz de transición, definida entrada a entrada

como esto es, la entrada i, j corresponde a la probabilidad de ir del

estado i a j en un paso.

Del mismo modo se puede obtener la matriz de transición en n pasos como:

, donde .

6

Cadena de Markov homogénea

Decimos que una cadena de Markov es homogénea o estacionaria cuando se

verifica que:

Es decir que las probabilidades de transición solo dependen de la diferencia entre

los instantes de tiempo y no del valor absoluto de estos. Esta característica se

cumple en muchos casos de interés práctico.

Las cadenas de Markov homogéneas que van a ser de nuestro interés son

aquellas en las que en régimen permanente el vector de estado tiende a un valor

asintóticamente estable, es decir:

Ejemplo: Erase una vez un hippie, que decide quedarse

vagabundeando por la huerta valenciana, especialmente

entre los pueblos de Almacera, Alboraya y Tavernes. El

hippie en la tarde se puede cansar del pueblo en el que

esta, sale a la carretera y se pone a pedir raid. El

diagrama que vemos abajo representa las probabilidades

de que lo recoja alguien en la dirección dada. En

Alboraya, de vez en cuando decide pasar la noche y

endulzar su vida con una horchata con fartons. Nuestro

interés es conocer las probabilidades de estado y ver si

existe un límite en régimen permanente (independientemente del lugar en el que el

hippie empiece su periplo).

7

La matriz de transición viene dada por:

Y no depende del tiempo.

Entonces recordando que P(i + 1)= P(i) T (i, i + 1), se calcularan las

probabilidades de estado después de varias transiciones y partiendo de

condiciones iniciales distintas:

Luego, como vemos

( )

Vector de probabilidad invariante

Se define la distribución inicial .

Diremos que un vector de probabilidad (finito o infinito numerable) es invariante

para una cadena de Markov si donde P denota la matriz de transición de

la cadena de Markov. Al vector de probabilidad invariante también se le

llama distribución estacionaria o distribución de equilibrio.

8

Clases de comunicación Para dos estados i,j en el espacio de estados E, diremos que de i se accede a j (y

se denotará ) si para algún n, si y entonces

diremos que i comunica con j y se denotará i↔j.

La propiedad "↔" es una relación de equivalencia. Esta relación induce una

partición en el espacio de estados. A estas clases de equivalencia las

llamaremos clases de comunicación.

Dado un estado x, denotaremos a su clase de comunicación como C(x).

Diremos que un subconjunto C del espacio de estados (al que denotaremos E) es

cerrado si ningún estado de E-C puede ser accedido desde un estado de C, es

decir, si para todo x∈C, para todo y∈E-C y para todo natural m>0.

Tiempos de entrada

Si , definimos el primer tiempo de entrada a C como la variable aleatoria

esto es, denota la primera vez que la cadena entra al conjunto de estados C.

Recurrencia En una cadena de Markov con espacio de estados E, si x∈E se define:

y diremos que:

x es estado recurrente si .

x es transitorio si

x es absorbente si

Una clase de comunicación es clase recurrente si todos sus estados

son recurrentes.

Sea , si x∈Ediremos que:

x es cero-recurrente si

x es positivo-recurrente si

El real se interpreta como el tiempo promedio de recurrencia.

9

Periodicidad

El periodo de un estado x∈E se define como:

donde denota el máximo común divisor.

Si d(x)=1 diremos que x es un estado aperiódico.

Una cadena de Markov se dice aperiódica si todos sus estados

son aperiódicos.

Tipos de cadenas de Markov

Cadenas irreducibles

Una cadena de Markov se dice irreducible si se cumple cualquiera de las

siguientes condiciones (equivalentes entre sí):

1. Desde cualquier estado de E se puede acceder a cualquier otro.

2. Todos los estados se comunican entre sí.

3. C(x)=E para algún x∈E.

4. C(x)=E para todo x∈E.

5. El único conjunto cerrado es el total.

La cadena de Ehrenfest o la caminata aleatoria sin barreras absorbentes son

ejemplos de cadenas de Markov irreducibles.

Cadenas positivo-recurrentes

Una cadena de Markov se dice positivo-recurrente si todos sus estados son

positivo-recurrentes. Si la cadena es además irreducible es posible demostrar que

existe un único vector de probabilidad invariante y está dado por:

Cadenas de Markov en tiempo continuo

Si en lugar de considerar una secuencia discreta X1, X2,..., Xi,.. con i indexado en

el conjunto de números naturales, se consideran las variables

aleatorias Xt con t que varía en un intervalo continuo del conjunto de números

reales, tendremos una cadena en tiempo continuo. Para este tipo de cadenas en

tiempo continuo la propiedad de Markov se expresa de la siguiente manera:

tal que

Para una cadena de Markov continua con un número finito de estados puede

definirse una matriz estocástica dada por:

10

La cadena se denomina homogénea si . Para una cadena de Markov

en tiempo continuo homogénea y con un número finito de estados puede definirse el llamado

generador infinitesimal como:2

Y puede demostrarse que la matriz estocástica viene dada por:

Cadenas absorbentes

Una cadena de Markov con espacio de estados finito se dice absorbente si se

cumplen las dos condiciones siguientes:

1. La cadena tiene al menos un estado absorbente.

2. De cualquier estado no absorbente se accede a algún estado absorbente.

Si denotamos como A al conjunto de todos los estados absorbentes y a su

complemento como D, tenemos los siguientes resultados:

Su matriz de transición siempre se puede llevar a una de la forma

Donde la submatriz Q corresponde a los estados del conjunto D, I es la matriz

identidad, 0 es la matriz nula y R alguna submatriz.

, esto es, no importa en donde se encuentre la

cadena, eventualmente terminará en un estado absorbente.

Cadenas ergódicas o regulares

La cadena de Markov C1, de dos estados, tiene la matriz de probabilidades de

transición:

Calculemos la potencia decimosexta de esa matriz para aproximar la matriz de

probabilidades estacionarias:

Se observa que las probabilidades de estado estable de los diferentes estados son

independientes del estado de origen, razón por la que la matriz de probabilidades

11

estacionarias tiene todas las filas iguales. Tenemos entonces una cadena de

Markov regular en la que las probabilidades estacionarias no dependen del estado

inicial. Además, ninguna de las probabilidades vale cero. Tenemos entonces una

cadena de Markov ergódica.

Cadenas Semiérgodicas

Tenemos ahora una cadena de C2 de cuatro estados, de matriz de probabilidades

de transición.

Si se observa la matriz de la transición decimosexta, se observa como todas las

filas tienden a ser iguales (aunque no completamente, especialmente las dos

primeras), con una diferencia respecto de las cadenas ergódicas: existen estados

cuya probabilidad de estado estable tiende a ser cero (esto es, que no aparecerán

den el comportamiento a largo plazo). Por lo tanto, no se trata de una cadena

ergódica. Sin embargo, sigue siendo cierto que todas las filas tienden hacia un

mismo valor, por lo que sigue siendo regular. Las cadenas de Markov regulares (y

también otras que veremos más adelante) con algunas de las columnas de la

matriz de probabilidades estacionarias igual a cero se llaman semiergódicas. Las

cadenas ergódicas pueden considerarse como un caso particular de las cadenas

semiergódicas, en las que no existen probabilidades de estado iguales a cero.

Cadenas no ergódicas

La cadena C3, de cuatro estados, tiene la siguiente matriz de transición:

Si observamos la matriz de la transición 16, podemos ver que, mientras algunas

filas tienen el mismo comportamiento que las de los casos anteriores, vemos que

otras tienden a ciertos valores, diferentes de los de las otras filas. Ello quiero decir

que, al contrario de lo que sucede con el caso regular, las probabilidades de

12

estado estable si dependen de cuál ha sido el estado inicial de la cadena. Se trata

de una cadena semirregular

Cadenas Cíclicas

La cadena C4, cuya matriz de probabilidades de transición se muestra a

continuación, después de un número elevado de transiciones presenta un

comportamiento diferente del de las cadenas anteriores.

Al ir obteniendo matrices de transición, se observa que estas no convergen a un

valor concreto, sino que muestran un comportamiento cíclico. En este caso, las

transiciones impares tienden a un valor y las pares a otro.

Este tipo de cadenas son cadenas son cadenas cíclicas. En este caso particular,

nos encontramos ante una cadena de periodo p=2.

La columna es siempre cero, por lo que el estado I no aparecerá en las

probabilidades a largo plazo; quiere ello decir que la cadena considerada no es

ergódica, aunque es claro que pueden existir cadenas cíclicas ergódicas.

13

También debemos preguntarnos qué ocurre con las probabilidades estacionarias

en las cadenas cíclicas, ya que si las sucesivas potencias de P no tienden hacia

unos valores determinados. Más adelante, cuando estudiamos el cálculo

sistemático de P*.

Clasificación de cadenas de Markov

De lo expuesto hasta ahora, si queremos analizar el comportamiento a largo plazo

de un proceso estocástico que cumpla la propiedad markoviana, necesitamos:

Una metodología para poder clasificar la cadena como ergódica o no

ergódica por una parte, y como regular, semirregular o cíclica por otra,

examinado la matriz de probabilidades de transición.

Una metodología que permita el cálculo de la matriz de probabilidades.

La clasificación de las cadenas de Markov puede realizarse mediante dos

metodologías:

El análisis topológico, examinando las propiedades de los estados de la

cadena y estableciendo clases de equivalencia entre los estados.

El análisis espectral, examinando los valores propios de la matriz de

probabilidades de transición de un paso.

Una vez clasificada la cadena, puede obtenerse información acerca de la forma

que presente la matriz de probabilidades estacionarias, lo cual facilita su obtención.

Análisis topológico de las cadenas de Markov

Permite la clasificación de las cadenas a partir de la información suministrada por

la matriz P utilizando propiedades relativas a la relación entre estados

(propiedades de estado). Estas propiedades permiten, a su vez, definir

subconjuntos de estados denominados clases. También podremos definir,

entonces, las propiedades de clase.

Propiedades de estado

Dados dos estados de una cadena, pueden establecerse dos tipos de relaciones

entre ellos:

El estado i es descendente de j si cuando iniciamos el proceso es i existe

una probabilidad no nula de que el proceso llegue a j. En este caso,

diremos que existe un camino entre los estados i y j.

14

Los estados i y j se comunican si i es descendiente de j y j es descendiente

de i.

Existirá un ciclo dentro de una cadena de Markov si existe un camino en la

cadena que comunique al estado i consigo mismo. Dicho circuito se

caracteriza por el numero mínimo de transiciones que necesitara el sistema

para volver al estado i, si se inició el proceso en ese estado. Dicho número

constituirá la longitud del ciclo.

Obsérvese que, con las definiciones dadas, la existencia de un circuito implica que

todos los estados que lo forman están comunicados. Se conviene que todo estado

esta comunicado consigo mismo, ya que se al menos puede acceder a él en cero

transiciones (circuito de longitud cero), con independencia de que además existan

otros circuitos de longitud mayor.

Para analizar estas relaciones entre estados, es útil recordar que, según la teoría

de grafos, toda matriz cuadrada tiene asociado un grafo, cuya representación

gráfica se puede elaborar a partir de la matriz de probabilidades de transición, el

diagrama de transiciones de estados.

Cada estado de la cadena se representa por un vértice del grafo y cada transición

con probabilidad no nula se representa por una relación entre los vértices que

representan los estados anterior y posterior de la misma. De esta manera el

diagrama se representan todas las situaciones en las que un estado i es

descendente respecto de j.

15

Propiedades de clase

Hemos establecido que un

estado está siempre

comunicado consigo

mismo, la relación entre

estados estar comunicado

es reflexiva, simétrica y

transitiva, por lo que se

trata de una relación de

equivalencia. Po este

motivo, podemos decir que

un conjunto de estados

comunicados entre si

constituye un clase de

equivalencia. De esta manera podemos clasificar diversas clases los estados de

una cadena de Markov.

Podemos definir la propiedad de clase siguiente para las clases de equivalencia

que se hayan establecido:

Una clase de equivalencia será final si cuando el proceso llega a uno de los

estados de la clase, en las transiciones siguientes el proceso evoluciona

siempre dentro de los estados de la clase.

Aquellas clases de equivalencia que no sean clases finales serán las claves

de paso. Las clases de paso tienen un interés muy limitado en el estudio de

las cadenas de Markov.

Puesto que el sistema debe

ser capaz de evolucionar

indefinidamente entre un

número finito de estados,

toda cadena debe tener al

menos una clase final. Si en

su evolución a lo largo de

infinitas transiciones el

sistema puede pasar por

todos los estados, entonces

habrá una única clase final

que los englobara a todos

ellos. Este caso es el que

hemos definido anteriormente como cadena ergódica.

16

Aplicaciones de las cadenas de Markov

Física

Las cadenas de Markov son usadas en muchos problemas de la termodinámica y

la física estadística. Ejemplos importantes se pueden encontrar en la Cadena de

Ehrenfest o el modelo de difusión de Laplace.

Meteorología

Si consideramos el clima de una región a través de distintos días, es claro que el

estado actual solo depende del último estado y no de toda la historia en sí, de

modo que se pueden usar cadenas de Markov para formular modelos

climatológicos básicos.

Modelos epidemiológicos

Una importante aplicación de las cadenas de Markov se encuentra en el proceso

Galton-Watson. Éste es un proceso de ramificación que se puede usar, entre otras

cosas, para modelar el desarrollo de una epidemia (véase modelaje matemático

de epidemias).

Internet

El pagerank de una página web (usado por Google en sus motores de búsqueda)

se define a través de una cadena de Markov, donde la posición que tendrá una

página en el buscador será determinada por su peso en la distribución

estacionaria de la cadena.

Simulación

Las cadenas de Markov son utilizadas para proveer una solución analítica a

ciertos problemas de simulación tales como el Modelo M/M/1.3

Juegos de azar

Son muchos los juegos de azar que se pueden modelar a través de una cadena

de Markov. El modelo de la ruina del jugador, que establece la probabilidad de que

una persona que apuesta en un juego de azar finalmente termine sin dinero, es

una de las aplicaciones de las cadenas de Markov en este rubro.

Economía y Finanzas

Las cadenas de Markov se pueden utilizar en modelos simples de valuación de

opciones para determinar cuándo existe oportunidad de arbitraje, así como en el

modelo de colapsos de una bolsa de valores o para determinar la volatilidad de

precios. En los negocios, las cadenas de Márkov se han utilizado para analizar los

patrones de compra de los deudores morosos, para planear las necesidades

de personal y para analizar el reemplazo de equipo.

Música

Diversos algoritmos de composición musical usan cadenas de Markov, por

ejemplo el software Csound o Max.

17

Análisis y toma de decisión del uso de cadenas de Markov; Ejemplo Practico

Modelos empleados para la Toma de decisiones en el cuidado de la salud

RESUMEN

El análisis de decisiones es un grupo de herramientas que permiten apoyar y

manejar un proceso de evaluación estructurado. Esta metodología se usa

ampliamente en la evaluación económica para planeación o programas de salud.

Este artículo delinea algunas características de las decisiones complejas y

muestra los fundamentos y etapas que deben considerarse cuando se toman

decisiones en un escenario de incertidumbre (definición del problema, selección

de un marco temporal de análisis adecuado, estructuración del problema,

desarrollo de un modelo para análisis, selección de la mejor alternativa y

realización de análisis de sensibilidad). Finalmente se presentan algunas críticas

que se han hecho a esta metodología.

Tomar una decisión implica escoger entre varias alternativas. Tomar la mejor

decisión supone haber hecho un análisis de lo que hubiera sucedido Tsi cada una

de las posibles alternativas se hubiera seleccionado. La toma de decisiones es un

acto cotidiano que está involucrado en múltiples actividades que generalmente se

hace por técnicas como la adivinanza, la reacción visceral, la intuición, o la

experiencia basada en opiniones o sucesos muy parecidos.

La toma decisiones de forma intuitiva generalmente resulta poco eficiente dado

que esta estrategia no suele incorporar todos los factores que pueden afectar la

decisión y sus resultados. Pocas decisiones se toman con plena certidumbre

sobre sus posibles consecuencias. El proceso de tomar decisiones puede ser

mejorado utilizando una metodología que combina una estructura explícita y una

técnica cuantitativa de análisis y que se ha denominado "enfoque sistemático de

toma de decisiones bajo condiciones de incertidumbre". Tal metodología, que no

es nativa del área de la salud, se concibió inicialmente como un proceso iterativo

para generar mayor conocimiento y facilitar la generación de alternativas creativas

que ayudaran a los tomadores de decisiones a realizar mejores decisiones.

¿Por qué puede ser difícil tomar una decisión?

La dificultad para tomar una decisión se relaciona con tres aspectos:

Estructurales, personales y políticos:

18

1. Aspectos estructurales: Dentro de esta categoría se agrupan las siguientes

situaciones:

a. El grado de incertidumbre: La incertidumbre se presenta cuando no se conoce

completamente la probabilidad de que ocurra un evento. Al existir incertidumbre

resulta imposible conocer de antemano cuál va a ser el resultado de una decisión.

La incertidumbre puede relacionarse con el diagnóstico, la exactitud de las

herramientas diagnósticas, la calidad y disponibilidad de las fuentes de

información, la historia natural de las enfermedades, las opciones que tomen los

pacientes y los resultados del tratamiento. Al existir múltiples fuentes de

incertidumbre se hace más complicado tener un esquema claro de las diferentes

opciones y resultados de las posibles alternativas de decisión.

b. Cantidad de alternativas disponibles: Entre mayor sea el número de alternativas

entre las cuales haya que escoger, mayor será la complejidad del recorrido entre

la decisión y las posibles consecuencias. La utilización de herramientas gráficas,

como los árboles de decisión, permiten tener una visión más clara y precisa de los

diferentes cursos que pueden tomar las múltiples alternativas de decisión.

c. Consecuencias de tomar la decisión: Entre más graves son las consecuencias

de tomar una decisión incorrecta, más difícil resulta optar por una alternativa.

d. Frecuencia con la que se toman decisiones parecidas: A menor frecuencia,

mayor suele ser la dificultad para tomar la decisión.

2. Aspectos personales: Algunas características psicológicas de quien toma la

decisión pueden dificultar este proceso. Por ejemplo los patrones de personalidad

obsesivos, caracterizados por el perfeccionismo, la rigurosidad y la preocupación

exagerada por detalles, suelen presentar una tendencia a complicar la toma de

decisiones. Por otro lado las personas impulsivas tienden a tomar más fácilmente

decisiones, pero de manera no acertada, dada la falta de análisis que aplican a su

conducta. El tomador de decisiones debería ser una persona que tenga claridad

sobre las características personales que pudieran afectar el proceso de

seleccionar la alternativa acertada.

3. Aspectos políticos: En algunos casos la alternativa más acertada, escogida

mediante un proceso racional y sistematizado, debe supeditarse a

consideraciones de orden político que resultan prioritarias.

Para el manejo de los aspectos estructurales se ha desarrollado una metodología

que permite utilizar un abordaje cuantitativo y estructurado de las situaciones de

toma de decisiones, y que permite evaluar decisiones que se deben tomar en

situaciones en las que se presenten alternativas complejas y diversas fuentes de

incertidumbre. Dicha metodología, que como ya se mencionó se ha llamado

"análisis de decisiones bajo condiciones de incertidumbre", permite:

1. Generar una estructura gráfica que permita ver claramente la relación entre

alternativas y consecuencias.

19

2. Asignar valores a las fuentes de incertidumbre: Asignando valores de

probabilidad a los puntos de incertidumbre se facilita su manejo. Si hay

certidumbre sobre un evento, su probabilidad de ocurrir es de uno (obviamente la

probabilidad de que no ocurra es cero). Si no hay certidumbre, la probabilidad de

ocurrir será menor que uno. Posteriormente se mostrará cómo se asignan estos

valores de probabilidad.

3. Facilitar la comparación entre las diferentes alternativas en términos numéricos.

En esta metodología, a las alternativas posibles se les asigna un valor numérico

que corresponde a un concepto estadístico denominado "valor esperado". En

estadística el valor esperado (o esperanza matemática) de una variable aleatoria

es la suma de la probabilidad de cada suceso multiplicada por su valor. Dicho de

otra forma el valor esperado se asemeja al resultado que se espera en promedio si

se repitiera un experimento (como lanzar una moneda, o medir la talla de un grupo

de personas, por ejemplo) muchas veces. La utilidad del valor esperado es

permitir elegir entre distintas alternativas. En general la alternativa que se elige es

aquella que tenga el valor esperado más alto (años de vida ganados, muertes

evitadas, por ejemplo), pero en ocasiones se selecciona aquella con el valor más

bajo (mortalidad, costos, por ejemplo).

Con estos insumos el tomador de decisiones puede identificar fácilmente las

opciones viables, predecir sus consecuencias o desenlaces, valorar la

probabilidad de los posibles resultados, determinar el valor de cada uno de los

desenlaces, y seleccionar la decisión que puede proveer el mejor resultado.

En el área del cuidado de la salud, el análisis de decisiones es una metodología

que se desarrolló alrededor de situaciones clínicas en pacientes individuales.

Sin embargo, se usa cada vez más frecuentemente en análisis económicos y para

la toma de decisiones políticas.

Etapas en un análisis de decisiones

Dado que el análisis de decisiones es una metodología que pretende, no solo

facilitar, sino además sistematizar el proceso de selección de alternativas, para

hacerlo, de alguna manera replicable, se ha definido una estructuración a lo largo

de una serie de etapas sucesivas (8) (debe tenerse en cuenta que la replicabilidad

de los resultados se ve fuertemente afectada por los aspectos personales y

políticos mencionados atrás):

1. Definición del problema:

Un problema se ha definido como la distancia que hay entre una situación que

existe y otra que se prefiere. El primer paso suele ser escribir el problema

utilizando pocas palabras, preferiblemente recurriendo al uso de verbos en

infinitivo, y hacer una descripción de ciertos detalles como magnitud, posibles

causas o responsables, momento de inicio, identificación de afectados con el

20

problema, estrategias con las que ha intentado solucionarse, y posible resultado si

no se intenta ninguna solución. Este primer paso puede ser suficiente para tomar

una decisión acertada, lo cual sucede cuando se vislumbran alternativas de

decisión que no se habían considerado, cuando se evidencia que se estaba

sobredimensionando la gravedad del problema, cuando se ve que se estaba

tratando de solucionar el problema equivocado (esto se ha denominado "error tipo

tres"), o incluso cuando se encuentra que si no se hace nada, no pasa nada, y lo

que genera la dificultad muchas veces son los intentos de solución (en este último

caso se habla de pseudo problemas). Otra posibilidad que surge en este primer

paso es encontrar que el problema tiene sub problemas, lo cual implica efectuar

un trabajo de jerarquización y definir claramente cuál es el problema primario o

principal.

2. Definición del horizonte de análisis (marco temporal):

Cuando se evalúan alternativas relacionadas con patologías crónicas, el horizonte

de análisis suele ser largo. En estos casos los eventos pueden reaparecer durante

el período definido en el marco temporal: esto supone utilizar estrategias

especiales de análisis (cadenas y modelos de Markov para eventos recurrentes).

Por otro lado, la evaluación de alternativas relacionadas con complicaciones a

corto plazo o con eventos agudos supone un horizonte de análisis corto. En otras

palabras, el horizonte de análisis dependerá de la naturaleza del problema de

salud que se esté evaluando. Cualquiera que sea el caso, debe hacerse una

especie de negociación entre la exactitud del modelo analítico y la simplicidad del

mismo (10). Un modelo no debe ser una representación completa del mundo real

sino una síntesis de sus componentes más importantes.

3. Estructuración del problema:

La etapa de estructuración supone seguir esta secuencia:

- Identificar las alternativas relevantes: Una vez identificado el problema, deben

plantearse una serie de alternativas, las cuales suelen caer en alguna de las

siguientes categorías:

- Esperar y observar, lo cual es equivalente a la política de "no hacer nada".

- Iniciar una intervención.

- Buscar más información antes de decidir una intervención.

- Definir las consecuencias de cada alternativa identificada previamente: Cada

alternativa genera una serie de consecuencias cuya incorporación en la

estructuración del problema supone que esté suficientemente sustentada con

algún tipo de evidencia. Las consecuencias pueden categorizarse en dos grupos:

i) consecuencias intermedias. ii) desenlaces finales. Por ejemplo, si un médico se

encuentra prestando su servicio rural en un lugar apartado donde no dispone de

medios diagnósticos ni posibilidades de remitir rápidamente a sus pacientes, y

21

recibe a un paciente con una herida por arma de fuego en el cráneo, podría

plantearse, de manera general, que hay dos alternativas: esperar y observar, o

arriesgarse a intervenir quirúrgicamente al paciente. Las consecuencias de cada

alternativa podrían definirse de manera simplista en dos categorías: el paciente

sobrevive o muere (aquí las consecuencias se presentan directamente como los

desenlaces finales). Sin embargo, considerando la falta de pericia quirúrgica del

médico, puede plantearse una consecuencia intermedia de la alternativa

intervencionista: que la cirugía se complique o que no se complique; cada una de

estas consecuencias intermedias puede resultar en la salvación o en la muerte del

paciente.

En la Figura 1 se muestra esta secuencia de consecuencias, con unas

convenciones de representación gráfica que se explicarán más adelante.

- Establecer la probabilidad con la que pueden suceder las diferentes consecuencias de las alternativas planteadas: Un paso fundamental en este tipo de análisis es cuantificar la incertidumbre: esto se logra asignando valores de probabilidad a cada una de las consecuencias emanadas de las alternativas propuestas para la solución del problema. - Asignar un valor a los desenlaces: Un desenlace es lo que finalmente sucede si se escoge una de las alternativas planteadas. En esta fase de la estructuración del problema, se debe asignar un valor numérico a los desenlaces. Esta calificación se realiza con base en el concepto de utilidad. De forma práctica la utilidad se puede considerar como la medida de la preferencia de las personas por un resultado bien o servicio. En particular, en el campo sanitario, seria la medida cuantitativa de la preferencia de las personas por un resultado específico en salud.

22

4. Desarrollo de un modelo del problema: Un modelo es una abstracción o representación de un sistema real, de una idea de un objeto (13). En un análisis de decisiones el modelo es una estructura que busca representar la realidad del problema, combinando los insumos generados en la etapa previa (etapa de estructuración), con el propósito de efectuar una serie de cálculos matemáticos que ayuden a tomar la decisión. Los modelos más utilizados como estrategia de análisis son los árboles de decisión. Mediante su uso se pueden integrar, de manera secuencial, los diferentes elementos que surgen una vez se ha estructurado el problema. En la construcción de un árbol de decisión se siguen las siguientes convenciones Punto de arranque: Es la presentación del problema en pocas palabras. Nodo de decisión: Representa un punto donde se toma una conducta, como por ejemplo las diferentes alternativas de solución que se plantean al problema. Su forma de representación en el árbol es un cuadrado. Nodo probabilístico o de azar: Muestra el punto donde se generan las diferentes consecuencias de una decisión, que no están bajo el control de quien toma las decisiones. Como previamente se comentó, las consecuencias generadas de un nodo de azar tienen un componente de incertidumbre cuantificable por medio de probabilidades. Se representan gráficamente con un círculo. Nodo terminal: Representa los desenlaces finales. Se representa con un triángulo. Conectores: Son líneas que unen los diferentes elementos descritos previamente. La manera de conectar las diferentes estructuras obedece a una secuencia en la que, lo que está a la izquierda, temporalmente ha ocurrido antes que lo que está a la derecha. La amplitud con la que se desarrolle el árbol corresponde al horizonte de análisis.

Definiciones y valores: Los conectores que salen de un nodo de azar tienen en su parte superior la descripción del desenlace y el su parte inferior la cuantificación de la incertidumbre (valores de probabilidad). En el extremo de los nodos terminales se ubican los valores asignados a los desenlaces (utilidades). Figura 2. Convenciones utilizadas en la construcción de un árbol de decision

23

5. Efectuar análisis de sensibilidad: Teniendo en cuenta que, ni los valores de probabilidad con que se mide la incertidumbre ni los valores asignados a los desenlaces son valores fijos, al efectuar un análisis de decisiones surge la duda sobre la posibilidad de que la solución al problema cambiara si los valores de la medición de incertidumbre y consecuencias variaran. Para resolver esta duda se realizan los análisis de sensibilidad. Ellos permiten evaluar los resultados ante la posible gama de valores que podrían tomar uno o más de los parámetros introducidos en el modelo. Como resultado se puede conocer la estabilidad de la conclusión dada la variabilidad de los supuestos introducidos en el modelo. Es frecuente que para estos análisis se utilicen herramientas gráficas. En los casos en los que la variabilidad se genera en un solo punto del modelo se utilizan los análisis de sensibilidad de un parámetro. Si la fuente de variabilidad proviene de varios puntos se habla de análisis de sensibilidad de múltiples parámetros. 6. Selección de la "mejor" alternativa: Al finalizar el análisis se obtendrán una serie de valores numéricos (valores esperados) que ponderarán de manera diferente las distintas alternativas de decisión. Dependiendo de la medida de utilidad manejada, se seleccionará la mejor opción (por ejemplo si se manejan años de vida saludable ganados, la mejor opción será aquella con el mayor valor). Sin embargo, hay que tener en cuenta que los resultados numéricos no son la única herramienta a la hora de tomar la decisión final. Existen casos en los cuales tiene más peso algún otro tipo de factor, como pueden ser aspectos clínicos o políticos. La recomendación general al utilizar este tipo de métodos es que son solo herramientas para ayudar a decidir, mas no el único elemento que se toma en cuenta para la toma final de la decisión. Críticas al análisis de decisiones Los detractores de esta metodología aducen tres razones para no recomendar su uso: 1. Dificultad Así existan herramientas manejables con computadores, la gran cantidad de opciones derivada de la toma de una decisión compleja, hace que la estructura a analizar se vuelva demasiado enmarañada y alejada de la realidad. Algunos teóricos de la economía, conscientes de la limitación impuesta por la complejidad que pueden alcanzar los modelos, han planteado que no es posible escogerla mejor opción. Dentro de esta tendencia se plantea también la utilización de modelos parsimoniosos que, si bien no capturan la integridad de la complejidad de la situación, incorporan los aspectos más relevantes de la misma. Los árboles de decisión tradicionales, presentan inconvenientes cuando se quiere representar eventos que pueden ocurrir más de una vez, eventos cuyas probabilidades de ocurrencia cambian con el tiempo, eventos que no ocurren inmediatamente y eventos que tienen implicaciones a largo plazo en los pacientes (16,17). Las cadenas y modelos de Markov permiten manejar estas dificultades que se presentan con los árboles de decisión tradicionales, y son útiles cuando se quiere modelar problemas que involucran riesgos que dependen del tiempo.

24

2. Falta de sensibilidad política Se ha planteado que esta metodología se engolosina con la estructura del problema pero que no le da énfasis a las dificultades que implica poner en la práctica la toma de la decisión. Aunque la objetividad y la neutralidad de valores se han adjudicado a esta metodología como una de sus fortalezas, se h encontrado que las personas que no han participado en la toma de la decisión pueden mostrar resistencia ante el proceso de implementar la decisión. Esto ha podido verse en el poco impacto que han tenido herramientas para tomar decisiones, como las guías de práctica clínica o recomendaciones generadas en consensos. 3. Limitación del razonamiento humano Esta es una consideración más de índole filosófica y se basa en el planteamiento de que no hay verdades absolutas, y que lo que se acepta como conocimiento no es más que el resultado de cómo una cultura ha preparado y aleccionado a un individuo para que evalúe y juzgue una situación. Desde esta perspectiva, los hechos sobre los que se basa un análisis de decisiones no son completamente objetivos, sino que están matizados por particularidades y características de un grupo cultural: así las cosas, no tendría mucho sentido efectuar un riguroso análisis numérico a unos datos que no son más que distorsiones introducidas por la cultura.

Bibliografía

Matemáticas Aplicadas a la Administración y a la Economía.

Jagdish C. Arya, Robin W. Lardner.

Pearson Education 2002

Métodos cuantitativos de organización industrial II

Escrito por Joan B. Fonollosa – José M. Sallan, Albert Suñé.

Edicions UPC 2002

Elementos de Probabilidad y Estadistica

Elmer B. Mode

Reverte 2005 Reimpresión

Modelos empleados para la Toma de Decisiones en el Cuidado de la Salud Ricardo Sánchez-Pedraza, Oscar Gamboa y Jorge A. Díaz

Rev. Salud pública. 10 (1):178-188, 2008