curso_estadistica_1

-

Upload

ivan-ramirez-caqueo -

Category

Documents

-

view

22 -

download

2

description

Transcript of curso_estadistica_1

MÓDULO 1.1 - EXACTITUD Y PRECISIÓN EN EL LABORATORIO .................................................. 2

INTRODUCCIÓN ................................................................................................................................................... 2 TEORÍA / ANTECEDENTES ................................................................................................................................... 2

CUANTIFICACIÓN DE ERRORES ................................................................................................................ 4

Un Breve Ejemplo de Promedio y Varianza. ................................................................................................. 4 COMPARACIÓN DE DATOS DE DOS LABORATORIOS ........................................................................................... 6

EXACTITUD, PRECISIÓN Y CORRELACIÓN .......................................................................................................... 8

Sesgo Condicional........................................................................................................................................ 10

OBSERVACIONES ............................................................................................................................................... 12

MÓDULO 1.2 - ¿SON LOS DATOS REPRESENTATIVOS? ..................................................................... 13

INTRODUCCIÓN ................................................................................................................................................. 13

ANTECEDENTES / TEORÍA ................................................................................................................................. 13

Tamaño de Muestra ..................................................................................................................................... 13

Ubicación de las Muestras .......................................................................................................................... 15

Manejando Datos Agrupados ...................................................................................................................... 16

Polígonos de Influencia ............................................................................................................................... 16

El Método de Malla...................................................................................................................................... 18

Desagrupamiento de Celdas ........................................................................................................................ 18 COMENTARIOS .................................................................................................................................................. 22

MÓDULO 1.3 - DISTRIBUCIONES ESTADÍSTICAS ................................................................................ 25

INTRODUCCIÓN ................................................................................................................................................. 25

ANTECEDENTES / TEORÍA ................................................................................................................................. 25 Un Ejemplo Simple....................................................................................................................................... 25

Un Ejemplo Más Complicado ...................................................................................................................... 26

Un ejemplo considerando la disponibilidad del equipo.............................................................................. 27

Datos Continuos ........................................................................................................................................... 28

La Distribución Normal ............................................................................................................................... 29

La Distribución Log-normal ........................................................................................................................ 32

Ejemplos ....................................................................................................................................................... 34

COMENTARIOS .................................................................................................................................................. 35

MODULO 1.4 - ANÁLISIS DE DATOS ......................................................................................................... 36

INTRODUCCIÓN ................................................................................................................................................. 36

TEORÍA / ANTECEDENTES ................................................................................................................................. 36

Gráficos Rectangulares ............................................................................................................................... 37

Gráficos Interactivos.................................................................................................................................... 39 Gráficos de Efecto Proporcional ................................................................................................................. 40

Gráficos de Probabilidad ............................................................................................................................ 42

COMENTARIOS .................................................................................................................................................. 43

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 2

Módulo 1.1 - Exactitud y Precisión en el Laboratorio

Introducción

La geoestadística considera el estudio de la información distribuida en el aspecto espacial.

Para permitir una introducción a algunos conceptos básicos subyacentes a la geoestadística

sin la complejidad de la componente espacial, este primer módulo examinará los conceptos

estadísticos clásicos para la información no espacial. Como una ayuda para la introducción

de estos conceptos, se examinará una situación hipotética de someter una muestra a un

laboratorio y definir la calidad de los datos de ensayo resultantes. Los resultados

proporcionadas por un laboratorio siempre contienen algún elemento aleatorio. Esto es, en

incluso el material más cuidadosamente homogeneizado que es sub-muestreado y enviado

al laboratorio, existen siempre diferencias dentro de las muestras mismas, o en la

preparación de la muestra, o los procedimientos que hacen que cada sub-muestra tenga

diferentes leyes informadas. Las técnicas estadísticas básicas utilizadas para medir esta

aleatoriedad serán discutidas en este capitulo. En los siguientes módulos, las mediciones de

incertidumbre descritas aquí serán aplicadas a la información distribuida en el aspecto

espacial.

Teoría / Antecedentes

Como punto de partida, vamos a suponer que una muestra normal de ley conocida ha sido

preparada y será sub-muestreada. A través de una evaluación de los resultados de ensayo

de la sub-muestra se obtendrá alguna idea acerca de la calidad de los ensayos.

Específicamente, supongamos que 100 sub-muestras son entregadas y se requiere una

cuantificación de la ley de un elemento de interés específico. Este marco hipotético es, de

alguna forma, similar a un arquero apuntando a un blanco. La mayor diferencia es que el

arquero generalmente puede ver el centro del blanco. El arquero en nuestro caso, el

laboratorio, debe establecer correctamente la ubicación del centro del blanco y luego debe

alcanzarlo repetidas veces. Muchas cosas pueden suceder. En el mejor de los casos el

laboratorio establecerá su mira justo en el centro del blanco y lo alcanzará en todas las

oportunidades. Este laboratorio sería considerado perfecto ya que la ley conocida se

reproduciría en todos los intentos. Pero ya que nadie (y ciertamente ningún laboratorio) es

perfecto, este marco hipotético es muy poco probable.

¿Cómo pueden salir mal las cosas? Hay algunas formas. El arquero puede perder

consistentemente el centro del blanco por exactamente la misma cantidad. Esto sería

equivalente a un laboratorio informando exactamente la misma ley para cada una de las 100

sub-muestras entregadas; pero, desafortunadamente informando una ley diferente de la ley

conocida. Este tipo de diferencia es conocido como un error sistemático y puede ser

comparado con el caso de un arquero (debido quizás a un equipamiento deficiente o

anteojos poco apropiados) que consistentemente está fuera del blanco. Puede acertar en el

mismo lugar todo el tiempo, pero desafortunadamente el punto acertado no es el centro del

blanco.

Consideremos un segundo arquero (con el equipo apropiado - incluyendo los anteojos), este

arquero sabe donde se encuentra el centro del blanco, pero (debido a una mano temblorosa)

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 3

no parece acertarle. Como resultado, las flechas están a lo largo de todo el blanco en un

patrón al azar. Debido a que este arquero estaba apuntando al centro correcto del blanco y

sólo no pudo alcanzarlo debido a los movimientos al azar provenientes de su mano, el error

sistemático es mínimo. El tipo de error observado aquí es conocido como error aleatorio.

Un laboratorio con errores aleatorios (pero no sistemáticos) retornaría, en promedio,

valores centrados en el valor conocido. En muchos casos, los valores informados por un

laboratorio contienen tanto errores sistemáticos como errores aleatorios. Esto es

equivalente a un arquero con una ubicación deficiente y una mano temblorosa.

Típicamente, un laboratorio que proporciona resultados que contienen errores sistemáticos

mínimos o ningún error es considerado exacto. Un laboratorio que proporciona resultados

con un margen escaso de error aleatorio es considerado preciso. En todos los aspectos de

estimación de recursos, comenzando por los resultados de laboratorio y continuando hasta

la estimación de ley de bloques, queremos esforzarnos por lograr cero errores sistemáticos

(exactitud perfecta) y errores aleatorios que sean lo más pequeños posible (alta precisión).

Exacto y Preciso Preciso pero no Exacto

Exacto pero no Preciso ni Exacto ni Preciso

Ejemplos de posibles tipos de errores

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 4

Cuantificación de Errores

Cada resultado proporcionado por un laboratorio, o la ubicación de cada flecha en un

blanco, o el número que aparece después de tirar un par de dados, son todos ejemplos de

realizaciones de variables aleatorias. La propiedad más importante de definir es la

tendencia central de la variable aleatoria. Algunos términos que son utilizados a menudo

para describir la tendencia central son un valor promedio o medio, el valor más probable y

más común. El valor medio de la variable aleatoria es la medida más común de la

tendencia central. El valor medio es inferido de un promedio aritmético de las

realizaciones.

Una segunda propiedad a definir es la extensión de la variable aleatoria. La extensión

describe el grado de diferencia entre las diferentes realizaciones individuales y la medida de

tendencia central. Alternativamente, las medidas de extensión describen lo variables o

erráticas que pueden ser las realizaciones individuales. La medida de extensión más

común es la varianza.

Considerando nuevamente el ejemplo del tiro al blanco, podemos ver que la exactitud está

relacionada al valor medio y la precisión está relacionada a la varianza. El centro de un

patrón de flechas es el valor medio estimado y la diferencia entre la media estimada y la

media real o el centro del blanco es la exactitud. La varianza de las flechas individuales

alrededor de la media describe la extensión. La varianza es por lo tanto una medida de

precisión.

Si el valor promedio de los datos es diferente del valor medio de la variable aleatoria, los

datos son inexactos o SESGADOS y la magnitud de la diferencia describe la cantidad de

SESGO. Basándonos en estos términos, otra forma de describir las propiedades ideales de

un estimador de recursos es sin sesgo y con un mínimo de varianza.

Un Breve Ejemplo de Promedio y Varianza.

El cálculo del promedio y la varianza de un conjunto de realizaciones de una variable

aleatoria (en forma simplificada un conjunto de datos), se lleva a cabo de la siguiente

manera:

Promedio: z z ni

i

n

/1

En palabras esta fórmula se traduce cómo: tome todos los valores de los datos,

súmelos y divídalos por el número de datos.

Varianza: 2

1

2s z z ni

i

n

( ) / (o más fácil, cálculo) 2 2

1

2

s z n zi

i

n

/

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 5

En palabras esta fórmula se traduce cómo: tome cada valor de datos,

encuentre la diferencia entre el valor y el promedio, elevar al cuadrado la

diferencia, sumar las diferencias cuadradas y dividir por el número de datos.

Las cantidades relacionadas con el promedio y la varianza son la desviación estándar (raíz

cuadrada de la varianza) y el coeficiente de variación o desviación estándar relativa

(desviación estándar dividida por el promedio). La desviación estándar y el promedio

tienen las mismas unidades de medición (por ejemplo % o g/t) mientras que el coeficiente

de variación no tiene unidad.

Como un ejemplo del cálculo del promedio y la varianza, supongamos que una muestra fue

homogeneizada y dividida en 10 sub-muestras representativas y que todas son entregadas al

mismo laboratorio. Los valores informados por el laboratorio hipotético son los siguientes:

3, 5, 4, 5, 7, 6, 5, 6, 4, 5. Para obtener una mejor idea de la información entregada por los

datos, estos puede ser escritos nuevamente.

5

5

4 5 6

3 4 5 6 7

Al inspeccionar esto, se puede notar que la tendencia central de este pequeño conjunto de

datos es 5 y, en realidad, el promedio de estos datos es 5. Observando nuevamente los

datos, podemos ver nuevamente el concepto de extensión de los datos. Los valores iguales

a 5 no tienen ninguna contribución a la extensión ya que ellos son iguales al promedio (sí

todos los 10 valores fuesen igual a 5, la extensión sería igual a cero). El par de valores 4 y

6 contribuyen a la extensión y también lo hacen los valores 3 y 7. Al encontrarse más

alejados del centro, la contribución de 3 y 7 es mayor. Por lo tanto una medida razonable

de extensión debe considerar la distancia absoluta desde el centro de los datos y debe

aumentar al aumentar la distancia desde el centro.

Este es el tipo de lógica que se encuentra en el cálculo de la varianza. Cada valor de dato

es restado del promedio y esta desviación es elevada al cuadrado. Las desviaciones al

cuadrado son entonces promediadas para formar la varianza. Las muestras individuales

pueden tener contribuciones significativas a la varianza. Al aumentar la magnitud de la

desviación, la contribución a la varianza aumenta rápidamente porque la desviación es

cuadratica. Como resultado, los valores extremos (por ejemplo, si el laboratorio devolvió 0

para una muestra, o lo más probable, si uno de los resultados fue ingresado erróneamente

como 0) pueden tener irracionalmente grandes impactos en la varianza. El manejo de

valores extremos o aislados es por lo tanto muy importante al evaluar correctamente la

varianza de un conjunto de datos.

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 6

Para el pequeño conjunto de datos considerado aquí, la varianza es la siguiente:

_______________________________________________________________________

Valor de

los

Datos ( )z i

Desviación

( )z zi

Desviación

al Cuadrado

3 -2 4

5 0 0

4 -1 1

5 0 0

7 2 4

6 1 1

5 0 0

6 1 1

4 -1 1

5 0 0

Suma 0 12

Varianza = s2 = (12)/10 = 1.2

Desviación Estándar = s 12. = 1.1

Coeficiente de Variación = s z/ = 1.1/5 = 0.22 ó 22 % (esto es muy alto e indica una

preparación de muestra deficiente o un desempeño deficiente en el laboratorio)

Comparación de Datos de Dos Laboratorios

A menudo los estándares específicos del depósito no se encuentran disponibles. En tales

casos, un procedimiento de control de calidad común es el de homogeneizar y dividir una

muestra y luego enviar las partes divididas a diferentes laboratorios. Si la división es

preparada en la forma apropiada, cada par de laboratorios debería esencialmente estar

midiendo el mismo material. Una comparación de los ensayos obtenidos por ambos

laboratorios puede ser utilizada para determinar si pudiese existir algún sesgo entre los dos

laboratorios. No es posible determinar que laboratorio se encuentra en lo correcto, pero tal

comparación puede ser utilizada para determinar la existencia de algún problema con la

calidad del ensayo. Ya que los valores correctos son desconocidos, el sesgo real no puede

ser determinado, pero una idea del sesgo puede ser obtenida a través de una campaña

“Round Robin” en donde las pulpas son enviadas a varios laboratorios de mucho prestigio

y la ley promedio obtenida por todos los laboratorios es considerada como la “verdadera”

ley de la muestra.

En un caso en donde una división es enviada a dos laboratorios, se obtienen dos resultados

por cada muestra. Si se prepara un plano bidimensional en donde las resultados

proporcionadas por el laboratorio 1 están trazadas sobre el eje X y las resultados

proporcionadas por el laboratorio 2 se encuentran presentadas sobre el eje Y, emerge un

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 7

patrón de puntos conocido como un diagrama de dispersión. El diagrama de dispersión

proporciona una representación ilustrada de una distribución bi-variada de las dos variables

aleatorias (valores de ensayo del laboratorio 1 y laboratorio 2). La distribución bi-

variada describe la relación entre dos variables. En el caso de que las dos variables estén

relacionadas, conociendo el valor de una de las variables se reduce el margen de los

posibles valores para la segunda variable. Cuando dos variables se encuentran relacionadas

en esta manera, se dice que están correlacionadas.

Al aumentar la potencia de la correlación entre las dos variables, la información sobre el

valor de una variable proporciona más información sobre el valor de la segunda variable.

La potencia de la correlación es generalmente medida por el coeficiente de la correlación

lineal. El coeficiente de la correlación fluctúa desde 0, en el caso en que no existe una

relación lineal entre las dos variables, 1.0, en el caso en que existe una correlación lineal

perfecta entre las variables (conociendo el valor de una variable se define el valor de la

otra).

El coeficiente de correlación lineal es calculado de acuerdo a lo siguiente:

r x m y m n s si x

i

n

i y x y

( ( )( )) / ( )1

donde: xi e yi son los dos valores para la muestra ith

mx es el promedio de los valores x

my es el promedio de los valores y

sx es la desviación estándar de los valores x

sy es la desviación estándar de los valores y

n es el número de valores

Los ejemplos de los diagramas de dispersión para los diferentes valores del coeficiente de

correlación se muestran en la siguiente figura. Los valores de los datos trazados sobre cada

eje tiene una varianza y promedio idénticos. Solamente el coeficiente de correlación

cambia. Fíjense que la línea más adecuada mostrada para cada gráfico (la línea de

regresión lineal) se comienza a aplanar a medida que el coeficiente disminuye. Ya que el

promedio y la varianza de estos conjuntos de datos son idénticos, la pendiente de la línea de

regresión es igual a r. Si la correlación fuese perfecta la pendiente sería 1 y todos los

puntos caerían sobre la línea Y=X. Cuando la correlación es 0, la línea de regresión es

perfectamente horizontal indicando que el valor observado de X no nos dice nada acerca de

los posibles valores de Y. En este caso siempre hay una completa falta de correlación entre

las variables y la mejor conjetura del valor de Y que podemos obtener es el promedio de

todos los valores X. En los próximos modelos, esta falta de correlación (en espacio) será

descrita como un efecto de pepita puro y se demostrará que la mejor estimación de una ley

(bajo estas circunstancias) es un simple promedio de los datos sin considerar la ubicación

de los datos.

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 8

Correlation Coefficient (r) = 0.9

X

Y

0.0

0.5

1.0

1.5

2.0

0.0 0.5 1.0 1.5 2.0

Correlation Coefficient (r) = 0.5

X

Y

0.0

0.5

1.0

1.5

2.0

0.0 0.5 1.0 1.5 2.0

Correlation Coefficient (r) = 0.7

X

Y

0.0

0.5

1.0

1.5

2.0

0.0 0.5 1.0 1.5 2.0

Correlation Coefficient (r) = 0.3

X

Y0.0

0.5

1.0

1.5

2.0

0.0 0.5 1.0 1.5 2.0

Exactitud, Precisión y Correlación

El diagrama de dispersión proporciona una representación ilustrada tanto de las relaciones

entre dos datos y, en algunos casos donde una estimación es comparada con un valor

conocido, el diagrama de dispersión proporciona información tanto de la exactitud como de

la precisión. Consideremos un caso en donde los estándares se encuentren disponibles en

cierto margen de leyes o, lo más probable, una comparación de la ley de bloque estimada

con la ley conocida según lo definido por el muestreo de pozos de tiro. Una línea de 45°

(equivalente a Y=X) puede ser dibujada en el diagrama de dispersión para demostrar el

lugar en donde caerían los puntos de los datos si el estimador o el laboratorio fuesen

perfectos y siempre entregasen el valor correcto. Asumiendo que las cosas no son

perfectas, se pueden ver dos tipos de errores. Si los puntos caen a lo largo de una línea

diferente a la línea de 45°, entonces existe un sesgo o equivalentemente un problema de

exactitud. El ancho de la dispersión de los puntos representa la variabilidad de los datos y

va unido a la precisión del estimador o el laboratorio.

Existe un número de métodos para calcular la precisión representada por los datos bi-

variados. Todos estos métodos tienen una fuerte asociación con la correlación ya que

cuando la correlación aumenta, la dispersión disminuye y la precisión mejora. Un método

de medición de correlación o precisión análogo a la varianza descrito para un dato

dimensional puede ser creado suponiendo primero que el diagrama de dispersión estuviese

centrado a alrededor de la línea de 45° representando al estimador perfecto. La distancia

perpendicular desde cada punto del diagrama de dispersión hasta la línea desde cada punto

del diagrama de dispersión hasta la línea de 45° representa entonces la desviación desde la

tendencia central. La varianza de los puntos cerca de la línea pueden ser calculados

utilizando el mismo método utilizado para los datos uni-variables. En la trigonometría

(véase ilustración), la desviación para un punto específico sobre el gráfico desde la línea

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 9

Y=X es igual a 2 (yi - xi)/2; en donde yi y xi son los valores

de los datos para el punto. Al aplicar la definición de la varianza, las desviaciones son

elevadas al cuadrado y promediadas. La medida de incertidumbre derivada en esta forma

es expresada como:

= ( (yi - xi)2)/2n

donde () es la medida de precisión o correlación

yi y xi son un par de datos específicos

n es el número total de datos

En las próximas secciones esta medida de correlación () será introducida nuevamente

como la función de variograma y será utilizada para medir la correlación espacial de

medición.

EJEMPLO DE DESVIACION DE Y = X

X

Y

0

1

2

3

4

5

6

7

8

0 1 2 3 4 5 6 7 8

(xi,y

i)

Length = xi - y

i

45°

Deviation

Los pares de valores del gráfico anterior pueden ser utilizados para ilustrar los métodos de

estimación de correlación. Los datos y sus estadísticas de resumen son los siguientes:

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 10

x Y x-mx y-my (x-mx)•

(y-my)

(x-y)2

1 2 -2.9 -1.9 5.51 1

3 2 -0.9 -1.9 1.71 1

5 7 1.1 3.1 3.41 4

7 5 3.1 1.1 3.41 4

4 2 0.1 -1.9 -0.19 4

3 5 -0.9 1.1 -0.99 4

2 5 -1.9 1.1 -2.09 9

6 3 2.1 -0.9 -1.89 9

3 2 -0.9 -1.9 1.71 1

5 6 1.1 2.1 2.31 1

Suma 12.9 40

mx = 3.9

my= 3.9

sx = 1.75

sy = 1.81

n = 10

De acuerdo a esta información el coeficiente de correlación y el valor del variograma puede

ser calculado como: r = 12.9/(10)(1.75)(1.81) = 0.41

= 40/(2)(10) = 2.0

Nótese que al disminuir la correlación el coeficiente de correlación también disminuye. El

valor del variograma, sin embargo, aumenta. El coeficiente de correlación no tiene unidad.

Una medida de correlación que es similar al coeficiente de correlación pero expresada en

las mismas unidades de la varianza o variograma es conocida como la co-varianza. La co-

varianza (esencialmente el numerador en la expresión para el coeficiente de correlación)

será analizada en más detalle en la sección sobre correlación espacial.

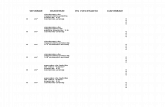

Sesgo Condicional

A menudo, los puntos dentro de un diagrama de dispersión muestran un patrón que es una

función de la ley. Esto se ve comúnmente en los estimadores. Al comparar las

estimaciones de ley de bloque con los valores conocidos de los bloques, las leyes reales de

los bloques de menor ley son a menudo subestimados (la ley real del bloque es mayor que

la ley estimada) y los bloques de alta ley son a menudo sobrestimados (la ley real del

bloque es menor que la ley estimada). Este tipo de patrón es conocido como SESGO

CONDICIONAL; lo que significa que el sesgo no es consistente o constante. En este

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 11

caso, el sesgo es una función de la (o condicional a la) ley. Debido a que el sesgo

condicional es una función de la ley y puede ser positivo o negativo, no es inusual para un

estimador no sesgado global (sin sesgo sobre el margen de ley completo), encontrarse

condicionalmente sesgado.

Para estimar la cantidad de sesgo condicional, el valor promedio de la variable trazada

sobre el eje Y puede ser determinado para varios intervalos consecutivos de ley del eje X.

Al conectar los puntos representando las leyes promedio de intervalos de ley y al comparar

la línea resultante con la línea de 45 grados que define a un estimador perfecto se muestra

la magnitud del sesgo condicional. La siguiente figura representa los resultados de

estimación de ley de bloque para dos técnicas diferentes de “kriging”. Por lo general

ambos estimadores determinarán esencialmente la misma ley. Debido a que cada

estimador se encuentra globalmente no sesgado, este resultado es esperado. A pesar de la

falta de sesgo global, existe un sesgo condicional significativo entre los estimadores. La

importancia del sesgo condicional es que siempre que se imponga una ley de corte el

margen de ley completo no es ponderado. Una vez que la ley de corte se aplica, el sesgo

condicional se convierte en algo muy importante. Un estimador sesgado condicionalmente

no puede estimar correctamente la ley o tonelaje real que será extraída. En las próximas

secciones, los asuntos asociados con estimadores sesgados condicionalmente serán

discutidos con más detalle.

Comparación de Estimadores

Conditional Kriging Estimate (g/t)

Ordinary K

riging (g/t)

0

4

8

12

16

20

24

0 4 8 12 16 20 24

Average Std. Dev.

OK 2.7 1.9

IK 2.8 2.2

Conditional Average Curve

Magnitude of Conditional Bias

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 12

Observaciones

El asunto de la incertidumbre debido al muestreo o ensayo es un campo mucho más

extendido y un tema más amplio de lo que se pueda discutir aquí. Existe un cierto número

de factores que

contribuyen a la variabilidad observada en un conjunto de datos. Además del error de

ensayo que fue discutido aquí, existe también un error de preparación de muestras, error de

muestreo y, algo muy importante, la variabilidad de las leyes que se encuentran siendo

estudiadas. En los depósitos donde el elemento de interés es encontrado en la ley muy alta

pero en grupos volumétricamente pequeños (por ejemplo las pepitas de oro) las diferencias

encontradas en las leyes de cada mitad de testigo dividido pueden ser significativamente

diferentes. Este tipo de variabilidad en conjunto con todos los otros tipos de variabilidad

discutidos aquí es capturado por la geoestatística dentro del “efecto de pepita ” que será

descrito en secciones posteriores.

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 13

Módulo 1.2 - ¿Son los Datos Representativos?

Introducción

La mayoría de las decisiones realizadas al determinar si se invierte en un proyecto minero o

no, están basadas en interpretaciones hechas a partir de un conjunto de datos. En este

módulo, se considerarán asuntos como “¿Qué significan estos datos y en que se basan las

decisiones de inversiones?”. Cada muestra adquirida representa un volumen específico del

depósito. De los pequeños volúmenes de muestras recolectadas, se infiere con respecto a

las toneladas y la ley que podrían ser extraídas y las potenciales ganancias de la extracción.

Debido a las extrapolaciones que se harán y las subsecuentes consecuencias económicas de

las decisiones basadas en estas extrapolaciones, es de extrema importancia que los datos

sean representativos del depósito y que las incertidumbres controlables, causadas por

diferentes volúmenes de muestreo o sesgos de la perforación preferencial, no impacten la

estimación del recurso.

En este módulo, los impactos de los diferentes volúmenes de muestras y de las

perforaciones espaciadas en forma irregular sobre la estadística (promedio y varianza)

presentados en el primer módulo serán discutidos y se presentarán métodos para corregir

los efectos de una escasa representatividad de muestras.

Antecedentes / Teoría

Tamaño de Muestra

Una vez que una muestra es preparada en la forma apropiada, homogeneizada y reducida y

el laboratorio ejecuta correctamente un ensayo, el valor del ensayo representa la ley

promedio del volumen de la muestra. El mismo volumen de muestra podría haber sido sub-

muestreado y ensayado para determinar las leyes representativas de las sub-muestras.

Debido a una variedad de razones incluyendo la variabilidad inherente dentro del volumen

de muestras original, las variaciones en el tamaño de partícula, los procedimientos de sub-

muestreo y los ensayos, los valores de ensayo de las sub-muestras no serán idénticos y la

varianza de los ensayos de sub-muestras será mayor que cero. Esta varianza vista en los

ensayos de las sub-muestras se pierde completamente al examinar solamente la ley de

muestra que representa al volumen completo. Sin embargo, la ley informada de la muestra

debe ser idéntica a la ley promedio de las sub-muestras. Dentro del volumen de muestra

original, las leyes de sub-muestras contribuyen a la ley promedio pero debido a que sólo

una sola muestra homogeneizada es enviada para ensayo, las sub-muestras homogeneizadas

no pueden contribuir a la variabilidad.

Como un resultado de la promediación de la ley que ocurre dentro de un volumen es muy

razonable que la variabilidad disminuya al aumentar el volumen de la muestra. Como un

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 14

ejemplo, considere los siguientes ensayos hipotéticos de un testigo con una perforación de 1

metro desde un solo sondaje. Primero, la varianza de los ensayos es calculada sobre los

largos de muestra de 1 metro. Luego las muestras son combinadas en largos de 2, 4 y 8

metros y la varianza es calculada nuevamente. Nótese que no importa cómo estén

combinados los datos, la ley promedio no cambia.

1.0 0.9 0.7 1.3 1.2 0.6 2.0 0.8 1.4 1.1 0.3 1.2 1.3 0.5 1.1 0.9 :1 m largo, s2 = 0.166, x_

= 1.02 \ / \ / \ / \ / \ / \ / \ / \ /

0.95 1.0 0.9 1.4 1.25 0.75 0.9 1.0 :2 m largo, s2 = 0.043, x_

= 1.02 \ / \ / \ / \ /

0.975 1.15 1.0 0.95 :4 m largo, s2 = 0.008, x_

= 1.02

\ / \ /

1.06 0.975 :8 m largo, s2 = 0.004, x_

= 1.02

El cambio en varianza con el tamaño de muestra que se ilustra aquí es comúnmente

denominado el efecto de soporte. Según se muestra por medio del cambio en la varianza

con tamaño de muestra, las muestras definidas sobre diferentes soportes no son

comparables. Cada vez que las estadísticas son calculadas, las muestras deben tener ya sea

el mismo soporte o/tamaño de muestra en caso contrario, se deben tomar medidas para

corregir diferencia en soporte. Sin una corrección para el soporte de las muestras, las

estadísticas resultarán sesgadas.

Existen dos métodos para tomar en cuenta del efecto de soporte al calcular las estadísticas.

Las muestras pueden ser ponderadas por el largo de la muestra en todos los cálculos o las

muestras pueden ser puestas todas bajo las mismas condiciones de largo compositando

sobre largos iguales. La compositacion es la práctica más común ya que es muy tedioso

considerar el factor de pesaje a través de todos los cálculos, además, la forma de “kriging”

encontrada en paquetes de software comúnmente disponibles supone muestras de soporte

constante. Por estas razones, se recomienda muy especialmente que los ensayos sean

compositados sobre largos iguales antes de cualquier estudio estadístico sobre la estimación

de recursos.

El efecto de soporte visto con las muestras también se aplica a la calidad de las

estimaciones de recursos. Como se ha demostrado, al aumentar el volumen la variabilidad

disminuye. Por lo tanto la variabilidad de las leyes mensuales en una operación es mucho

menor que la variabilidad de las leyes diarias en la misma operación; por lo tanto, de ello se

deriva que la estimación de las leyes mensuales es mucho más fácil que la estimación de las

leyes diarias. El concepto de una relación entre el volumen y la varianza es uno de los más

importantes en geoestadística por lo tanto este tema será revisado nuevamente en los

futuros módulos.

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 15

Ubicación de las Muestras

Al calcular la ley promedio de un conjunto de datos, existe un peso igual aplicado a cada

uno de los datos. Al calcular el promedio, los datos son meramente sumados y luego

divididos por el número de datos. Esto equivale a multiplicar cada ley de muestra por un

peso igual a 1 dividido por el número de datos (1/n) y luego sumar el peso por el producto

de la ley. Al calcular este tipo de promedio simple, se supone implícitamente que cada

muestra representa un volumen igual del depósito. Cuando esta suposición es incorrecta,

las estadísticas calculadas estarán sesgadas y no representarán correctamente el depósito.

Siguiendo la mayoría de los programas de perforación, las muestras no representan

volúmenes iguales. Un ejemplo claro de esto es un depósito perforado en dos mallas

diferentes. Una malla podría, por ejemplo, ser la malla de exploración inicial. En una

segunda fase de la perforación, siguiendo a una evaluación de los datos, una malla más

densa podría ser perforada sobre una porción de ley más alta del depósito en un esfuerzo

para mejorar la calidad del deposito. El perforar en una malla más densa dispone más

perforaciones en una porción particular del depósito. Debido a que hay mas perforaciones

en esta área, cada perforación en el área densamente perforada representa un volumen

menor que las perforaciones sobre la malla inicial. Si se lleva a cabo un promedio simple

de igual peso, las muestras de la porción de alta ley densamente perforada del depósito

recibirá un peso mayor que su volumen de influencia. Como resultado, la ley promedio de

la porción densamente perforada del depósito se encontrará sobre-representada en el

cálculo de la ley promedio del depósito completo y la ley estimada del depósito será mayor

que la ley promedio real del depósito. Para ilustrar el problema consideremos el siguiente

programa simple de perforación en dos etapas.

Como se muestra en las dos

ilustraciones, el primer

programa de perforación

identificó una ley

irregularmente alta en la

ubicación 400 E; 400 N.

Para confirmar los resultados

del primer programa y para

definir mejor el área

anómala, se completó una

segunda fase limitada de

perforación consistente en 4

perforaciones agrupadas

alrededor del valor anómalo.

Según se muestra, la segunda

fase de la perforación

también encontró leyes

elevadas.

Las leyes promedio sin

Resul tados de Perforaci ón - Etapa 1

Local G r id East ing ( m)

Loca

l Grid

Nor

thing

(m

)

. 11

. 50

. 62

. 82

. 18

1. 36

. 13

. 38

. 44

. 35

. 87

. 49

. 37

. 21

. 16

. 95

100

200

300

400

500

600

700

800

900

100 200 300 400 500 600 700 800 900

Resul tados de Perforaci ón - Etapa 2

Local G r id East ing ( m)

Loca

l Grid

Nor

thing

(m

)

. 11

. 50

. 62

. 82

. 18

1. 36

. 13

. 38

. 44

. 35

. 87

. 49

. 37

. 21

. 16

. 95

1. 07

. 84

. 92

1. 61

100

200

300

400

500

600

700

800

900

100 200 300 400 500 600 700 800 900

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 16

ponderar, para todas las perforaciones, en la completación del primer y segundo programa

de perforación son 0,50% y 0,62% respectivamente. Aparentemente, el hacer 4

perforaciones adicionales ha elevado la ley promedio de todo el depósito en 25%. En la

realidad, la porción densamente perforada ( y de ley superior) del depósito se encuentra

sobre-representada en el cálculo de la ley promedio y proporciona una impresión

excesivamente optimista de la ley general del depósito. Un promedio apropiado, ponderado

espacialmente, de estos datos proporciona un promedio estimado de 0,50% (véase los

siguientes párrafos) que es idéntico a la ley promedio estimada del primer programa de

perforación. Como lo demuestra este pequeño ejemplo, un ascenso artificial de la ley de

un depósito puede ocurrir fácilmente debido al agrupamiento de muestras en áreas de alta

ley. Para evitar las consecuencias económicas de una tergiversación de la ley del depósito,

se requiere de una ponderación espacial para considerar la influencia de un dato en la ley

promedio general de acuerdo con el volumen de influencia de cada muestra. Existen

muchos métodos para calcular los ponderadores apropiados y representativos de las

muestras.

Manejando Datos Agrupados

Hay una forma muy simple de manejar datos agrupados en los casos tales como el que

acaba de ser discutido. Cuando las muestras son recolectadas primitivamente sobre una

malla regular con sólo unas pocas agrupaciones adicionales, las agrupaciones pueden ser

extraídas y se puede calcular un promedio utilizando sólo los datos regulares de la malla.

En el ejemplo anterior, este procedimiento significa utilizar solamente los datos de la Etapa

1 para el cálculo de la estadística. Este procedimiento simple tiene la desventaja obvia de

los datos descartados. También, muchos conjuntos de datos no incluyen una malla regular

fácilmente identificable. Por esta razón, este método es utilizado solamente en los casos

más simples. En los casos más difíciles, se requiere uno de los siguientes métodos.

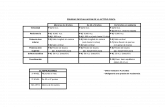

Polígonos de Influencia

En dos dimensiones, la técnica de los polígonos de influencia ha sido utilizada por muchos

años para definir el peso espacial de las muestras. Para aplicar esta técnica, las líneas son

dibujadas conectando una perforación con todas las perforaciones vecinas. Los bisectores

perpendiculares son trazados a través de cada línea de conexión. Las líneas bisectoras

forman polígonos alrededor de cada perforación (véase la siguiente ilustración). Los

bordes de los polígonos se encuentran ubicados a medio camino entre cada par de muestras

vecinas para que el polígono defina su extensión de influencia de la muestra. El área del

polígono de influencia dividido por el área total del depósito determina el peso aplicado a

cada muestra. Las muestras al borde del depósito o del patrón de perforación requieren

un tratamiento especial. Debido a que no hay datos vecinos al borde del depósito, los

polígonos de influencia no pueden ser definidos siguiendo el método anteriormente

descrito. Para las perforaciones fronterizas el polígono es típicamente cerrado utilizando un

círculo con un radio igual a un medio hasta tres cuartos del espaciamiento de perforación

promedio.

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 17

Construcción de un Polígono de Influencia

Polygon of Influence

Step 3

Line Segments Connecting

Drillhole Collars

Step 1

Perpendicular Bisectors ofthe Line Segments

Step 2

Drillhole Collars

Sample Locations

Una vez que los polígonos son definidos para cada muestra, la ley de depósito promedio es

calculada utilizando el área de cada polígono para definir el peso a aplicar para cada dato

utilizando la siguiente fórmula.

z A A zi t ii

n

( / )1

donde: Ai está el área de influencia asociada con el dato ith

At es el área total del depósito

zi es la ley del dato ith

El enfoque del polígono de influencia funciona bastante bien en tres dimensiones cuando

todas las perforaciones son verticales; sin embargo, cuando se utilizan las perforaciones en

ángulo o la deflexión es significativa, los polígonos de influencia (para cada perforación)

cambian de nivel a nivel del depósito. El método por lo tanto se vuelve algo tedioso y

difícil de implementar en tres dimensiones.

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 18

El Método de Malla

El método de malla es un método que alcanza la misma meta que los polígonos de

influencia pero que puede ser fácilmente aplicado en tres dimensiones. En este enfoque, se

crea una malla de puntos tridimensional del tamaño adecuado (típicamente de un cuarto a

un octavo de espaciado de perforación primario) que cubre el depósito. Para cada punto de

la malla, se encuentra la muestra más cercana y la ley de la muestra es asignada al punto de

la malla. Debido a que los puntos de la malla están, por definición, regularmente

espaciados, ellos representan volúmenes iguales del depósito. El promedio o cualquier otra

estadística calculada sobre los puntos de la malla es por lo tanto espacialmente

representativo del depósito y las estadísticas calculadas sobre esos datos no son sesgadas.

Para los grandes depósitos este enfoque puede ser computacionalmente intensivo, sin

embargo los PCs disponibles hoy en día pueden fácilmente manejar este problema.

El método de malla puede también ser utilizado para distribuir variables categóricas (por

ejemplo la litología, la alteración, la mineralogía, etc.) a través del depósito sin sesgo

mientras se le es fiel a los datos. La alteración o litología específica para un punto de la

malla es simplemente tomada de la muestra más cercana. El método de búsqueda utilizado

para asignar los valores a los puntos de la malla no necesita ser círcular. Si se sabe que las

unidades geológicas siguen una orientación particular o las unidades tienden a seguir una

forma en particular entonces la dirección y la orientación de búsqueda pueden ser

cambiadas para acoger esta información. A pesar de estas mejoras en el procedimiento,

generalmente se prefiere utilizar la interpretación espacial del geólogo para estas variables.

Por esta razón, este enfoque es utilizado solamente cuando las interpretaciones geológicas

no se encuentran disponibles o cuando sólo se requiere un primer examen visual rápido al

depósito.

Desagrupamiento de Celdas

Otro enfoque al cálculo de pesos que definirán un promedio representativo espacialmente

es la técnica de “desagrupamiento” de celdas. Con esta técnica, una red de celdas

regulares es localizada sobre el depósito y se cuenta el número de muestras ubicado dentro

de cada celda. Ya que las celdas en áreas densamente muestreadas contendrán más

muestras, el número de muestras contadas por celdas se encontrará inversamente

relacionado a la densidad de las muestras. Un factor de ponderación de uno dividido por el

número de conteos por celdas, es por lo tanto, una simple manera de eliminar los efectos de

densidades de datos desiguales. Debido a que los ponderadores deben sumar uno para

evitar el sesgo de las estadísticas, el inverso de los conteos por celdas debe ser

estandarizado para obtener el peso real. La formula de ponderación es:

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 19

w nc nci i i

i

n

( / ) / ( / )1 11

donde: nci representa el número de datos ubicados en las celdas

conteniendo los datos ith

wi es el peso aplicado al dato ith al calcular el promedio

ponderado nótese que 11

/ nci

i

n

es igual al número total de celdas

que contienen datos

Las celdas desagrupadoras pueden tener cualquier tamaño, pueden ser rectangulares o

cuadradas, y pueden ser bidimensionales o tridimensionales. Es difícil establecer reglas

especificando el tamaño de celdas óptimo, pero es muy cierto que la eficiencia del

desagrupamiento es una función del tamaño de las celdas. A menudo se utiliza un

procedimiento de tanteo para encontrar el mejor tamaño y forma. Al seleccionar el margen

de los posibles tamaños existen unas pocas reglas que pueden ayudar. Primero, si el

tamaño de las celdas es demasiado grande o demasiado pequeño no habrá ningún

desagrupamiento. Por ejemplo, si el tamaño de las celdas fuese del mismo tamaño del

depósito, todas las muestras caerían dentro de las celdas y todos los datos recibirían pesos

iguales. En forma similar, si el tamaño de celdas fuese más pequeño que el espaciamiento

de las perforaciones, la mayoría de las celdas estarían vacías y las celdas restantes

contendrían una sola muestra. Nuevamente todos los datos recibirían pesos iguales y no

habría ningún desagrupamiento.

El mejor tamaño de celdas para el desagrupamiento es claramente algo entre estos dos

extremos. Si se sabe que los datos están agrupados en porciones de alta ley del depósito,

entonces es razonable suponer que el tamaño de celdas de desagrupamiento más eficiente

proporcionaría la ley promedio más baja para el depósito. La lógica que subyace a esta

afirmación es que el agrupamiento en las zonas de leyes altas llevan a una sobre-

representación de estas zonas al calcular la ley promedio lo cual hace que la ley promedio

calculada exceda la verdadera ley promedio del depósito. Como se ha descrito

anteriormente, cuando las celdas son demasiado pequeñas o grandes el desagrupamiento es

mínimo y el promedio será sobre estimado. Para los tamaños de celdas entre los dos

extremos, el desagrupamiento disminuye el impacto de las diferentes densidades de

muestras en las estadísticas y las leyes promedios decaerán. Un gráfico de ley promedio

versus el tamaño de celdas puede identificar el tamaño de celdas que proporciona la ley

mínima. Este procedimiento de tanteo define un tamaño de celdas “óptimo”. Un ejemplo

de un gráfico de ley promedio vs el tamaño de celdas es presentado en la siguiente

aplicación. La práctica ha demostrado que el mejor tamaño de celdas tiende a ser igual al

tamaño de los agrupamientos (si se encuentran agrupaciones discretas) o el tamaño del

programa de perforación original en el caso de que se haya desarrollado un programa de

perforación de relleno simple.

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 20

Aplicaciones

Cómo un ejemplo de aplicación de las variadas técnicas para calcular la ley promedio no

sesgada de un conjunto de datos considere el siguiente ejemplo de resultados de

perforaciones. Cada uno de los puntos en la figura representa el collar de una perforación.

La ley promedio simple de todos los datos de la campaña es de 0.70%. Los símbolos

cuadrados son utilizados para apuntar a las perforaciones que se encuentran ubicadas sobre

una malla regular de 200 metros. A pesar de que este es un pequeño conjunto de datos, se

encuentran espaciados regularmente y por lo tanto no hay sesgo. El tomar la ley promedio

de muestras de

solamente las

perforaciones sobre la

malla de 200 metros,

proporciona una ley

promedio estimado de

0.52%. Ignorando el

agrupamiento de los

datos y tomando un

promedio directo de los

datos, por lo tanto,

aumenta artificialmente

la ley promedio del

depósito en 35%. La

razón de la diferencia

en ley es que la porción

de ley alta del depósito

(mostrada en la ilustración como sondajes conteniendo más de 1%) ha sido sobre

muestreada por un agrupamiento de perforaciones en la vecindad de 400E, 400N. Una

promediación igual de leyes sobre este patrón de muestreo proporciona una estimación

irrealmente alta de la ley promedio.

Para eliminar los efectos de las perforaciones agrupadas, se utilizará primero el método de

desagrupamiento de celdas.

Como se ha discutido, el

tamaño de celdas más

apropiado es a menudo difícil

de determinar sólo con mirar el

patrón de perforación. Según

lo descrito anteriormente,

cuando el tamaño de celdas es

demasiado pequeño o

demasiado grande ocurre un

desagrupamiento mínimo y la

ley promedio se convierte en

algo muy similar al

promedio directo de los datos.

Si existen agrupamientos en

Ubicaciones de Datos

0

200

400

600

800

1000

0 200 400 600 800 1000

Drillhole CollarDrillhole on GridGrade Above 1%

Average Grade By Cell Size

Cell Size (m)

Average Gra

de (%)

0.40

0.45

0.50

0.55

0.60

0.65

0.70

0.75

50 100 150 200 250 300 350 400 450

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 21

las áreas de alta ley (cómo lo hacen en este ejemplo), el desagrupamiento más efectivo

ocurre para el tamaño de celdas que minimiza la ley. Para este ejemplo, se utilizaron celdas

cuadradas variando en tamaño desde 100 a 400 metros. Para cada tamaño de celdas, el

número de muestras por celdas fue contado y los pesos fueron determinados por medio de

la aplicación de la formula de desagrupamiento de celdas presentada anteriormente. Las

leyes promedio resultantes para el depósito fueron entonces dibujadas vs el tamaño de

celdas. La ley promedio estimada para el depósito se minimiza para un tamaño de celdas

de 300 metros por lo tanto se selecciona este como el tamaño más eficiente de celdas de

desagrupamiento. La ley promedio del depósito definido por desagrupamiento de celdas es

de 0,52%.

El polígono de influencia y los métodos de malla son muy similares. La mayor diferencia

entre los métodos es el tratamiento de los datos ubicados a lo largo de los márgenes del

depósito. Para este ejemplo, los polígonos fueron completados utilizando un círculo de

radio de 125 metros cada vez que el polígono no podía ser cerrado por los datos vecinos

(véase ilustración). Para el método de malla, una malla de 5 metros fue ubicada dentro de

un rectángulo definido por las esquinas (-25, 100) y (1100, 920). Se le asignó la ley del

vecino más próximo a cada nodo de

malla. Los márgenes del depósito podrían haber sido definidos en forma más exacta

utilizando un borde ubicado a una distancia fija desde los puntos extremos, pero esta

sofisticación adicional no cambiará los resultados en forma significativa. Las leyes

promedio del depósito determinados por el polígono y los métodos de malla son 0,54% y

0,51% respectivamente.

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 22

Los cuatro métodos utilizados aquí para eliminar el sesgo introducido por el patrón de

perforación agrupado arrojan todos resultados entre 0,51% y 0,54%. Todas estas

estimaciones son de alrededor de 35% más bajos que el promedio simple no ponderado de

los datos (0,70%). La conclusión obtenida es que cualquier procedimiento sensato puede

ser utilizado para extraer los efectos de los agrupamientos desde los estimados de ley

promedio. Sólo debemos asegurarnos de que uno de estos procedimientos sea utilizado y

de que las leyes promedio establecidas no sean sesgadas por la densidad de la muestra.

Comentarios

La ponderación de las muestras que da cuenta de las agrupaciones es sólo un asunto de

importancia al calcular estadísticas en una forma que no considere específicamente el

componente espacial de los datos (por ejemplo el promedio no ponderado y la varianza del

depósito completo). Los métodos geoestadísticos de la estimación de recursos, como por

ejemplo el kriging, incorpora específicamente las características espaciales de los datos; por

lo tanto, no se requiere ponderar para dar cuenta de las irregularidades del espaciamiento.

En el desagrupamiento de celdas, no hay ninguna razón por la cual la celda deba ser un

cuadrado. Un ejemplo gráfico de la definición del tamaño óptimo de la celdas de

desagrupamiento en dos dimensiones es presentado en Isaaks y Shrivastava. En este

ejemplo, la ley desagrupada promedio se contornea para varios tamaños de celdas

desagrupantes (los ejes X e Y son los tamaños de celdas en esas direcciones, la ley

promedio de depósito es situado en las coordenadas X, Y las que corresponden al tamaño

de la celdas, luego se interpola). Ya que este ejemplo supone un muestreo agrupado de las

porciones de alta ley del depósito, el mínimo en este conjunto de isovalores de ley media

es considerado como el tamaño de celdas óptimo. En este ejemplo específico, el tamaño de

celdas óptimo es rectangular en lugar de cuadrado.

Antes de aplicar ninguna de las técnicas de desagrupamiento descritas aquí, se debe

efectuar una detallada evaluación de la distribución espacial de los datos. Se deben utilizar

ubicaciones de los datos (exhibiendo la ley compuesto por perforación en el mapa de

ubicación 2D) para reconocer sectores de alta y baja ley del depósito. En el mapa de

ubicación pueden ser sobrepuestas la litología o mapas de la distribución de otras variables

de control para investigar y evaluar tendencias espaciales y asociaciones o recoger

cualitativamente relaciones entre leyes y las variables de control. La información contenida

en una ubicación de datos puede ser aumentada a través del uso del color (para mostrar

diferentes márgenes de ley, por ejemplo) o diferentes símbolos para mostrar diferentes

litologías o tipos de alteración.

Los mapas de isovalores de leyes también pueden resultar ser muy útiles al definir las

tendencias de ley. Los isovalores pueden ser generados automáticamente a través de un

programa computacional o en forma manual. El uso principal de los isovalores es el de

indicar tendencias espaciales en las leyes u orientaciones preferidas. Ya que las tendencias

son a menudo asociadas con los controles geológicos, es generalmente preferible dejar que

el geólogo de proyecto confeccione el mapa de isovalores.

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 23

El software para desagrupar se encuentra disponible desde varias fuentes. Una rutina de

desagrupamiento es incluida en el paquete de software de GSLIB de dominio público

(Deutsch y Journel). El polígono de las rutinas de influencia puede ser difícil de encontrar.

Una posibilidad es el paquete de software comercial Techbase que contiene una rutina de

polígono. Cualquier paquete de software que contenga un módulo de modelación de

bloques puede ser utilizado para implementar la rutina de malla. Simplemente convierta los

bloques en puntos y defina que sólo una muestra sea utilizada en la estimación.

La siguiente tabla nos muestra los datos utilizados en la aplicación de desagrupamiento en

conjunto con los pesos asignados por la celdas, polígono y métodos de malla. Al examinar

los pesos, el peso del polígono y la malla son muy similares. El ponderador del método de

celdas es a menudo bastante diferente. Al concentrarse en las leyes más altas (en la parte

inferior de la tabla) aparece que todos los valores mayores que 1.25% están ubicados en la

misma celdas y reciben el mismo peso al aplicar el método de celdas. Los métodos de

malla y polígono proporcionan diferentes pesos para estos datos ya que estos métodos

tienen un nivel más alto de resolución. El método de celdas simplemente cuenta el número

de datos dentro de un gran volumen y asigna el mismo peso mientras que los otros métodos

proporcionan resultados superiores; sin embargo, este ejemplo (y otros ejemplos prácticos)

demuestran que todos los métodos tienden a proporcionar los mismos resultados.

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 24

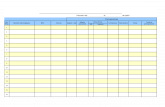

Datos Utilizados para Ilustrar el Desagrupamiento y Pesos Asignados por varios

Enfoques.

Coordina Grados Esquemas de Ponderación

X Y

300m

Celdas

Polígonos Malla

200 200 0.11 0.050 0.041 0.037

102 345 0.11 0.025 0.024 0.024

400 600 0.13 0.025 0.023 0.020

326 654 0.14 0.025 0.016 0.014

800 600 0.16 0.017 0.042 0.046

937 748 0.16 0.100 0.050 0.086

400 200 0.18 0.033 0.031 0.024

291 278 0.19 0.050 0.020 0.017

800 400 0.21 0.025 0.038 0.052

739 465 0.21 0.025 0.021 0.018

600 400 0.35 0.025 0.030 0.025

475 486 0.35 0.010 0.009 0.008

895 230 0.36 0.033 0.043 0.078

400 800 0.38 0.025 0.039 0.035

800 200 0.38 0.033 0.041 0.033

317 772 0.38 0.025 0.021 0.019

600 200 0.44 0.033 0.039 0.033

508 215 0.45 0.033 0.020 0.017

608 746 0.47 0.017 0.026 0.023

600 800 0.49 0.017 0.029 0.026

200 400 0.5 0.025 0.024 0.021

66 300 0.51 0.025 0.035 0.034

200 600 0.62 0.033 0.026 0.025

158 544 0.62 0.025 0.032 0.043

200 800 0.82 0.033 0.031 0.028

111 853 0.85 0.033 0.046 0.043

651 551 0.86 0.025 0.018 0.015

600 600 0.87 0.017 0.024 0.020

740 833 0.92 0.017 0.031 0.022

800 800 1.1 0.017 0.029 0.027

350 450 1.11 0.010 0.006 0.005

460 285 1.2 0.033 0.013 0.011

450 450 1.26 0.010 0.007 0.006

339 458 1.34 0.010 0.015 0.012

350 350 1.4 0.010 0.013 0.011

339 599 1.5 0.010 0.012 0.010

400 400 1.56 0.010 0.006 0.006

459 466 1.6 0.010 0.004 0.003

541 484 1.7 0.010 0.014 0.012

450 350 1.88 0.010 0.012 0.009

Suma de Pesos 1.000 1.000 1.000

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 25

Módulo 1.3 - Distribuciones Estadísticas Introducción

En el módulo 1.1, se definió una variable aleatoria como una variable que toma valores al

azar, con frecuencias especificadas por una función de probabilidad. Los métodos para

resumir el margen de los valores tomados por una variable aleatoria han sido descritos, así

como también los métodos de asegurar que las mediciones individuales sean

representativas. En este módulo, los métodos para representar y analizar toda la

distribución de leyes serán evaluados. Además, algunos modelos de distribución comunes

serán discutidos. Utilizando los modelos de distribución, métodos para evaluar un

conjunto de datos para determinar si se encuentran presentes mezclas de datos siguiendo las

diferentes distribuciones o datos de una ley alta anormal (“outliers”)

Antecedentes / Teoría

Para ilustrar el concepto de variable aleatoria se proporcionan unos pocos ejemplos. Para

cada ejemplo, se describe la variable y su función de probabilidad. Siguiendo a los

ejemplos, se proporcionan los métodos que describen como utilizar los datos para inferir las

propiedades de la función de probabilidad subyacente.

Un Ejemplo Simple

Un ejemplo de una variable aleatoria es el número que aparece después de tirar un sólo

dado. Si el dado no está cargado, todos los seis números tienen una oportunidad igual de

aparecer en cualquier jugada. Esto significa que la oportunidad de observar, digamos el

número 3 en cualquier oportunidad en que se arroja el dado es 1 en 6, o lo que es lo mismo,

la probabilidad de observar 3 es 1/6 (0,167). Debido a que todos los otros números

posibles son igualmente probables, la función de probabilidad que describe esta variable

aleatoria es bastante simple y puede ser expresada de la siguiente forma:

Pr( ) / ; , , , , ,Z z zi i 1 6 1 2 3 4 5 6 .

Este tipo de distribución es

conocido como uniforme.

Un gráfico de barra de las

probabilidades versus los

resultados ayuda a explicar

este nombre.

Gráfico de Barra de Probabilidades

Outcomes From Throwing 1 Die

Outcomes

Probability

1/6

1 2 3 4 5 6

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 26

Un Ejemplo Más Complicado

Supongamos que dos dados son arrojados en lugar de uno y la variable aleatoria de interés

es la suma de los dos números observados. Antes de definir los posibles resultados, es

importante notar que los valores tomados por cada uno de los dados no están

correlacionados. Esto quiere decir que el saber el valor de uno de los dados no proporciona

absolutamente ninguna información acerca del valor que pudiese aparecer en el otro dado.

Debido a que cada dado toma los valores independientemente de 1 a 6 existen 6 veces 6 o

36 formas posibles en las que el dado puede caer y cada uno de los 36 resultados son

igualmente probables. La función de probabilidad puede ser definida simplemente

haciendo un listado de todos los 36 resultados, sumando los dos valores de cada dado y

contando las probabilidades para cada resultado. Los posibles resultados son los siguientes:

Dado

1

Dado

2

Dado

1

Dado

2

Dado

1

Dado

2

Dado

1

Dado

2

Dado

1

Dado

2

Dado

1

Dado

2

1 1 2 1 3 1 4 1 5 1 6 1

1 2 2 2 3 2 4 2 5 2 6 2

1 3 2 3 3 3 4 3 5 3 6 3

1 4 2 4 3 4 4 4 5 4 6 4

1 5 2 5 3 5 4 5 5 5 6 5

1 6 2 6 3 6 4 6 5 6 6 6

Siguiendo la suma de los valores en el dado, la función de probabilidad puede ser definida

y graficada según lo siguiente:

Gráfico de Barra de Probabilidades

Resultados al lanzar dos dados

Outcome

Probabilit

y

1/36

2/36

3/36

4/36

5/36

6/36

2 3 4 5 6 7 8 9 10 11 12

El valor medio o promedio para esta distribución de probabilidades es la suma de las

probabilidades de un resultado multiplicado por el valor del resultado. En otras palabras, la

función de la probabilidad proporciona el ponderador para definir el promedio ponderado.

Resultado (xi) Pr( )X xi

2 1/36

3 2/36

4 3/36

5 4/36

6 5/36

7 6/36

8 5/36

9 4/36

10 3/36

11 2/36

12 1/36

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 27

z z Z zi i

i

Pr( )

( )( / ) ( )( / ) ( )( / ) ( )( / ) ( )( / ) ( )( / )

( )( / ) ( )( / ) ( )( / ) ( )( / ) ( )( / )

2

12

2 1 36 3 2 36 4 3 36 5 4 36 6 5 36 7 6 36

8 5 36 9 4 36 10 3 36 11 2 36 12 1 36

7

En forma similar la varianza puede ser definida como:

s z z Z zi i

i

n2 2

1

25 1 36 16 2 36 9 3 36 4 4 36 1 5 36 0 6 36

1 5 36 4 4 36 9 3 36 16 2 36 25 1 36

583

( ) Pr( )

( )( / ) ( )( / ) ( )( / ) ( )( / ) ( )( / ) ( )( / )

( )( / ) ( )( / ) ( )( / ) ( )( / ) ( )( / )

.

Un ejemplo considerando la disponibilidad del equipo

Una aplicación práctica del concepto de una función de probabilidad se encuentra en el área

de la disponibilidad de equipo. Supongamos que una pequeña operación tiene una flota de

2 excavadoras de 10m3

y que cada excavadora tiene una disponibilidad de 85%. Dada esta

disponibilidad y la suposición de que la disponibilidad no está correlacionada entre las

máquinas, el número de días en que ninguna, una o ambas excavadoras estarán funcionando

puede ser calculado.

Ya que la disponibilidad de una excavadora no está relacionada a la disponibilidad de la

otra, esta situación puede ser vista en la misma forma que el ejemplo del dado. Siguiendo

esta analogía, las excavadoras pueden ser representadas como dos dados, cada uno teniendo

sólo dos valores posibles: 1 (la excavadora está funcionando) y 0 (la excavadora no está

funcionando). Estos dados sin embargo están cargados. El valor 1 sale 85% de las veces

mientras que el valor 0 sólo aparece 15% de las veces. Las probabilidades de todos los tres

posibles resultados (0, 1, o 2 excavadoras funcionando) pueden entonces ser determinadas

multiplicando las probabilidades asociadas con los posibles resultados para cada máquina

(funcionando o no funcionando).

Número de

Funcionamiento

Probabilidad Método de Calcular la Probabilidad

2 0.722 Igual a la probabilidad de que la excavadora 1 esté disponible y la

excavadora 2 esté disponible o (0,85) (0,85)

1 0.255 Igual a la probabilidad de que la excavadora 1 esté disponible y la

excavadora 2 no lo esté (.85) (.15) además de la probabilidad de que

la excavadora 1 no esté disponible y la excavadora 2 sí lo esté (.15)

(.85)

0 0.023 Igual a la probabilidad de que las excavadoras 1 y 2 no estén

disponibles (.15) (.15)

De este análisis se espera que no haya ninguna excavación en 2.3% de los días en que la

mina esté operando (alrededor de 8 días al año). Este tipo de información generalmente

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 28

probará ser muy útil al planificar las operaciones de la mina y para desarrollar el programa

minero.

Para cantidades mayores de equipos, la tabulación de todas las posibles probabilidades

rápidamente se convierte en tediosa. Afortunadamente este tipo de problema ha sido muy

bien estudiado y se sabe que la probabilidad de que cualquier número dado o piezas de

equipo se encontrarán disponibles sigue una distribución binómial. La expresión para este

tipo de distribución es la siguiente:

knk ppknk

nkX

)1(

)!(!

!)Pr(

donde p = la disponibilidad de una pieza de equipo (fracción entre 0 y 1)

k = el número de piezas del equipo en funcionamiento

n = el tamaño total de flota

el signo de exclamación es el operador factorial.. Ejemplo 4! = (4)(3)(2)(1)

Datos Continuos

En cada uno de los ejemplos anteriores, los datos considerados tomaron valores enteros

exclusivamente. Las funciones de probabilidad derivadas de este tipo de datos son

conocidos como discretas. Los datos de leyes generalmente no son discretos ya que los

valores de ensayo no son enteros. En tales casos, los datos y el modelo de probabilidad son

llamados continuos. Al discutir las probabilidades para datos continuos, se debe discutir la

probabilidad sobre un margen en lugar de la probabilidad de un número exacto ya que la

probabilidad de un resultado exactamente igualando a cualquier valor individual es

extremadamente pequeña.

Se discuten dos tipos de probabilidades. La función de densidad de probabilidad (PDF) que

define la probabilidad que la variable tomará sobre un valor específico. Esta función puede

ser integrada sobre cualquier margen de ley de interés para definir la probabilidad que la

variable aleatoria tomará sobre valores entre los dos puntos extremos. La función de

densidad acumulativa (CDF) define la probabilidad de que la variable aleatoria tome un

valor menor que un número específico. Si el número específico elegido es un ley de corte,

entonces el CDF (o su estimación) define directamente el tonelaje bajo (y por lo tanto

sobre) la ley de corte.

Para obtener una representación ilustrada de un conjunto de datos y para obtener una idea

de la forma de PDF o CDF, se utiliza una herramienta conocida como un histograma o

histograma acumulado. Para crear un histograma, se define un número de rangos de

ley o clases y se cuenta el número de los ensayos que caen dentro de cada clase (o

porcentaje de ensayos).

Este gráfico de barra es llamado histograma.

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 29

Como un ejemplo de la metodología de construcción de un histograma, considere el

siguiente conjunto de datos de leyes.

0.86, 3.25, 3.18, 5.73, 3.03, 2.72, 2.02, 2.07, 3.91, 2.41, 3.34, 4.85, 4.97, 2.77, 3.04, 1.31, 2.23, 2.77, 2.18, 0.62

Las clases para este conjunto de datos pueden ser establecidos en valores enteros y el

número de ensayos contados por clase. Los resultados son los siguientes:

Un examen de la forma representada por el histograma proporciona información sobre la

posibilidad de que los datos sigan una de varias distribuciones bien conocidas. Los

modelos de distribución continua más comúnmente encontrados en la minería y la geología

son los modelos normal y log-normal.

La Distribución Normal

Los datos tienden a seguir una distribución normal o de Gauss siempre que el fenómeno

considerado involucre suma/promedio de otras variables aleatorias o cuando se consideren

errores. En la minería, esta distribución aparece al considerar los errores de ensayo en un

laboratorio o los errores de estimación. Los datos de ensayo de los yacimientos de metales

raramente siguen esta distribución. El CDF para la distribución normal es de acuerdo a lo

siguiente:

Ejemplo de Histograma

Intervalos de

Clase

Conteos

por Clase

Conteos

Acumulativos

0 a 1.0 2 2

1.0 a 2.0 1 3

2.0 a 3.0 8 11

3.0 a 4.0 6 17

4.0 a 5.0 2 19

5.0 a 6.0 1 20

Ejemplo de Histograma Acumulativo

Bin Intervals

Number of S

amples

0

2

4

6

8

10

12

14

16

18

20

22

<= 1 (1,2] (2,3] (3,4] (4,5] > 5

Ejemplo de Histograma

Bin Intervals

Number of S

amples

0

1

2

3

4

5

6

7

8

9

<= 1 (1,2] (2,3] (3,4] (4,5] > 5

___________________________________________Curso de Geoestadística para Minería

______________________________________________________________________ 30

varianciala es sy medio el es z

normalón distribuci la para PDF el es este : 2

)(exp

2

1)(

CDF al iguala PDF de integral el o : )()()Pr(

2

2

2

2

s

zz

szf

dZzfzFzZ

z

zz

z

Afortunadamente no es necesario resolver esta integración (ni siquiera mirar a estas

ecuaciones nuevamente) para evaluar la distribución normal. La distribución normal ha

sido bien estudiada y sus valores han sido tabulados. Para utilizar las tablas, se requiere

una conversión simple a la variable normal estándar. Esta conversión es como sigue:

Zz z

sn

( }

La variable normal es por lo tanto el valor observado menos el medio dividido por la

desviación estándar. Dada esta variable, es fácil definir la probabilidad de un evento

siempre y cuando los datos sigan una distribución normal.

A modo de ejemplo, consideremos nuevamente el método de análisis de laboratorio

discutido en el primer módulo. Supongamos que se ha determinado que el laboratorio es no

sesgado y que la desviación estándar relativa de las mediciones para este laboratorio al estar

desempeñándose correctamente es 10%. Para una ley normal de 0,8% de cobre, la tabla de

la distribución normal puede ser utilizada para determinar un margen aceptable de valores

para el laboratorio. Los valores de ensayo fuera de este margen son indicaciones de que el

laboratorio no esta cuantificando las leyes correctamente. Este tipo de análisis es calificado