Duncan Watts Cap 5 y 6

-

Upload

marcelo-de-la-torre -

Category

Documents

-

view

4.190 -

download

3

description

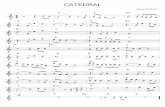

Transcript of Duncan Watts Cap 5 y 6

1

Capítulo 5

Buscar en las redesStanley Milgram fue en realidad una figura notablemente controvertida durante buena parte de su vida

profesional. Milgram, uno de los grandes psicólogos sociales, demostró su ingenio en la ideación de experimentos que dilucidaron la misteriosa interfaz entre las mentes de los individuos y el entorno social en el que típicamente operan. Los resultados de estos experimentos a menudo fueron sorprendentes, pero a veces también resultaron turbadores y poco gratos. En su estudio más célebre, Milgram atrajo hacia su laboratorio de la Universidad de Vale a miembros de la comunidad local de New Haven, con el pretexto de participar en un estudio sobre el aprendizaje humano. Conforme iban llegando, cada participante era presentado al supuesto sujeto del experimento y se le pedía que le leyera una serie de palabras que luego el individuo debería repetir. Si el sujeto del experimento cometía una falta, había de ser castigado con una descarga eléctrica, que debía administrarle el participante en el experimento. Cada error sucesivo producía una descarga de mayor voltaje, que llegaba finalmente a alcanzar niveles dolorosos e incluso letales. Cuando esto se producía, el sujeto del experimento se ponía a gemir, a gritar, a suplicar perdón y a retorcerse por los suelos perdiendo la compostura. A los participantes que se mostraban reacios o protestaban por lo que se les estaba pidiendo que hicieran a otro ser humano, un supervisor, de aspecto severo, enfundado en una bata blanca y armado de una tablilla con sujetapapeles les ordenaba que continuaran. En lo fundamental, sin embargo, nunca ninguno de ellos fue forzado a hacer nada ni fue amenazado con represalias. Si llegados a un determinado punto, se negaban a continuar, el experimento terminaba sin mayores consecuencias.

Naturalmente, el experimento no era más que una representación. Las descargas eléctricas no eran reales y el sujeto del experimento era un actor. En realidad se trataba de ver qué eran capaces de hacerle a otra persona, motu propio, individuos libres cuando se les ponía en la situación de obedecer órdenes de terceros. Al final, a los participantes se les comentó todo esto, pero mientras el experimento duró, consideraban que se trataba de algo real, lo cual hacía que su comportamiento fuera aún más incómodo. En una variación de esta prueba, durante la cual los participantes seguían siendo decisivos en el desarrollo del experimento, pero en la que las descargas las aplicaba un intermediario, treinta y siete de los cuarenta participantes aumentaron los voltajes hasta niveles letales, lo cual llevó a Milgram a concluir que las burocracias que distanciaban a los individuos de las consecuencias últimas de sus actos eran más eficientes a la hora de aplicar con dureza la represión. En otra variación, se le pedía al participante que sostuviera la mano del sujeto en la placa eléctrica mientras le aplicaba la descarga. Aún en nuestros días, resulta difícil leer la elegante exposición que de su trabajo hizo el propio Milgram en Obediencia a la autoridad, sin sentir escalofríos. Pero en el panorama ideológico de posguerra en Estados Unidos durante la década de 1950, los hallazgos de Milgram desafiaban aquello en lo que por entonces se creía, y el experimento se convirtió en un foco de escándalo nacional.

Este experimento, pese a ser sumamente escandaloso, le abrió a Milgram la puerta del panteón de los intelectuales con un reconocimiento público cuya obra es tan ampliamente recordada y tan frecuentemente explicada que ha acabado arraigando en la propia cultura. Todavía estamos bajo el efecto del shock -es una manera de hablar- que supusieron los resultados experimentales a los que llegó, pero no ponemos en tela de juicio su autenticidad, aunque se dé el hecho de que sus experimentos nunca fueron repetidos. (En realidad, en aplicación de las regulaciones vigentes en materia de experimentos con sujetos humanos no podrían serlo.) Tampoco ponemos en duda su investigación sobre el problema del mundo pequeño (véase el capítulo 1), pese a que sigamos encontrando enigmáticos y sorprendentes los resultados a los que llegó. Si bien todos hemos oído hablar de los seis grados de separación, la mayoría no es consciente de quién acuñó la expresión ni de cómo lo hizo, y muy pocos han examinado de cerca y con detenimiento los resultados reales obtenidos por Milgram. Incluso los investigadores que citan el artículo original de Milgram y de los cuales nos inclinaríamos a pensar que lo han examinado a fondo se han mostrado propensos a aceptar sencillamente sus conclusiones sin ponerlas en duda.

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

2

Ese comportamiento plantea una cuestión sutil sobre la ciencia. Por un lado, la fuerza del proyecto científico reside en su naturaleza acumulativa. Los científicos llegan a abordar sus problemas concretos amparándose en un cuerpo de conocimientos anterior y en el cual esperan basarse sin poner en tela de juicio la validez de todos y cada uno de los métodos, suposiciones o conjuntos de hechos que utilizan. Si todos tratáramos de averiguarlo todo desde los primeros principios o incluso si insistiéramos en comprender cada pieza del puzzle con igual grado de detalle, nadie llegaría nunca a ninguna parte. Así, en cierta medida, tenemos que aceptar aquello que previamente la comunidad científica ha reconocido que se ha hecho con detenimiento y de manera correcta, y que, en consecuencia es de fiar.

Por otro lado, los científicos son tan absolutamente humanos como cualquier otro profesional y están invariablemente motivados por otros muchos factores aparte de la búsqueda de la verdad científica genuina. En parte debido a sus imperfecciones humanas, y en parte por el hecho de que la verdad misma puede ser difícil de discernir, los científicos cometen errores, interpretan mallos resultados que han obtenido y permiten que otros los tergiversen. El sistema recurre a una serie de mecanismos para anticiparse a la indefectible aparición de esos errores, como, por ejemplo, el método de evaluación por expertos (peer review), los congresos y seminarios académicos, y la publicación de artículos de crítica, que permiten filtrar buena parte de las impurezas. Pero el proceso dista mucho de ser perfecto y a veces nos sorprendemos al descubrir que un conocimiento que dábamos por cierto es dudable e incluso erróneo.

¿QUÉ DEMOSTRÓ MILGRAM EN REALIDAD?La psicóloga Judith Kleinfeld dio con lo que ahora parece un ejemplo clásico de esta fe injustificada

mientras impartía su curso de psicología a los estudiantes de primer ciclo. Andaba buscando un experimento práctico que sus estudiantes pudieran realizar y que les permitiera entender el modo en que podía aplicar en sus vidas fuera del aula lo que estaban aprendiendo en la asignatura. El experimento del mundo pequeño que había realizado Milgram parecía un candidato perfecto y Kleinfeld decidió proponer a sus estudiantes que lo repitieran de la manera en que se podía hacer en el siglo XXI, utilizando el correo electrónico en lugar del correo postal. Sin embargo, finalmente en realidad no llegaría a realizarse. A fin de preparar el experimento, Kleinfeld empezó por leer los artículos de Milgram. En lugar de encontrar una base sólida para el experimento en el que estaba pensando, los resultados de Milgram –examinados detenidamente- parecían plantear solo cuestiones incómodas acerca de cómo había llegado a obtenerlos.

Conviene recordar aquí que Milgram puso en marcha su cadena con aproximadamente trescientas personas, todas las cuales trataron de hacer llegar sus cartas a un mismo destinatario en Bastan. Según lo que todo el mundo cuenta, esas trescientas personas vivían en Omaha, pero un examen más detenido de sus orígenes muestra que un centenar vivían de hecho en Bastan. Además, de entre las casi doscientas personas que vivían en Nebraska, sólo la mitad habían sido seleccionadas al azar (a partir de una lista de correos que Milgram adquirió). La otra mitad eran todas inversoras en acciones de primer orden y el destinatario en Bastan, por supuesto, era un agente de bolsa. Los célebres seis grados, en realidad, eran el promedio obtenido a partir de los resultados de estas tres poblaciones, y, como cabía esperar, el número de grados variaba bastante de una porción a otra de esta muestra: así, los naturales de Bastan y los inversores de bolsa consiguieron completar las cadenas con mayor éxito y menos enlaces que la muestra aleatoria tomada de Nebraska.

Recordemos, asimismo, que el sorprendente hallazgo en el problema del mundo pequeño afirma que cualquier persona puede llegar a cualquier otra persona, es decir, no sólo a las demás personas de la misma localidad o a personas con fuertes intereses comunes, sino a cualquier otra en cualquier otro lugar. Así, en realidad, la única población que satisfacía, aunque de modo remoto, las condiciones de la hipótesis tal como se acostumbra a enunciar (e incluso tal como el propio Milgram la enunció) eran las noventa y seis personas que habían sido seleccionadas a partir de la lista de correos. Llegados a este punto, el peso de la muestra empieza a ser inquietantemente menor: de las noventa y seis cartas iniciales enviadas por la población de esa muestra, sólo dieciocho llegaron a su destino. ¡Dieciocho! ¿Y para este viaje tantas alforjas? ¿Cómo podía alguien haber inferido a partir de sólo dieciocho cadenas dirigidas a un único destinatario un principio tan universal y que pretende abarcarlo todo como el que empezamos proponiéndonos explicar? Y ¿cómo todo el resto de nosotros pudimos estar de acuerdo con aquel resultado sin poner en tela de juicio en ningún momento la plausibilidad de semejante afirmación?

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

3

Turbada por estas preguntas, Kleinfeld pasó a investigar los artículos posteriores de Milgram y de otros autores, suponiendo que a todas luces la insostenible laguna existente entre los resultados empíricos y su posterior interpretación había sido justificada en alguna otra parte. De nuevo, se sorprendió al descubrir que no era así y que más bien había sucedido todo lo contrario. Si bien Milgram y sus colaboradores llevaron a cabo otros experimentos -y el más significativo de los cuales era el que relacionaba a una población de raza blanca en Los Ángeles con destinatarios afroamericanos de la ciudad de Nueva York-, éstos adolecían más o menos de lo mismo que el primero. Y lo que era aún más sorprendente, sólo un puñado de investigadores habían intentado reproducir los hallazgos de Milgram, y los resultados a los que ellos habían llegado eran aún menos persuasivos que los de Milgram. Uno de estos experimentos, por ejemplo, trató de relacionar remitentes y destinatarios en el seno de la misma Universidad del Medio Oeste de Estados Unidos, lo cual difícilmente cabía considerar como una prueba de un principio universal.

Cada vez más preocupada por todo lo que iba descubriendo, Kleinfeld terminó buscando en los archivos de la Universidad de Yale ahondando en las notas originales y los escritos inéditos de Milgram, convencida aún de que se le había pasado hasta entonces algo por alto. Y, en efecto, así era. Tal como descubrió en ese trabajo de documentación, Milgram había realizado otro estudio paralelamente al de Omaha, en el cual había escogido remitentes situados en Wichita, Kansas y, como destinataria, a la esposa de un estudiante del Divinity School de Harvard. Milgram mencionó este estudio en su primer artículo, publicado en Pyschology Today, porque había dado la cadena más corta de las que había tenido oportunidad de medir: la primera carta llegó a su destino en sólo cuatro días y empleó sólo dos intermediarios. Aquello que Milgram no mencionó en ese artículo ni en cualquier otro es que de las sesenta cartas que se enviaron, la primera era sólo una de las tres que llegaron a su destino. Kleinfeld también sacó a la luz informes de dos estudios complementarios en los que los índices de finalización de la cadena eran tan bajos que no se llegaron a publicar los resultados. La conclusión final de Kleinfeld era que el fenómeno del mundo pequeño, tal como estamos acostumbrados a verlo presentado, carecía de base empírica.

Cuando este libro iba camino de la imprenta, estábamos realizando lo que es de lejos el experimento de mundo pequeño más extenso hasta la fecha realizado, en un intento por resolver el tema que debiera haberse resuelto mucho antes. Sirviéndonos del correo electrónico en lugar de cartas convencionales y coordinando los mensajes a través de un website centralizado, pudimos manejar un volumen de remitentes y datos que Milgram ni alcanzó a soñar. Por el momento, tenemos cincuenta mil cadenas de mensajes cuyo origen se halla en cincuenta países en busca de dieciocho destinatarios distribuidos por Estados Unidos, Europa, América del Sur, la región de Asia y el Pacífico. Desde un profesor universitario de Ithaca -¿no se imagina quién es?- hasta un inspector de archivos en Estonia, pasando por un policía de Australia hasta un oficinista de Omaha, nuestros destinatarios cubren la gama de usuarios de Internet, una población de quinientos millones de personas globalmente dispersa. Nuestros remitentes, entretanto, fueron reclutados a través de reseñas sobre el experimento que aparecieron publicadas en la prensa de todo el mundo, y son cientos los que se ponen cada día en contacto con nosotros.

Por grande que pueda parecernos, medio millar de millones de personas no es aún todo el mundo. y casi con toda seguridad, las personas que tienen acceso a un ordenador (y el tiempo libre suficiente para utilizarlo) representan una sección relativamente reducida de la sociedad global. Evidentemente, por tanto, los resultados de un experimento tan gigantesco como el que realizamos no serán universalmente aplicables. Además, el experimento adolece de un problema con el que ya se encontró Milgram, aunque no en la misma medida: la apatía. En la actualidad, mucho más que en la década de 1960, recibimos montones de correo basura, sobre todo correo electrónico, y frecuentemente somos reticentes -o sencillamente estamos demasiado ocupados- como para participar, aunque nos lo pida un amigo. El resultado es un índice de terminación de la cadena aplastantemente bajo, menos del 1 % del total de las cadenas que empezaron llegaron hasta sus destinatarios finales (Milgram, conviene recordarlo, obtuvo un índice de terminación del 20 %). Así, aunque las esperanzas que depositamos en nuestro experimento son altas, el jurado aún está deliberando y puede continuar así aunque nuestros resultados queden enteramente analizados. Quizá, por tanto, el mensaje a transmitir es que resulta increíblemente difícil resolver por vía empírica el fenómeno del mundo pequeño.

¿SEIS ES UN NÚMERO GRANDE O PEQUEÑO?¿Dónde nos deja esto? Al fin y al cabo hemos dedicado un buen rato a tratar de comprender el

fenómeno del mundo pequeño. Y ahora, ¿vamos a ponerlo en tela de juicio? Lo que se dice ponerlo en tela de

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

4

juicio, no, pero existe una diferencia importante entre el fenómeno del mundo pequeño que definimos para nuestros modelos de red y el fenómeno del mundo pequeño tal como lo investigó Milgram y que, precisamente, hemos glosado en las páginas anteriores. Conviene no olvidar que el principal motivo para el enfoque inicial que dimos al problema era la dificultad de una verificación empírica, de modo que, per se, la continua escasez de pruebas empíricas no supone un problema para los resultados que hemos obtenido. La cuestión en realidad es que existe una gran diferencia entre dos personas que están relacionadas por un camino corto (que es lo que afirman los modelos de red de mundo pequeño) y su capacidad para encontrar ese camino. Recordemos que los sujetos del experimento de Milgram se suponía que pasaban la carta a una persona que consideraban más relacionada con el destinatario de lo que ellos mismos estaban. Lo que se suponía que no hacían era enviar copias de la carta a todas las personas que conocían. Con todo, ése era precisamente el tipo de cálculo que con Steve llevamos a cabo en nuestros experimentos numéricos, y que se halla implícito en nuestros enunciados acerca de las longitudes de camino más cortas. Por tanto, a nuestro entender, es completamente posible vivir en un mundo pequeño, en el sentido de los modelos de redes de mundo pequeño expuestos en los capítulos 3 y 4, y aún así dudar de la veracidad de los hallazgos de Milgram.

Otro modo de expresar la diferencia entre la prueba que nosotros ideamos para el fenómeno del mundo pequeño y la de Milgram consiste en contraponer búsqueda diseminada y búsqueda dirigida. En la modalidad diseminada, uno se lo cuenta a todos aquellos que conoce, los cuales, a su vez, se lo cuentan a todos los que conocen, y así hasta que el mensaje llega hasta su destinatario. Según esas reglas, si es que existe un camino corto que relacione la fuente remitente y el destinatario, uno de esos mensajes lo encontrará. El inconveniente es que la red está totalmente saturada de mensajes, dado que cualquier rincón y ranura son probados como un camino potencial para llegar hasta el destinatario. No parece muy halagüeño, y, en efecto, no lo es. De hecho, precisamente de este modo se propagan los virus informáticos más molestos, de los cuales hablaremos con mayor detenimiento en el capítulo 6.

Las búsquedas dirigidas son mucho más sutiles que las diseminadas y presentan distintos pros y contras. En una investigación dirigida como la del experimento de Milgram, sólo se pasa un mensaje a la vez, de modo que si la longitud de un camino entre dos individuos tomados al azar es, pongamos por caso, de seis pasos, entonces sólo seis personas reciben el mensaje. Si los sujetos del experimento de Milgram hubieran realizado búsquedas diseminadas, enviando mensajes a todas y cada una de las personas que conocían, las cartas hubieran sido recibidas por todas las personas que viven en el país -unos doscientos millones de habitantes más o menos en aquella época- sólo para llegar a un único destinatario. Si bien un método de diseminación hubiera encontrado, en principio, lamino más corto hasta el destinatario, en la práctica; habría resultado imposible. Al requerir la participación de sólo seis personas, el método de la búsqueda dirigida evita inundar el sistema, aunque la tarea de encontrar un camino corto se hace considerablemente más complicada. Si bien en teoría sólo seis grados nos separan de cualquier otra persona en el mundo, el planeta, no obstante, tiene seis mil millones de habitantes, y al menos un número igual de caminos que llevan hasta ellos. Enfrentados a este laberinto de complejidad que resulta harto difícil de concebir, ¿cómo encontraremos aquel camino corto que andamos buscando? Bueno, lo cierto es que es difícil, al menos si lo hacemos en solitario.

Mucho antes de que apareciera el juego de Kevin Bacon, los matemáticos acostumbraban a jugar a algo similar con Paul Erdős. A Erdős, que no sólo era un gran matemático -en extremo prolífico-, sino también casi una celebridad entre la comunidad de matemáticos, se le consideró el centro de esta comunidad del mismo modo en que Kevin Bacon era el centro del mundo de los actores cinematográficos. En consecuencia, cuando se había publicado un artículo con Erdős, se recibía el número Erdős 1. Si no se había publicado un artículo con Erdős pero se había escrito uno con alguien que sí lo había hecho, entonces se recibía el número Erdős 2. Y así sucesivamente. De modo que la pregunta que hacer era: «¿Qué número Erdős tienes?». Y el objeto del juego consistía en tener el número Erdős más pequeño posible.

Si se tenía el número Erdős 1, entonces el problema era trivial. Y si se tenía el número Erdős 2, tampoco estaba mal. Erdős era un hombre célebre, de modo que cualquiera que hubiera trabajado con él probablemente lo habría mencionado. Pero cuando el número Erdős era superior a 2, el problema se complicaba, porque aunque uno conociera bien a los colaboradores con quien trabajaba, por lo general no conocía a todos los demás con los que aquellos habían colaborado. Si se le dedica un tiempo, se podría escribir una lista razonablemente completa de otros colaboradores con los que han trabajado, aunque fuera sólo examinando todos los artículos que han publicado o preguntándoselo directamente. Sin embargo, hay científicos que han escrito artículos durante cuarenta años o más y pueden haber acumulado varias docenas de

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

5

colaboradores en ese lapso de tiempo, y les puede resultar difícil acordarse de algunos de sus nombres. Todo esto tiene ya el aspecto de ser difícil pero lo es aún más, y en el siguiente paso uno se pierde en lo esencial. Imaginémonos que tratamos de escribir la lista no sólo de nuestros colaboradores y de los que a su vez colaboraron con ellos, sino también la de todos los colaboradores que trabajaron con estos últimos. Ni tan sólo conoceremos a la mayoría y puede darse el caso de que ni siquiera hayamos oído hablar de ellos; así, ¿cómo vamos a tener la posibilidad de saber con quién han trabajado? Básicamente no podemos.

Lo que hemos tratado de hacer aquí es efectivamente una búsqueda diseminada en una red de coautoría y, de nuevo, descubrimos que prácticamente es imposible. Así, todos acabamos haciendo una búsqueda dirigida. Escogemos a uno de nuestros colaboradores cuyo trabajo consideramos que es más similar al de Erdős, y así sucesivamente. El problema es que a menos que se sea un experto en uno de los campos específicos en los que Erdős trabajó, puede que no sepamos cuál de entre nuestros colaboradores es la mejor elección. En cuyo caso, puede que nos equivoquemos desde el principio y terminemos atrapados en un callejón sin salida. O tal vez lo acertemos de entrada, pero en una de las oportunidades siguientes no atinemos a hacerlo. O tal vez estemos en el camino correcto, pero lo abandonemos antes de haber ido lo suficientemente lejos. ¿Cómo sabremos si la búsqueda avanza por buen camino?

Esta pregunta no parece tener una respuesta sencilla y la principal dificultad estriba en que tratamos de resolver un problema global-encontrar un camino corto- utilizando sólo información local sobre la red. Podemos saber quiénes son nuestros colaboradores, pero más allá de ellos, en realidad, nos enfrentamos a un mundo de extraños. En consecuencia, resulta imposible saber cuál de los muchos caminos que parten de nosotros llevan hasta Erdős en el menor número de pasos posible. A cada grado de separación, hemos de tomar una nueva decisión y no hay un modo claro de evaluar cuáles son nuestras opciones. Al igual que alguien que vive en Manhattan puede ir fácilmente en coche hasta el aeropuerto de La Guardia para embarcar en un vuelo que le llevará a la Costa Oeste, la elección óptima del camino de red puede llevarnos, al principio, en una dirección que parece equivocada. Pero, a diferencia del desplazamiento hasta el aeropuerto, en este caso no tenemos un mapa completo de la ruta en nuestra cabeza, de modo que el equivalente en este caso a «conducir en dirección este para volar hacia el oeste» no es una idea tan obviamente buena.

Por muy pequeño que pueda parecernos a primera vista, el seis puede ser un número grande. De hecho, cuando se trata de búsquedas dirigidas, cualquier número superior a dos es de hecho grande, tal como Steve tuvo oportunidad de descubrir un día cuando un periodista le preguntó cuál era su número Erdős. Finalmente lo calculó -era cuatro-, pero tuvo que dedicar dos días enteros para averiguarlo. (Lo recuerdo porque yo estaba tratando de hacer algo con él y Steve estaba demasiado preocupado incluso para hablar.) Aunque puede parecernos que sólo se trata de otros de otros de los modos que los matemáticos tienen para no hacer un trabajo real, lo cierto s que las búsquedas dirigidas tienen una vertiente seria. Desde navegar por Internet hasta localizar un archivo en una red de evaluación por expertos, o incluso hasta tratar de encontrar a la persona indicada para que responda a una pregunta técnica o administrativa, con frecuencia nos encontramos buscando información haciendo una serie de preguntas, y a menudo nos quedamos atrapados en callejones sin salida frustrantes o dudando de si hemos seguido el camino más corto. Tal como veremos en el capítulo 9, encontrar caminos cortos que lleven a la información correcta es algo especialmente importante en épocas de crisis o de rápido cambio, cuando los problemas requieren que se les encuentre una solución a toda prisa y nadie tiene una idea clara de qué se precisa o quién la tiene. Y, tal como pudimos descubrir con el problema original del mundo pequeño, una teoría sencilla a veces puede decirnos mucho acerca de un mundo complejo que no hubiéramos reparado en considerar de haber examinado directamente el mundo mismo.

EL PROBLEMA DE LA BÚSQUEDA EN EL MUNDO PEQUEÑOEn esta ocasión, el avance decisivo lo realizó un joven informático, Jan Kleinberg, que estudió en la

Universidad de Cornell y en el MIT, trabajó en el Almaden Research Center que IBM tiene cerca de San Francisco y luego volvió a Cornell como profesor. Kleinberg planteó una pregunta que ni a Steve ni a mí se nos había ocurrido, aunque, al igual que con las redes sin escala, parecía tan natural considerada a posteriori que nos preguntábamos cómo era posible que se nos hubiese pasado por alto. En lugar de centrarnos en la mera existencia de caminos cortos, como habíamos hecho nosotros, Kleinberg se preguntó cómo los individuos en una red podían encontrar efectivamente esos caminos. Y el motivo volvía a ser el trabajo de Milgram. Dejando a un lado las dudas que Judith KIeinfeld evidenció, ciertamente algunos de los individuos que participaron en los experimentos de Milgram consiguieron que las cartas que ellos enviaron llegaran al

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

6

destinatario que se pretendía, y el modo en que lo habían logrado, para KIeinberg, no era obvio. Después de todo, los remitentes en esencia intentaban realizar una búsqueda dirigida en una red social muy grande sobre la cual disponían de muy poca información (mucha menos que un matemático que tratara de calcular su número de Erdős).

Ante todo, lo que Kleinberg resolvió fue que, de hecho, si .el mundo real funcionaba de algún modo como proponían los modelos que habíamos propuesto con Steve, entonces las búsquedas dirigidas del tipo de aquella observada por Milgram habrían sido imposibles. El problema, al final, resultó surgir de un rasgo de nuestros modelos de mundo pequeño que aún no hemos expuesto. Si bien los modelos nos permiten construir redes que presentan una cantidad de desorden variable, la aleatoriedad es en realidad de un tipo especial. En concreto, siempre que se crea un atajo a través de una de nuestras renovaciones o reconexiones (rewirings), un vecino queda liberado y un nuevo vecino es escogido uniformemente al azar entre todos los de la red. Dicho de otro modo, cada nodo tiene la misma probabilidad de ser escogido como nuevo vecino, con independencia de dónde se halle situado y lo lejos que esté.

La aleatoriedad uniforme nos parecía una suposición natural que hacer en nuestro primer intento de abordar el problema, porque no depende de la idea particular de distancia de nadie. Pero aquello que Kleinberg señalaba era que las personas, de hecho, sí tienen nociones bastante fuertes de lo que es distancia y las utilizan en todo momento para diferenciarse de los demás. La distancia geográfica es una noción evidente, pero la profesión, la clase, la raza, la renta, la formación, la religión y los intereses personales son, a menudo, factores en nuestras evaluaciones de lo «distante» que uno está respecto a otras personas. Nos servimos de estas nociones de distancia en todo momento cuando nos identificamos a nosotros mismos y a los demás, y es de suponer que los sujetos que participaban en los experimentos de Milgram también las utilizaban. Pero como sea que las conexiones aleatorias uniformes como las representadas en la figura 3.6 no se sirven de estas nociones de distancia, los atajos resultantes son difíciles de utilizar en el caso de las búsquedas dirigidas. La ausencia de toda referencia al sistema de coordenadas subyacente -el retículo en anillo en el caso del modelo beta del capítulo 3- impide que la búsqueda dé en el blanco con efectividad. Así, el mensaje termina o saltando aleatoriamente por la red o abriéndose lentamente camino a través del retículo. Si ése había sido el caso en el experimento de Milgram, sus cadenas habrían tenido una longitud de cientos de enlaces, pocos menos que si el mensaje hubiera pasado de puerta en puerta cubriendo toda la distancia que separa Omaha de Boston.

Así, aquello que Kleinberg consideraba era una clase de modelos de red mucho más general en los que, aunque los enlaces aleatorios se continúan añadiendo a un retículo subyacente, la probabilidad de que un enlace al azar relacione dos nodos decrece conforme crece su distancia medida en el retículo. Para decirlo de una forma más llana, Kleinberg consideraba el problema de pasar el mensaje en un retículo de dos dimensiones (figura 5.1), en la parte superior del cual imaginaba que se añadían enlaces aleatorios según una distribución de probabilidad representada' por una de las funciones de la figura 5.2. Desde un punto de vista matemático, cada una de estas líneas rectas trazadas en una escala de ejes logarítmicos es una ley potencial con un exponente gamma (ɣ) que cambia de una línea a otra.

FIGURA 5.1. Modelo de retículo bidimensional de Kleinberg. Cada nodo está relacionado con sus otros cuatro vecinos más cercanos en el retículo y un único contacto aleatorio.

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

7

Un exponente con valor cero -la línea horizontal en la parte superior- implica que todos los nodos del retículo tienen igual probabilidad de ser contactos aleatorios; dicho de otro modo, el modelo de Kleinberg se reduce a una versión bidimensional del modelo beta que hemos expuesto en el capítulo 3. Así, cuando gamma es igual a cero, existen muchos caminos, pero tal como acabamos de ver, no se pueden hallar. Cuando gamma, en cambio, es grande, la probabilidad de un atajo aleatorio decrece tan rápidamente con la distancia que sólo aquellos nodos que ya se hallan cerca (en e1 retículo) tienen alguna oportunidad de ser conectados. En este límite, cada conexión aleatoria contiene mucha información acerca del retículo subyacente, y así los caminos pueden ser recorridos con facilidad. El problema estriba en que como los atajos de largo alcance son efectivamente imposibles, no hay camino corto alguno que encontrar. Por tanto, el modelo no daba lugar, ni en un límite ni en el otro, a redes en las que se pueden lanzar procesos de búsqueda. Pero aquello que Kleinberg quería saber era qué sucedía en la zona situada en medio.

FIGURA 5.2. Probabilidad de generar un contacto aleatorio en función de la distancia reticular (r). Cuando el exponente gamma (ɣ) es igual a cero, los contactos aleatorios de todas las longitudes son igual de probables. Cuando, en cambio, el valor del exponente gamma es grande, sólo los nodos situados cerca del retículo estarán conectados.

En realidad sucede algo bastante interesante. La figura 5.3 muestra el número típico de saltos que un mensaje necesita realizar antes de localizar a un destinatario aleatorio, en función del exponente gamma (ɣ). Cuando el exponente gamma es muy inferior a dos, los caminos cortos sencillamente no existen. Pero cuando gamma es exactamente igual a dos, la red alcanza una especie de óptimo entre la conveniencia de navegación del retículo y la potencia acortadora de distancia de los atajos de largo alcance. Continúa siendo cierto que la probabilidad de relacionar un nodo particular cualquiera decrecerá con la distancia. Pero también lo es que cuanto mayor es la distancia, más nodos con los que conexionarse hay. Aquello que Kleinberg demostró es que cuando gamma alcanza el valor crítico de dos, estas fuerzas en conflicto se anulan la una a la otra. El resultado es una red con la propiedad particular según la cual los individuos tienen el mismo número de lazos en todas y cada una de las escalas de longitud.

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

8

FIGURA 5.3. Principal resultado de Kleinberg. Sólo cuando el exponente gamma es igual a dos, la red posee caminos cortos que los individuos pueden efectivamente encontrar.

Este concepto es algo difícil de comprender, pero Kleinberg aportó una bonita imagen que permite captarlo; me refiero al dibujo View of the World from 9th Avenue de Saul Steinberg, y que fue publicado como una hermosa portada en The New Yorker en una de sus entregas de 1976. Lo hemos reproducido en la figura 5.4. En la imagen, la Novena Avenida ocupa casi tanto espacio como toda una manzana de la ciudad, la cual a su vez ocupa el mismo espacio que la parte de Manhattan al oeste de la Décima Avenida y el río Hudson juntos. La primera parte de la imagen está dedicada a todos los Estados Unidos situados al oeste del Hudson, al océano Pacífico; y, luego, finalmente, al resto del mundo.

FIGURA 5.4. Saul Steinberg, View of the World fmm 9th Avenue, publicado en una de las portadas de 1976 del The New Yorker, ilustra el concepto de fases de búsqueda desarrollado por Kleinberg. Colección particular, Nueva York.

Steinberg hacía en este dibujo un comentario social sobre la tendencia de los neoyorquinos a poner un hincapié muy especial en que los asuntos locales son grandes cuestiones que tiene planteadas el planeta -es decir, su visión de sí mismos como ombligo del universo-, pero, en cambio, en el modelo de Kleinberg, la imagen cobra un sentido aún más tangible. Cuando gamma es igual al valor crítico de dos, un individuo en la Novena Avenida es probable que tenga el mismo número de amigos en cada región, o escala, de la imagen. Dicho d otro modo, sería de esperar que tuviéramos tantos amigos viviendo en nuestro vecindario como en el resto de la ciudad, que tuviéramos el mismo número de amigos viviendo en el resto del Estado como, de nuevo, en el resto del país, y así sucesivamente, hasta alcanzar la escala de todo el mundo. Las posibilidades que tenemos de conocer a alguien que viva en otro continente son más o menos las mismas que las de conocer a alguien que viva en nuestra calle. Sin duda, varios miles de millones de personas viven en otros continentes, y probablemente sólo unos pocos cientos viven en nuestra calle. Pero aquí la idea consiste en que es tan poco probable que conozcamos a alguna persona en particular en el otro lado del mundo que «el resto del mundo» y «la calle» acaban por representar más o menos el mismo número de nuestros conocidos.

Lo fundamental del resultado alcanzado por Kleinberg es que cuando se cumple esta condición de igual conectividad en todas las escalas de longitud, no sólo la red muestra caminos cortos entre todos los pares de nodos, sino que también los remitentes individuales pueden hallar los caminos si cada uno de ellos

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

9

simplemente remite el mensaje a aquel de sus amigos que parece estar más cerca o ser más allegado al destinatario. Lo que hace factible el problema de la búsqueda es que nadie tiene que resolverlo en solitario. Más bien, todo de cuánto debe preocuparse un remitente particular a cada paso es de hacer que el mensaje llegue a la siguiente fase de su búsqueda, y aquí fase es algo similar a las diferentes regiones del dibujo de Steinberg. Así, en el caso de que nuestro destinatario final fuese un granjero de Tayikistán, no es preciso averiguar cómo hacer que el mensaje recorra todo el camino hasta llegar a su destino, ni siquiera al país indicado. Sólo debemos dirigirlo hacia la parte correcta del mundo, y luego dejar que otro se ocupe de él. Al hacerlo así, suponemos que la persona que viene a continuación en la cadena, al estar más cerca del destinatario, tiene una información más precisa que la nuestra, y, por tanto, está en mejores condiciones de hacer que la búsqueda avance hasta su siguiente fase. Y, en efecto, eso es precisamente lo que se garantiza cuando el exponente gamma es igual a dos. Cuando la red satisface esta condición, sólo se requieren unos pocos remitentes para hacer que un mensaje pase de una fase a otra (desde cualquier parte del mundo hasta el país indicado, desde cualquier punto de ese país hasta la ciudad correcta, y así sucesivamente). Y dado que el mundo, tal como lo refleja la imagen que Steinberg dibujó, siempre se puede dividir en un pequeño número de estas fases, entonces la longitud total de la cadena de mensaje será también corta.

La condición de Kleinberg, como la denominamos, junto con la prueba que hizo de la imposibilidad de buscar en redes uniformemente aleatorias de mundo pequeño, significó, de hecho, un paso importante en nuestra reflexión sobre las redes. La idea de mayor calado de Kleinberg era que los meros atajos no bastaban para hacer que el fenómeno de mundo pequeño tuviera alguna utilidad real para los individuos informados localmente. Para que las conexiones o las relaciones sociales sean útiles --en el sentido de encontrar algo de forma deliberada- tienen que cifrar información acerca de la estructura social subyacente. Pero aquello que el modelo de Kleinberg no explicaba es cómo el mundo podría efectivamente ser así. Tal vez sea cierto que si los lazos en una red social son dispuestos de talo cual determinada manera, entonces el mundo de improviso pasa a ser explorable. Pero, ante todo, ¿cómo diantre se organizaría la red de ese modo? Desde una perspectiva sociológica, de hecho, la condición de Kleinberg parece bastante improbable. Kleinberg, sin duda, no trataba de elaborar un modelo realista en términos sociológicos y, al mantener el modelo que elaboró en ese nivel de sencillez, pudo comprender sus propiedades de una manera en que le hubiera resultado imposible a través de una versión más compleja. Pero, de este modo, dejó también la puerta abierta a una nueva forma de pensar el problema, una forma que incorporaba ciertas ideas sociológicas.

LA SOCIOLOGÍA CONTRAATACA Un día que Mark me visitó en la Universidad de Columbia, a la que me había trasladado tras dejar el

MIT en agosto de 2000 para incorporarme al departamento de sociología, hablamos del problema de la búsqueda dirigida. Después de discutirlo un poco, nos convencimos de que la condición de Kleinberg no era la forma correcta de entender los resultados de Milgram. Pero ¿entonces cuál era? ¿No había probado Kleinberg que no era posible buscar de manera efectiva en cualquier red que no estuviera conexionada equitativamente en todas las escalas de longitud? Bueno, en parte sí y en parte no. Sí, en el caso de que fuera cierto que las personas miden todas las distancias que median entre ellas y cualquier otra en función de un retículo subyacente. Pero tal vez lo que en realidad nos decían los resultados de Kleinberg era que las personas no calculan en realidad las distancias de esa manera. Mientras paseábamos por el campus bajo un sol primaveral, se nos ocurrió un ejemplo que suponía el desafío arquetípico que plantea e1 problema del mundo pequeño: ¿cómo llegar hasta un campesino chino? Tal vez ninguno de nosotros conocía a ningún campesino en China continental y, con independencia de cuántos campesinos hubiera en el país, quizá nunca llegaríamos a conocer a ninguno. Pero conocíamos a alguien que al menos podía indicarnos la dirección a seguir.

Erica Jen, una norteamericana de origen chino que hasta hacía poco había sido vicerrectora de investigación en el Santa Fe Institute y era asimismo la persona que nos había contratado tanto a Mark como a mí, estudió en la Universidad de Pekín durante los años de la Revolución cultural, mucho antes de su llegada a Santa Fe. Además, en aquella época, Jen había sido en cierto modo una activista social (y una de las primeras ciudadanas estadounidenses en estudiar en la capital de China) y nos figuramos que, aunque no conociera a ningún líder rural de la provincia de Sichuan (o cualquier otra donde nuestro hipotético campesino viviese), podría, en cambio, conocer a alguien que sí lo conociera. En todo caso, si le dábamos una carta, podíamos confiar bastante en que el mensaje llegaría a China en un solo paso. No sabíamos exactamente cómo y tampoco qué sucedería una vez la carta llegara a aquel país. Pero si Kleinberg estaba en lo cierto,

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

10

aquél no era nuestro problema, ya que todo cuanto debíamos hacer era llevar la carta hasta la fase siguiente en el camino de su entrega (es decir, hacerla llegar al país correcto) y entonces dejar que alguien más se ocupara de apuntarla en la dirección que la llevaría hasta su destinatario.

La diferencia entre el modelo Kleinberg y nuestra cadena imaginaria de remitentes consistía en que si bien Erica era a todas luces un enlace fundamental en la cadena, y probablemente la que haría llegar la carta más lejos, no era, en lo que a Mark y a mí concernía, un contacto de «larga distancia». Los tres pertenecimos, en algún momento, a la misma comunidad, pequeña y muy unida que abarcaba a los investigadores empleados en el Santa Fe Institute. Desde nuestro punto de vista, no importaba dónde hubiera vivido Erica Jen o qué hubiera hecho hacía dos décadas: ella era nuestro superior, y nuestra colega y amiga, y trabajaba en el mismo lugar que nosotros y estaba interesada en muchos de los mismos proyectos intelectuales que nosotros. No era más distante de nosotros que nosotros de ella y, por lo que sabíamos, sus amigos en China, a sus ojos, no serían menos cercanos a ella de lo que lo éramos nosotros. Dicho de otro modo, la carta daría lo que a cada uno de los portadores les parecerían dos saltitos -uno desde nosotros a Erica y otro desde ella a un amigo suyo en China-, que, considerados como una única fase, parecerían ser en realidad muy grandes.

Pero ¿por qué dos pasos cortos vi nen a ser por completo distintos de algo corto? En un modelo normal de retículo, como aquel que habíamos considerado primero con Steve y luego con Kleinberg, eso no sucedía, y ésa es la razón por la cual todos los modelos así (el de Kleinberg inclusive) requieren una fracción de lazos de largo alcance. Sin embargo, parece que puede suceder en el mundo social real y esta paradoja ha sido una fuente persistente de preocupación entre los sociólogos con inclinaciones matemáticas.

Ya en la década de 1950, cuando elmatemático Manfred Kochen y el politólogo Ithiel de Sola Pool trabajaron conjuntamente reflexionando sobre el problema del mundo pequeño, las distancias sociales parecían infringir una condición matemática conocida como la desigualdad del triángulo, que la figura 5.5 ilustra. De acuerdo con la desigualdad, la longitud de cada lado de un triángulo es siempre menor o igual a la suma de las longitudes de los otros dos lados. Dicho de otro modo, dar un paso y luego dar otro nunca nos llevará a mayor distancia del punto de partida que la de dos pasos. Con todo, esto era precisamente lo que nuestro hipotético mensaje parecía haber hecho.

FIGURA 5.5. La desigualdad del triángulo afirma que la distancia XAC ≤ XAB + XBC. De ahí que dos pasos cortos nunca lleguen a ser un paso largo.

¿Las redes sociales infringen la desigualdad del triángulo? Si no es así, ¿por qué parecen infringirla? La clave para entender esta paradoja de la distancia en las redes sociales es que medimos la «distancia» de dos modos diferentes, y que tendemos a confundirlos. El primer modo de medirla -aquel del que hemos hablado en la mayor parte de este libro- es la distancia a través de la red. Según esta noción, la distancia entre dos puntos, A y B, es sencillamente el número de enlaces en el camino más corto que los pone en relación y los conecta. Pero ésta no es la definición de la distancia que utilizamos típicamente cuando pensamos en lo cerca o lo lejos que nos encontramos de otra persona. Más bien, tal como Harrison me lo había recordado en el congreso de la American Association for Advancement of Science celebrado hacía ya un año, en Washington D. c., tendemos a identificarnos a nosotros mismos ya los demás en términos de los grupos, las instituciones y las actividades a las que estamos afiliados. Mark y yo, que a esas alturas ya habíamos trabajado cierto tiempo en redes de afiliación, estábamos familiarizados con la idea de identidad social.

Pero ahora nos dábamos cuenta de que los individuos no pertenecen simplemente a grupos: tienen también un modo de disponerlos en una suerte de espacio social para poder medir cuáles son sus similitudes o

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

11

diferencias con los otros. La manera en que lo hacen resulta en cierto modo similar, de hecho, al dibujo de Steinberg que hemos reproducido en la figura 5.4. Partiendo del nivel de todo el mundo, los individuos empiezan a desglosarlo en una serie manejable de categorías más pequeñas y específicas; luego desglosan cada una de estas categorías en una serie de subcategorías, y, cada una de éstas, a su vez, en categorías aún más pequeñas y específicas. Este proceso prosigue hasta arrojar una imagen de una red de afiliación similar en cierto modo a la reproducida en la figura 5.6.

FIGURA 5.6. División jerárquica del mundo en función de una sola dimensión social. La distancia entre A y Bes la altura del grupo mínimo común antecesor, que en este caso es tres (se considera que los individuos en el mismo grupo más bajo están separados por una distancia de uno).

El nivel más bajo de esta jerarquía abarca los grupos que definen nuestras afiliaciones más íntimas, es decir, nuestro edificio, nuestro lugar de trabajo o nuestros pasatiempos. Pero, a diferencia de las redes de afiliación del capítulo 4, en las cuales dos actores podían pertenecer al mismo grupo (y de ahí que estuvieran afiliados), o no, ahora podemos permitir afiliaciones de diferentes órdenes de magnitud. Dos personas pueden trabajar en equipos diferentes pero pertenecer al mismo departamento. O posiblemente trabajan en diferentes departamentos, pero pertenecen a la misma división, o quizá a la misma empresa. Cuanto más arriba en la jerarquía se tiene que ir para encontrar una agrupación común, más distantes estarán dos individuos. Y, al igual que sucedía en el modelo de KIeinberg, cuanto más lejanos son, menos probable es que se conozcan entre sí. Así, el equivalente del exponente gamma de KIeinberg en nuestro modelo era lo que dábamos en llamar el parámetro de homofilia, por el término sociológica que describe la tendencia de los seres humanos a querer asociarse con quienes se les parecen. En una red muy homófila, sólo los individuos que comparten los grupos más pequeños pueden estar relacionados, lo cual revela un mundo fragmentado de camarillas (cliques) aislado. Cuando este parámetro es cero, tenemos el equivalente de la condición de Kleinberg, en la que los individuos hacen con igual probabilidad asociaciones en todas las escalas de distancia social.

La distancia social, por tanto, funciona en buena medida del mismo modo en que lo hace en el modelo de KIeinberg, sólo que ahora hay muchos tipos de distancia a los que nos podríamos referir al evaluar la probabilidad de que dos personas se conozcan. Mientras que el retículo de KIeinberg de hecho sitúa a los individuos sólo en términos de sus coordenadas geográficas, en el mundo real, los individuos derivan sus nociones de distancia de un surtido de dimensiones sociales. La situación geográfica es importante, pero también lo es la etnia, la profesión, la religión, la formación educativa, la clase, los pasatiempos y las afiliaciones organizativas. Dicho de otro modo, cuando compartimentamos el mundo en grupos más pequeños y más específicos, nos servimos simultáneamente de múltiples dimensiones. A veces, la proximidad geográfica es decisiva, pero en otras instancias trabajar en el mismo ramo profesional, ir a la misma facultad o apreciar el mismo tipo de música, a la hora de determinar a quién conoce una persona, pueden ser mucho más relevantes que el hecho de saber dónde vive. Además, estar cerca en una dimensión no implica necesariamente proximidad o estrecha relación en otra. Al igual que el hecho de haber crecido en Nueva York no hace más probable que ejerzamos la profesión de médico y no la de profesor, que si hemos crecido en Australia, tampoco la pertenencia a la misma profesión implica necesariamente que vivamos cerca de otras personas que ejercen nuestra misma profesión.

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

12

Por último, si dos personas están cerca en sólo una dimensión, se pueden considerar a sí mismas cercanas en un sentido absoluto, aunque estén bastante alejadas en otras dimensiones. Que dos personas, usted y yo, ten1amos sólo una cosa en común -un único contexto para la interacción puede bastar para que nos conozcamos. La distancia social, dicho de otro modo, hace más hincapié en las similitudes que en las diferencias, y en ello radica la resolución de la paradoja del mundo pequeño. Tal como se puede ver en la figura 5.7, dos individuos A y B pueden tener cada uno la percepción de ser próximos o estar unidos a un tercer actor e, donde A lo es en una dimensión (pongamos, por caso, ubicación geográfica) y B, enotra (por ejemplo, la ocupación laboral). Dado que sólo cuenta la distancia más corta, no importa que e esté también bastante alejado de A y de B en algún otro sentido. Pero como A y B están lejos en las dos dimensiones, se perciben en realidad el uno al otro como muy separados. Sucede lo mismo cuando tenemos dos amigos que hemos llegado a conocer en circunstancias diferentes, y, aunque nos guste la amistad de los dos, tenemos una clara percepción de que no tienen nada en común. Pero tienen algo en común -nosotros- y tanto si son conscientes de ello como si no, de hecho están cerca. Otro modo de reflexionar sobre esta propiedad es que si bien los grupos pueden ser categorizados fácilmente, no sucede así en el caso de los individuos. La identidad social, por tanto, muestra una naturaleza multidimensional -los individuos abarcan diferentes contextos sociales-, lo cual permite explicar que la desigualdad del triangulo se vea infringida en el caso de la distancia social. A Mark y a mí nos parecía qu la naturaleza multidimensional de la identidad social de 1 s individuo ratambién aquello que permitía que los mensajes fuesen transmitidos a través de una réd aun cuando se daban lo que podrían parecer barreras sociales de enormes proporciones.

FIGURA 5.7. Los individuos dividen simultáneamente el mundo según dimensiones sociales múltiples e independientes. Este ejemplo esquemático muestra las posiciones relativas de tres individuos -A, B y C- en dos dimensiones (por ejemplo, la ubicación geográfica y la ocupación laboral). A y C están cerca en cuanto a la ubicación geográfica y B y C lo están en cuanto a la ocupación laboral que ejercen. De ahí que C se sienta cerca de A y B, Y que, en cambio, A y B se perciban como lejanos, infringiendo de este modo la desigualdad del triángulo de la figura 5.5.

En nuestras conversaciones, Mark y yo llegamos hasta este punto antes de que él tuviera que volver a

Santa Fe, momento en el cual los dos pasamos a estar demasiado ocupados como para trabajar en el problema. Al cabo de unos seis meses, Jan Kleinberg hizo una visita a la Universidad de Columbia para dar una conferencia en el departamento de Sociología centrada en la investigación que había realizado sobre el problema del mundo pequeño, y aproveché la oportunidad para comentarle nuestras ideas. No sólo se mostró de acuerdo en que nuestro enfoque parecía ser el modo correcto de plantear el problema, sino que, por su parte, ya había empezado a pensar en una línea similar. Aquello eran malas noticias para nosotros. Jan, al fin y al cabo, es el proverbial científico listo como una flecha, es de aquellos que escuchan la exposición de un problema en una conferencia por primera vez y al final de la misma ya lo comprenden mejor que la persona que lo ha expuesto. Así que, si estaba considerando nuestro enfoque -y, según lo que decía, había otros investigadores que también lo estaban haciendo-, no disponíamos de mucho tiempo para organizarnos y hacer las cosas bien.

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

13

Por fortuna para nosotros, Jan es casi tan generoso como listo, y estuvo de acuerdo en no revelar los detalles de nuestra conversación durante unos meses para darnos la oportunidad de ser los primeros en publicar algo. Aun así, tanto Mark como yo estábamos totalmente ocupados en un futuro inmediato, de modo que si queríamos hacer algo deprisa; íbamos a necesitar alguna ayuda. Menos mal que en la conversación que mantuve con Jan estuvo también presente Peter Dodds, un matemático de la Universidad de Columbia que formaba parte de mi grupo de investigación. Peter y yo ya trabajábamos en otro problema (el cual se expone en el capítulo 9) y sabía que podía programar un ordenador casi con la misma celeridad que Mark. Además Mark estaba en Santa Fe, así que a Peter lo tenía mucho más cerca. En cuestión de días, después de la visita de Kleinberg, dejamos los demás proyectos y con Peter nos pusimos a trabajar en el problema de la búsqueda. Transcurridas unas pocas semanas sorprendimos a Mark con un conjunto de resultados que eran incluso mejores de lo que habíamos esperado.

FIGURA 5.8. Será factible buscar en las redes sociales siempre que se hallen en el área sombreada del espacio de parámetros de nuestro modelo. Esta región corresponde a grupos sociales homófilos (u > 0), pero los individuos estiman la similitud en función de múltiples dimensiones (H). La condición de Kleinberg, en cambio, se sostiene sólo en un único punto situado en la esquina inferior izquierda del espacio de redes.

Nuestro principal descubrimiento fue que cuando dábamos la posibilidad a los individuos de nuestro modelo de hacer uso de dimensiones sociales múltiples, eran capaces de encontrar, con relativa facilidad, destinatarios escogidos al azar en redes muy grandes, aun cuando se diera el caso de que sus asociaciones fuesen muy homófilas. De hecho, tal como se aprecia en la figura 5.8, resulta que la existencia de redes explorables no depende demasiado del parámetro de homofilia, ni tan sólo del número de dimensiones sociales. En términos gráficos, significa que las redes en las que se pueden lanzar procesos de búsqueda existen para toda elección de parámetros que se halle en el interior de la zona sombreada que podemos ver en la figura 5.8. El equivalente de la condición de Kleinberg, en cambio, es el punto singular situado en la esquina inferior izquierda de la misma figura. Así, nuestro resultado era, en cierto sentido, el opuesto del que había obtenido Kleinberg. Mientras su condición especifica que el mundo tiene que ser de un modo muy particular para que búsquedas de mundo pequeño sean efectivas, nuestro resultado sugería que puede ser casi de cualquier modo. Con tal de que los individuos tengan más posibilidades de conocer a otras personas como ellos (parámetro de homofilia) y -lo fundamental- que siempre midan la similitud con más de una dimensión social, no sólo habrá caminos cortos entre casi cualquiera de ellos y entre casi todas las partes, sino que también los individuos que disponen sólo de información local sobre la red serán capaces de encontrarlos.

Lo que sorprendía por partida doble, sin embargo, era que se conseguían los mejores resultados cuando el número de dimensiones era sólo de dos o tres. Desde un punto de vista matemático, que así fuera tenía sentido. Cuando todos utilizan únicamente una sola dimensión (por ejemplo, la geográfica) para explorar el mundo, no pueden sacar partido de sus múltiples afiliaciones para saltar grandes distancias en el espacio social. Así, volvemos otra vez al mundo de Kleinberg, donde los lazos han de ser dispuestos equitativamente

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

14

en todas las escalas de longitud para que las búsquedas dirigidas sean efectivas. y cuando todos extienden sus contactos entre demasiadas dimensiones -cuando ninguno de nuestros amigos pertenece al mismo grupo que nuestros otros amigos- entonces volvemos otra vez al mundo de las redes aleatorias, donde los caminos cortos, si bien existen, no pueden hallarse. Así, tiene sentido que las redes en las que los caminos pueden hallarse estén en algún lugar intermedio, donde los individuos ni son demasiado unidimensionales ni demasiado dispersos. Pero el hecho de que el rendimiento óptimo se produzca cuando el número de dimensiones es más o menos dos era también otra grata sorpresa, porque ése parece ser el número que en realidad las personas utilizan.

Varios años después de que Milgram publicara su fundamental artículo sobre el mundo pequeño, otro grupo de investigadores encabezado por Russell Bernard (un antropólogo) y Peter Killworth (un oceanógrafo, lo cual no deja de ser sorprendente) llevaron a cabo lo que dieron en llamar «experimento del mundo pequeño a la inversa». En lugar de enviar paquetes y seguir su avance, como Milgram había hecho, se limitaron a describir el experimento a varios cientos de individuos que decidieron participar en él y a preguntarles por el criterio que utilizarían para dirigir un paquete si les pedían que lo hicieran. Lo que este grupo de investigadores descubrió fue que la mayoría de los individuos se servían sólo de un par de dimensiones -las más dominantes eran la geografía y la ocupación laboral- para dirigir sus mensajes hasta el siguiente destinatario. El hecho de que el mismo número apareciera en nuestro análisis, transcurrido todo un cuarto de siglo y sin haberlo provocado de manera especial (no teníamos ni idea de cuál sería, pero no pensábamos que fuese dos), sorprendía por ser bastante destacable. Pero conseguimos otro aún mejor.

Al introducir en nuestro modelo las estimaciones de los parámetros más o menos tal como se hubieran aplicado al experimento de Milgram, pudimos comparar nuestras predicciones con los resultados reales de Milgram. La figura 5.9 muestra la comparación. Los dos conjuntos de resultados no tan sólo parecen más o menos comparables, sino que utilizando pruebas estadísticas estándares son indistinguibles unos de otros. Son, a todos los efectos prácticos, los mismos. A tenor de las enormes libertades que nuestro modelo se toma en relación con las complejidades del mundo, este resultado era una auténtica maravilla. Para ver cómo funciona, retomemos el ejemplo del hipotético campesino chino. A! escoger a nuestra amiga Erica como nuestro primer intermediario, estábamos utilizando dos conjuntos de información. Primero, nuestra noción de distancia social nos llevaba a concluir que estábamos bastante alejados de nuestro destinatario. Pero también nos decía a qué grupos debía pertenecer alguien para estar cerca. Nuestra noción de distancia social, por tanto, nos ayuda a identificar las condiciones que hacen de un individuo un buen candidato para pasarle el mensaje. Y, en segundo lugar, hacíamos uso de nuestro conocimiento local de la red para determinar si alguno de nuestros amigos satisfacía alguna de estas condiciones, es decir, si alguno de nuestros amigos pertenecía al menos a un grupo que lo hacía estar más cerca del destinatario. El hecho de que hubiera vivido en China, convertía a Erica en una buena candidata.

FIGURA 5.9. Resultado del modelo de búsqueda en una red social comparado con los resultados para Nebraska de Milgram. Las barras representan las cuarenta y dos cadenas completadas que se iniciaron en Nebraska, y la curva es la media entre muchas búsquedas simuladas realizadas en conformidad con nuestro modelo.

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

15

Éste es en esencia el método que utilizaron los sujetos de Milgram y, por tanto, nuestros modelos

demuestran cómo, con tal de que los individuos tengan al menos dos dimensiones con las cuales estimar su similitud con respecto a los otros, aun en un mundo en el cual la mayoría de la relaciones que estableciesen fuesen con personas muy similares a ellos, podrían encontrar caminos cortos que les llevaran hasta individuos incluso distantes y extraños. El hecho de que la concordancia entre nuestro modelo y los resultados de Milgram sea tan firme, y en buena medida de manera independiente del modo en que escojamos los parámetros particulares, permite colegir algo más serio acerca del mundo social. A diferencia de las redes de generadores de electricidad o de las neuronas en el cerebro, los individuos en las redes sociales tienen sus propias ideas acerca de qué les hace ser lo que son. Dicho de otro modo, en una red social cada individuos viene acompañado por una identidad social que, al impulsar tanto la creación de la red como las nociones de distancia que permiten a los individuos navegar por ella, hace posible la búsqueda en las redes.

BÚSQUEDA EN REDES PUNTO A PUNTO (peer to peer)La posibilidad de lanzar procesos de búsqueda en la red (searchability) es, por tanto, una propiedad

genérica de las redes sociales. Al desglosar el mundo del modo en que lo hacemos -según nociones múltiples simultáneas de distancia social- y al descomponer el proceso de búsqueda en fases manejables, podemos resolver con relativa facilidad un problema que parecía tremendamente difícil (basta con intentar jugar al Seis Grados de Separación de Kevin Bacon sin el ordenador). Al igual que sucede con tantas de las cosas que de pronto comprendemos, el hecho de darnos cuenta de que las redes tienen que provenir de algún lugar y que su origen en la identidad social es decisivo para las propiedades que con posterioridad muestran, nos parece ahora evidente. Pero en una ciencia cada vez más dominada por la física, la reentrada de la sociología en escena era un avance intelectual significativo. Y lo que hemos aprendido es que mientras que los modelos sencillos no tienen nada de malo, para cualquier realidad compleja existen muchos de esos modelos, y sólo reflexionando a fondo sobre el modo en que el mundo funciona -sólo pensando como lo hacen los sociólogos y los matemáticos- podremos escoger el correcto.

Existe, no obstante, una razón práctica para entender las búsquedas dirigidas en redes, a saber, el proceso de hallar a una persona destinataria en una red social, a través de una cadena de conocidos intermediadores, es en esencia lo mismo que encontrar un archivo o cualquier otro trozo de información especificada de forma única en una base de datos de distribución. En fecha reciente se ha prestado bastante atención al potencial de las redes llamadas P2P (peer to peer) o punto a punto, sobre todo en el sector de la música. La primera generación de este tipo de redes, el arquetipo de las cuales es el célebre Napster, no era más que una red P2P, aunque en un sentido limitado. Si bien los archivos mismos se hallan situados en los ordenadores personales de cada individuo -usuarios iguales (peers)- y los intercambios de archivos se producen directamente entre los usuarios, en el servidor central se mantiene un directorio completo de todos los archivos disponibles (y sus ubicaciones).

En principio, un directorio central hace que el problema de encontrar la información buscada sea trivial, aun en redes muy grandes, pues basta con formularle la pregunta al directorio y éste indica la ubicación del archivo. Pero los directorios centrales resultan caros de crear y mantener. Desde el punto de vista del usuario, los motores de búsqueda en Internet, como, por ejemplo, Google, actúan como directorios centralizados, y, en general, hacen un trabajo razonable de ubicación de la información (a pesar de la ocasional frustración). Pero Google no es como cualquier website habitual. A fin de poder tratar las enormes demandas de procesamiento formuladas por millones de preguntas simultáneas, abarca decenas de miles de servidores de capacidad high end. Hace un par de años, en un congreso celebrado en San Francisco, tuve oportunidad de escuchar a Larry Page, uno de los fundadores de Google, hablar de su empresa: dijo que cada día se sumaban una treintena de nuevos servidores a fin de poder seguir dando respuesta a la demanda. Los directorios centrales puede que sean una solución efectiva para el problema de la búsqueda, pero no son baratos. Una arquitectura centralizada, además, puede resultar bastante vulnerable, tal como los usuarios de Napster pudieron descubrir cuando su mecanismo favorito de intercambio de archivos de música fue cerrado por la furiosa industria discográfica. y de ahí que en una línea aérea que sólo dispone de un único hub o conector a través del cual tienen que pasar todos los vuelos, cuando el centro falla, todo el sistema se desmorone.

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

16

Antes de que Napster entrara en su agonía final, sin embargo, aun las formas más radicales de base de datos distribuidas -a las cuales podríamos denominar como las verdaderas redes P2P o punto a punto- ya habían empezado a hacer acto de aparición en el submundo de Internet. Una de ellas, llamada Gnutella, fue diseñada por un programador que se rebeló contra su antigua empresa, American On-Line (AOL), y que colgó el protocolo desarrollado del programa en la web de AOL en algún momento del mes de marzo de 2000. Sabiendo que en potencia no estaba cumpliendo con los derechos de propiedad intelectual implícitos en cualquier sistema que permita compartir los archivos y al corriente también de la recién consumada fusión con Time Warner, la dirección de AOL cortó por lo sano y eliminó el código open source que infringía la ley cuando hacía apenas media hora que había sido publicado en la red. Pero, aun así, lo hicieron demasiado tarde: ya había sido descargado y circulaba como una droga por el sistema sanguíneo de la comunidad hacker, generándose docenas de actualizaciones y variantes. Uno de los primeros en hacer proselitismo en favor de Gnutella fue un joven ingeniero informático, Gene Khan, para quien Gnutella era la respuesta a las oraciones de todos y cada uno de los intercambiadores de archivos y la Némesis imparable de la industria discográfica. Por el hecho mismo de que era sólo un protocolo, no podía ser confiscado. y dado que no tenía centro, no había a quién demandar ni qué cerrar. Escuchando a Khan, uno llegaba a creerse que Gnutella era indestructible y todopoderoso.

Transcurrido un año, se demostró que Khan sólo tenía parte de razón. Nadie había conseguido destruir Gnutella, aunque por entonces tampoco parecía haber demasiada necesidad de hacerlo. Gnutella, a juzgar por las apariencias, se metió en un brete debido sobre todo a la misma arquitectura diseminada que le había hecho ser tan prometedor. Dado que ningún servidor sabía dónde estaban todos y cada uno de los archivos -dado que no hay un directorio central-, cualquier demanda pasaba a ser una búsqueda diseminada que en efecto preguntaba a todos y cada uno de los nodos de la red: «¿Está ahí el archivo?». Así, una red punto a punto como Gnutella, que por entonces contenía miles de nodos, generará del orden de unas diez mil veces más mensajes que una red similar a la que había utilizado Napster (cliente servidor) del mismo tamaño y en la cual cada petición es enviada a un único servidor de alta capacidad. Dado que el objetivo de una red punto a punto es llegar a ser lo más grande posible (a fin de aumentar el número de ficheros disponibles), y dado que cuanto más grande es la red, peor será su rendimiento, ¿no será que las verdaderas redes punto a punto son en sí mismas contraproducentes?

Fortuitamente la clase de sexto curso de la asignatura de sociales en la Escuela Primaria de Taylorsville, en Carolina del Norte, desveló, hace más o menos un año, un mundo con un dejo similar al de Gnutella. Al acometer el desarrollo de un «proyecto de correo electrónico», la maestra de esta clase, Janet Forrest, y sus alumnos enviaron un simpático y escueto mensaje a sus familiares y amigos, añadiendo la petición de que, cuando lo recibieran, lo remitieran a su vez a «cualquier persona que conozcas para que lo envíen a su vez a todas las demás personas que conozcan... ». Pedían, además, que cada destinatario les respondiera de modo que pudieran mantener el registro del número de personas a las que les había llegado y de dónde eran. Nefanda idea. Cuando, al cabo de unas pocas semanas, el proyecto fue finalmente cerrado, la clase había recibido 450.000 respuestas de cada uno de los Estados de la Unión y 83 de otros países. ¡Y sólo se contabilizan las personas que respondieron! Ahora imaginemos que cada curso de sexto de primaria tratara de realizar en la asignatura de ciencias sociales un experimento similar. (Increíblemente, recibí otro mensaje similar no hace mucho de una escuela de Nueva Zelanda, firmado por nada más y nada menos que por el ministro de Educación neozelandés. A algunos les cuesta aprender.) y lo que es aún peor, imaginemos que cada vez que alguien quisiera hacer llegar un mensaje a alguien más, iniciara exactamente este tipo de difusión mundial. La era de Internet se precipitaría a un rápido e ignominioso final, atorada en uria congestión de tráfico peor que la de una autovía de Bangkok.

En general, por tanto, los directorios centrales son carros y vulnerables, y las búsquedas diseminadas dan más problemas que alegrías. En consecuencia, los algoritmos eficientes de búsqueda que necesitan sólo de una red local información serán de considerable interés práctico. Así, uno de los aspectos más enigmáticos del fenómeno de mundo pequeño es que los individuos integrados en redes sociales parecen capaces de resolver problemas de búsqueda punto a punto, aunque ellos mismos no sepan qué están haciendo. Al comprender y sacar partido de las propiedades de la versión sociológica del problema, podemos esperar, por tanto, que idearemos soluciones novedosas para los problemas de búsqueda en redes que no tienen necesariamente que involucrar, en absoluto, a las personas. Se han propuesto algunas otras soluciones al problema de los procesos de búsqueda en redes punto a punto, o P2P, que vienen a complementar el enfoque que, hemos dado al

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

17

problema y que sacan partido de otros aspectos de la estructura de red. Entre estos esfuerzos, uno de los más notables es el de Bernardo Huberman y su alumno Lada Adamic, del laboratorio de investigación de Hewlett Packard en Palo Alto, California.

Adamic y Huberman, tras observar que la distribución de grado de la red parece seguir una ley potencial (con ciertos límites), propusieron un algoritmo de búsqueda a través del cual los nodos dirigen las peticiones a su vecino más conectado, e cual comprueba entonces su directorio y los directorios de sus vecinos para encontrar una copia d 1 archivo buscado, y repite el procedimiento si no llega a encontrarlo. De esta manera, cada petición rápidamente ubica a uno de los relativamente pocos hubs o conectores, que son característicos de las redes sin escalas, y, juntos, son conectados a la mayor parte de la red. Al lanzar procesos de búsqueda aleatoriamente en esta red de conectores, el grupo demostró que la mayoría de los archivos podían ser hallados en un espacio relativamente corto de tiempo sin sobrecargar con ello el conjunto de la red. A pesar de ser ingenioso, este modo de enfocar las cosas adolece, sin embargo, de una versión débil de la solución propia del directorio centralizado: los conectores o.h deben tener mucha mayor capacidad que los 'nodos ordinarios, y el rendimiento de la red depende sensiblemente de la operatividad de los conectores que son decisivos. En cambio, lanzar procesos de búsqueda en las redes sociales parece un ejercicio muy igualitario. En nuestro modelo, los individuos corrientes son capaces de encontrar caminos cortos, de modo que no se requiere la presencia de hubs o conectores especiales.

Tal vez, la cuestión principal es que, al alentar soluciones novedosas a problemas (en apariencia) diferentes, el problema del mundo pequeño proporciona un ejemplo perfecto de cómo las diferentes disciplinas se pueden ayudar unas a otras a elaborar la nueva ciencia de las redes. Ya en la década de 1950, Kochen (un matemático) y Pool (un politólogo) fueron los primeros en pensar también en ello, pero, al no disponer de ordenadores, no llegaron a encontrar una solución. Milgram (que era psicólogo), ayudado por White, físico y sociólogo, y seguidos por Bernard y Killworth, que eran, respectivamente, antropólogo y oceanógrafo, abordaron entonces el problema desde su vertiente empírica, pero no llegaron a explicar de qué modo funcionaba en realidad. Al cabo de tres décadas, Steve y yo mismo, ambos matemáticos, convertimos el problema en una cuestión sobre redes en general, pero no llegamos a ver su componente algorítmico y dejamos de este modo la puerta abierta a Jan, un ingeniero informático. Jan, a su vez, abrió la puerta a Mark, que es físico, a Peter, que es matemático, y a mí mismo, que en la actualidad se me podría calificar de sociólogo, para que entráramos y escogiéramos la solución que ahora nos parece que siempre estuvo ahí.

Sin embargo, ha sido preciso recorrer una larga senda de casi medio siglo y ahora, cuando pensamos que finalmente entendemos el problema, nos parece que alguien debió de entenderlo y explicarlo hace ya mucho; tiempo. Pero tenía que suceder así. Sin la intervención de Jan, por ejemplo, nunca hubiéramos comprendido e1 modo de pensar el problema de la búsqueda, no hubiéramos sabido qué puerta cruzar. Y sin nuestro anterior trabajo sobre las redes de mundo pequeño, Jan nunca se hubiera puesto a pensar en el problema. Sin Milgram, ninguno de nosotros hubiéramos sabido qué estábamos tratando de explicar. Y sin Pool y Kochen, Milgram se hubiera puesto a hacer un experimento diferente. Visto a posteriori, todo parece evidente, pero la verdad de la cuestión es que el problema del mundo pequeño sólo se resolvería a través del esfuerzo combi' nado de muchos pensadores distintos que llegaron a planteárselo desde todos los ángulos y que aportaron una increíble diversidad de habilidades, técnicas, ideas y perspectivas. En ciencia, al igual que sucede en la vida, no se puede hacer avanzar la cinta para ver qué final nos espera, porque el final se va escribiendo sobre la marcha. Y del mismo modo en que sucede también con los filmes más taquilleros de Hollywood, el final, aun cuando aporta cierta sensación de resolución, es meramente un prólogo para la secuela. Para nosotros, la secuela fue la dinámica. Y junto a los enigmas de las dinámicas en una red -ya se trate de las epidemias de enfermedades, los fallos en cascada de distribución de energía eléctrica o los estallidos de las revoluciones-, los problemas de las redes que hemos encontrado hasta ahora son sólo como un puñado de guijarros en la playa.

Watts, Duncan J. 2006. Seis grados de separación. La ciencia de las redes en la era del acceso. Barcelona; Paidós, 2006.

18

Capítulo 6

Epidemias y apagones

LA ZONA CALIENTEA casi todos, para qué negarlo, la posibilidad de que se produzcan epidemias catastróficas no nos

quita el sueño. Quizá sea porque la mayoría no hemos leído Zona caliente, el libro en que Richard Prestan cuenta la verdadera historia del ébola, un virus increíblemente letal que mata a su víctima en un macabro delirio de hemorragias de una furia tan cruel que sólo la naturaleza pudo haberlo ideado. El virus, que tomó prestado el nombre del río Ébola, que avena las regiones septentrionales del antiguo Zaire, actual República Democrática del Congo, salió en 1976 por primera vez de su escondrijo en el interior de las selvas. Asoló primero Sudán y luego, al cabo de dos meses, el Zaire, donde irrumpió en cincuenta y cinco aldeas de manera casi simultánea, cobrándose casi setecientas vidas sólo durante aquel año.

Si bien es muy poco lo que conocemos, se cree que el ébola saltó, como el virus de la inmunodeficiencia adquirida, de los monos a los seres humanos por lo menos a través de tres cepas, cada una de ellas más mortífera que la anterior. El brote de ébola que recientemente se registró en Uganda fue debido a la cepa Sudán, que, con una tasa de mortalidad de sólo el 50 %, es el alfeñique de la familia (el ébola Zaire se cobra el 90 % de sus víctimas). Aun así, en el distrito de Gulu, entre los meses de octubre de 2000 y enero de 2001, murieron 173 personas, antes de que el brote siguiera su curso. Durante las tres últimas décadas, otros brotes se han cobrado la vida de un número similar de seres humanos en circunstancias más o menos análogas, principalmente en pequeñas aldeas aisladas con escasas instalaciones sanitarias. A su paso, estos brotes han dejado innumerables historias de horror: las víctimas acudían a los médicos locales para visitarse, aquejadas de síntomas similares a los de la gripe, y al cabo de unos pocos días caían desplomadas, desangrándose en el hospital más cercano. Aquélla era la prueba -por lo general percibida demasiado tarde- de que el ébola había asolado la zona. El heroico personal sanitario que perdió la vida en la primera línea de defensa; el pánico generalizado; docenas de cuerpos desangrados hallados en cabañas abandonadas; aldeas asoladas y desiertas; todas las regiones aterrorizadas. El ébola, qué duda cabe, es un monstruo y un mensajero del Infierno.