ejercicio04

-

Upload

emilio-d-najera -

Category

Documents

-

view

212 -

download

0

description

Transcript of ejercicio04

UNIDAD 4: ¿Cuáles son las aplicaciones

de las cadenas de Markov?

Ejercicio 4

Procesos Markovianos finitos

Por M.A., Fís. Jorge Rivera Hernández

Introducción

Aunque hemos visto la forma de obtener la solución del estado estable de una cadena de

Markov, eso no significa que se llegue a dicha solución en unos cuantos pasos de la cadena.

De hecho, como se revisó en los ejercicios anteriores, incluso ni después de 10 o más pasos

del proceso se veía una tendencia clara de la solución estable del proceso markoviano. De

hecho, dado que siempre queda una cantidad de probabilidad por transferir entre los diferentes

estados del proceso, el número de etapas para llegar al resultado final estable se torna infinito.

El concepto de finitud de una cadena no tiene que ver con el número de transiciones para llegar

al estado estable, sino con el número de estados posibles en que puede estar el sistema. Si los

estados en que puede estar un sistema son: S1, S2, S3,…, Sn donde n es un número finito,

entonces la cadena es finita.

De los diferentes procesos que puede tener una cadena markoviana, sobresalen dos como

casos especiales. Se trata del proceso que posee un estado absorbente, lo que significa que

tarde o temprano dicho estado terminará por “comerse” toda la probabilidad y el estado final

estable será cuando el estado absorbente tenga el 100% de probabilidad de que el sistema se

encuentre en él. La probabilidad de estar en cualquiera de los otros estados es naturalmente

cero. Si el proceso se refiere a la transferencia de clientes de una marca a otra, el estado

absorbente se “come” a todos los consumidores y la marca correspondiente se queda con el

100% del mercado. Este proceso de absorción puede darse por concluido cuando el número de

consumidores de las otras marcas sea menor de uno, ya que deben tener un número entero de

consumidores.

El otro proceso es el que se conoce como cíclico, porque en el estado final de equilibrio, el

sistema termina con una secuencia predecible de transferencia entre estados.

Unidad 4 EM42/DM35 1 de 7

UNIDAD 4: ¿Cuáles son las aplicaciones

de las cadenas de Markov?

Otro tipo de proceso que reviste cierto interés es cuando existen dos o más estados

absorbentes. Cualquiera de ellos puede constituirse en el estado final de equilibrio, y la

probabilidad de llegar a serlo depende del estado inicial del proceso markoviano.

Supongamos que el estado k es absorbente, entonces, si el proceso inicia en el estado k,

jamás saldrá de él. Para analizar la probabilidad de que el estado k se constituya en el estado

final de equilibrio, debe suponerse que no se inicia en él ni en ningún otro estado absorbente.

Para que tenga sentido el problema, debe iniciarse en un estado no absorbente.

Es posible demostrar que la probabilidad que tiene una cadena de Markov de terminar en el

estado absorbente k, partiendo del estado no absorbente i, (Pi k), satisface la siguiente

ecuación:

Ecuación 1

Donde Pj k = 0 si j es un estado absorbente P

Armando todas las ecuaciones correspondientes a todos los estados no absorbentes i, se llega

a un sistema de ecuaciones que permite calcular la probabilidad de terminar en el estado

absorbente k si se inició en el estado no absorbente i.

Tiempo de primera pasada

Este es un concepto útil en el estudio de la duración de un proceso. Se define como el número

de transiciones para que el proceso vaya por primera vez del estado i al estado j. En el caso

especial en que i = j, estaríamos calculando el tiempo de recurrencia del estado i, es decir, el

tiempo que necesita para regresar a sí mismo. Conocer este tiempo de recurrencia, medido

como número de transiciones, es de interés cuando el estado es absorbente o parte de una

secuencia cíclica.

Unidad 4 EM42/DM35 2 de 7

UNIDAD 4: ¿Cuáles son las aplicaciones

de las cadenas de Markov?

Para calcular los tiempos esperados de primera pasada de todos los estados de una cadena

markoviana, tiene que resolver el siguiente sistema de ecuaciones simultáneas:

Ecuación 2

Donde i j son los tiempos esperados de primera pasada, desde el estado i hasta el estado j, y

los p i j son los elementos de la matriz de transición, es decir, la probabilidad de que el sistema

vaya del estado i al estado j.

En la literatura se demuestra que si j es la probabilidad que tiene el estado j en la situación

estable, entonces esta probabilidad es igual al inverso del tiempo de recurrencia, esto es:

Fórmulas

Siendo n el número de estados posibles de un sistema.

Estos ejercicios tienen como finalidad que practique los conceptos anteriores, relacionados con

la duración de un proceso markoviano antes de llegar al estado de equilibrio. Si bien es cierto

que el número de transiciones es infinito, en el caso de las cadenas de Markov irreducibles y

ergódicas, es decir, con estados recurrentes y no periódicos, si los estados de la cadena de

Markov presentan estados cíclicos o absorbentes, se puede pronosticar cierto comportamiento

en un número finito de transiciones.

Unidad 4 EM42/DM35 3 de 7

UNIDAD 4: ¿Cuáles son las aplicaciones

de las cadenas de Markov?

Instrucciones: Lea detenidamente los siguientes ejercicios y resuelva con claridad lo que se

solicita. Puede apoyarse en la hoja de cálculo Excel. Recuerde que con esta

hoja de cálculo pueden realizarse multiplicaciones matriciales y programarse

la solución de sistemas de ecuaciones.

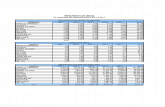

1. Consideremos el caso de tres compañías telefónicas que operan en un estado benevolente

con las grandes compañías, permitiéndoles monopolizar los servicios. Llamaremos a estas

telefónicas T, U y V. La siguiente tabla muestra el número de consumidores que

actualmente posee cada compañía y los porcentajes de sus clientes que se quedan o

cambian a las otras. La compañía T acapara prácticamente toda la infraestructura del

estado en materia de comunicación, lo que le permite disminuir notablemente sus gastos

operativos y por lo tanto ofrecer tarifas de telefonía extremadamente bajas, lo cual hace

prácticamente inexistente cualquier competencia de las compañías U y V, que están viendo

notablemente disminuida su clientela en cada estado de resultados.

A:

T U V

T 1 0 0

De: U 0.3 0.6 0.1

V 0.4 0.1 0.5

Con base en esta información:

a. Construya la matriz de transición, ¿detecta algún estado absorbente?

[ 1 0 00.3 0.6 0.10.4 0.1 0.5]

Si, claramente el estado absorbente se sitúa en la marca T, la cual argumenta que el

100% de sus clientes volverían a contratar el servicio, y 0% se cambiaría a otra marca.

Eso quiere decir que esta marca no puede perder clientes, por el contrario solo puede

ganar más clientes; en contraparte, las otras marcas solo pueden perder clientes o

ganarlas entre ellas (solo U y V), lo que podría tender a una situación de absorbencia.

Unidad 4 EM42/DM35 4 de 7

UNIDAD 4: ¿Cuáles son las aplicaciones

de las cadenas de Markov?

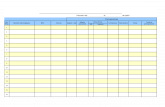

b. Estudie la cadena de Markov correspondiente hasta 15 pasos adelante. Observe que el

pez grande se come al chico. De las 15 transiciones, ¿habrá alguna en la que ya se dé

por concluido el proceso? Es decir, ¿en alguno de los pasos las compañías U y V se

han quedado con menos de un cliente? Suponga que la compañía T tiene 20 millones

de clientes, la compañía U 6 millones y la V 2 millones.

Si se toma como estado inicial absorbente de la marca T, instantáneamente surge la

situación absorbente y deja a las demás marcas con 0 clientes.

c. Calcule mediante el método matricial la situación final de equilibrio y verifique que en

verdad el estado absorbente termina por quedarse con el 100% del mercado.

2. La burocracia puede generar malas experiencias. La siguiente tabla muestra la matriz de

transición entre cuatro departamentos de una oficina de gobierno que se encarga de

autorizar la apertura de pymes.

ASESORÍA REVISIÓN

DOCUMENTACIÓ

N AUTORIZACIÓN

Asesoría 0.1 0.2 0.2 0.5

Revisión 0 1 0 0

Documentación 0.3 0.4 0.1 0.2

Autorización 0 0 0 1

Observamos que existen dos estados absorbentes, revisión y autorización. Este último

implica los permisos para iniciar el negocio, pero si tenemos la mala suerte de caer en el

departamento de revisión, los trámites quedarán estancados, a menos que hagamos algo

por cambiar las probabilidades de transición, pero en este caso estaremos en otra cadena

de Markov. Los estados de asesoría y documentación no son absorbentes.

Llamaremos a estos estados 1, 2, 3 y 4, respectivamente. Utilice la ecuación 1 presentada

al principio de esta parte del cuaderno para determinar:

a. La probabilidad de que un trámite que inicia en el estado 1, termine estancado en el

estado 2.

Unidad 4 EM42/DM35 5 de 7

UNIDAD 4: ¿Cuáles son las aplicaciones

de las cadenas de Markov?

b. La probabilidad de que un trámite que inicia en el estado 1, termine en el estado 4.

c. La probabilidad de que un trámite que inicia en el estado 3, termine estancado en el

estado 2.

d. La probabilidad de que un trámite que inicia en el estado 3, termine en el estado 4.

3. Consideremos la siguiente tabla de transferencia porcentual entre 3 estados.

A:

A: B C

A 0.5 0.3 0.2

De: B 0.2 0.7 0.1

C 0.2 0.2 0.6

Con base en estos datos:

a. Determine la probabilidad de estar en estos estados en la solución estable.

b. Utilice las 2 ecuaciones presentadas al inicio de esta parte del cuaderno, para

determinar los tiempos esperados de primera pasada para cada uno de estos estados.

c. Usando los cálculos de los dos incisos anteriores, compruebe la veracidad de las

fórmulas presentadas al principio de esta parte del cuaderno.

4. Una brigada de reparación de asfalto utiliza taladros para levantar el piso. Al terminar la

jornada, envía los taladros dañados al taller para su reparación o mantenimiento. El resto

de los taladros los manda al almacén. En la creencia de que todos los empleados se

conocían, se eliminaron las órdenes de trabajo que se intercambiaban el taller y el almacén.

Unidad 4 EM42/DM35 6 de 7

UNIDAD 4: ¿Cuáles son las aplicaciones

de las cadenas de Markov?

Actualmente, el almacenista cree que todos los taladros que le llegan son para enviarlos al

taller para su mantenimiento, y al revés, cuando el taller termina el mantenimiento, envía los

taladros al almacén bajo el supuesto de que ellos se encargarán de distribuirlos. La

siguiente tabla muestra los porcentajes de taladros que se envían de un lado a otro:

A:

BRIGAD

A

TALLE

R ALMACÉN

Brigada 0 0.3 0.7

De: Taller 0 0 1

Almacén 0 1 0

Con base en la información anterior:

a. Elabore la matriz de transición.

b. Si la brigada inicia el primer estado con 100 taladros, construya los siguientes 10

estados para ver la historia de éstos.

c. Inicie ahora con los 100 taladros pero en el almacén, ¿qué le está ocurriendo a los

taladros?

Unidad 4 EM42/DM35 7 de 7