SG24

description

Transcript of SG24

Software Guru CONOCIMIENTO EN PRÁCTICA

www

.sof

twar

egur

u.co

m.m

xS

OFT

WA

RE

GU

RU

CO

NO

CIM

IEN

TO

EN

PR

ÁC

TIC

A

May

o-Ju

lio 2

00

9

No.24 • Mayo-Julio 2009 • www.sg.com.mx

[ Tutorial ] AzureNoticias • Industria • Fundamentos • Carrera • Infraestructura • Gadgets

No.

24

• Auditoría de procesos

• Arquitectura de software

• Requerimientos con SysML

México, $65.00

[ ENTREVISTA ]

Jorge ZavalaInnovación y desarrollo de negocios globales

Desarrollo para smartphones

[ REPORTAJE ]Software enNuevo León

MAY-JUL 2009 www.sg.com.mx

Dirección EditorialPedro Galván

Dirección de OperacionesMara Ruvalcaba

Coordinación EditorialAlejandro Escamilla

Arte y DiseñoDafne Ortega, Oscar Samano

Consejo Editorial Jorge Valdés - PMI; Luis Cuellar - Softtek;

Francisco Camargo, Luis D. Soto - Microsoft; Hanna Oktaba - UNAM;

Ralf Eder, Raúl Trejo - ITESM;Emilio Osorio - Sistemas Humanos;

Luis Vinicio León - e-Quallity.

ColaboradoresBenjamín Ruvalcaba, Miguel Angel Morán, Misael Monterroca, Germán Dominguez,

Héctor Obregón, Edgar Parada, José Karam, Carlos Silva, Romeo Márquez, Gunnar Wolf

Yolanda Fernández, Leticia Arevalo,Jesús Soria, Edith Martínez

Alejandro Bianchi, Gastón Milano, Charlie Macías, Marco Dorantes,Consuelo Jiménez, Beatríz Ríos,Luis Joyanes, Susana Tamayo,

Fernando García.

Ventas Claudia Perea

Marketing y RP Paulina Olivares

Circulación y Administración Edgar Dorantes

Desarrollo WebNathanael Gutiérrez

+52 55 5239 5502

SG Software Guru es una publicación trimestral editada por Brainworx S.A. de C.V., Malinche no. 6, Col. El Parque, C.P. 53398, Naucalpan, México. Queda prohibida la reproducción total o parcial del contenido sin previo aviso por escrito de los editores. Todos los artículos son responsabilidad de sus propios autores y no necesariamente reflejan el punto de vista de la editorial. Reserva de Derechos al Uso Exclusivo: 04-2004-090212091400-102. Certificado de licitud de título: 12999. Certificado de licitud de contenido:10572. ISSN: 1870-0888. Registro Postal: PP15-5106. Se imprimió en mayo de 2009 en Roma Color, S.A. de C.V. Distribuido por Sepomex.

directorio

Editorial

// CONTENIDO

02

Hace algunos años, en el número 5 de SG (Septiembre-Octubre 2005) un autor afirmó que “el software que hará realmente útiles a los dispositivos móviles todavía no se ha desarrollado.”

Cuatro años han pasado y ahora estamos listos para afrontar los retos y salir airo-sos. Los lenguajes de programación han madurado, el mercado está en el momen-to oportuno y el talento mexicano siempre ha estado presente. Las cartas apuntan a la gran oportunidad que se presenta para desarrollar aplicaciones para dispositivos móviles, especialmente smartphones.

Presentamos una entrevista muy intere-sante con Jorge Zavala, quien actualmente dirige la oficina de TechBA en Silicon Valley. Jorge nos proporciona una interesante vi-sión de cómo convertir las ideas en gran-des empresas, y nos comparte su perspec-tiva sobre la vida en Silicon Valley.

En esta edición incluimos un reportaje es-pecial sobre la industria del software en Nuevo León, presentando un panorama de lo que se está realizando en el estado, resultado de la exitosa colaboración entre academia, empresas y gobierno.

Teniendo esto en cuenta, no es coinciden-cia que Monterrey vaya a ser la sede de SG ‘09 Conferencia y Expo, que se realizará los días 27 al 30 de septiembre. Asegúrense de marcar la fecha en sus planes de proyecto y prepararse para una experiencia única.

Una excelente noticia es que estamos es-trenando nuestro nuevo proyecto SG Guía. Esta es una herramienta a través de la cual podrán encontrar los productos y servicios que necesitan para desarrollar software de alta calidad. Los invitamos a que colabora-ren y evalúen las herramientas, servicios, capacitación y aplicaciones contenidos en SG Guía.

» Equipo Editorial

MAY-JUL 2009www.sg.com.mx

Columnas

Tejiendo Nuestra Red 08por Hanna Oktaba

Mejora Continua 10por Luis Cuellar

Programar es un Modo 50de Vida por Gunnar Wolf

Prueba de Software 52por Luis Vinicio León

Columna Invitada 54por Marco Dorantes

Tendencias en Software 56por Luis Daniel Soto

20

Productos

Lo QUE VIENE 12RubyMine, CloudBurst, Dryad y Moblin

HERRaMIENTaS 14Web testing con Visual Studio

TUToRIaL 16Aplicaciones en la Nube con Azure

Prácticas

CaSo DE ESTUDIo 34SG GuíaCompartimos algunas prácticas aplicadas durante el desarrollo de este proyecto.

MEJoRa DE PRoCESoS 36MoProSoft y la auditoría de ProcesosGuía para la realización de una auditoría.

aSEGURaMIENTo DE CaLIDaD 38Medición y análisisRecomendaciones para obtener buenas métricas.

aRQUITECTURa 40El Valor de los Ciclos Guiados por la arquitectura del SoftwareAlejandro Bianchi comparte los beneficios de un ciclo de vida centrado en la arquitectura de software.

PRoGRaMaCIÓN 44Programación DeclarativaUn vistazo a sus características y ventajas.

PM CoRNER 46Revisión de la 4ta edición de la Guía PMBoKPresentamos los principales cambios que sufrió la guía PMBOK en esta nueva versión.

UML 48Los requerimientos al estilo SysMLAprenderemos los principales elementos parahacer diagramas al estilo de SYSML.

EN PORTADA 22

Desarrollo de aplicacionespara smartphones

contenido may - jul 2009

03

En Cada Número

NoTICIaS y EVENToS 04

INDUSTRIa 06

FUNDaMENToS 58

EntrevistaJorge ZavalaInnovación y desarrollo de negocios globales

INFRaESTRUCTURa 60

GaDGETS 62

CaRRERa 64

22

MAY-JUL 2009 www.sg.com.mx

// NOTICIAS

04

IBM Industry Forum 2009Con el objetivo de apoyar a las empresas a innovar en su industria y competir de manera más eficaz para responder a los desafíos globales, IBM presentó el Industry Forum 2009, del pasado 9 al 11 de marzo en la Ciudad de México.

La estructura de la agenda fue muy buena y brindó contenido para todo tipo de intereses, ya que el primer día consistió en conferencias magistrales con enfoque de negocio, mientras que el segundo día fue dominado por sesiones simultáneas orienta-das a industrias específicas y el tercer día estuvo dirigido a los temas técnicos: tecnologías y herramientas, mejores prácticas y nuevas tendencias.

Tendencias 2009: Modelos de competitividad con TIC en México

El pasado 18 de marzo, en la Ciudad de México, se realizó con éxi-to el evento Tendencias 2009, evento que Select ha organizado de forma consecutiva desde hace 16 años. El evento estuvo enfo-cado en demostrar la contribución de las TICs y la competitividad de las organizaciones a través de seis casos de éxito mexicanos, así como de talleres de benchmarking.

La audiencia estuvo integrada por ejecutivos de alto nivel que cola-boran tanto en organizaciones públicas y privadas, así como repre-sentantes de la industria de TIC, todos ellos interesados en identifi-car las estrategias para competir y aprovechar la tecnología.

MéxicoFIRSTCon la meta de incrementar la cantidad de personas certificadas en nuestro país, la iniciativa de CANIETI “MéxicoFIRST” presentó en conjunto con la empresa Sun Microsystems, el proyecto en-focado en certificar en Java a 12mil estudiantes y profesionistas de TI. Gracias a que MéxicoFIRST es apoyado por Secretaría de Economía, quienes deseen certificarse por este medio podrán ob-tener hasta un 80% de descuento.

Mayor información en www.certificatemexico.com

MAY-JUL 2009www.sg.com.mx

// EVENTOS

05

Global Trends in Software TestingEl pasado mes de marzo la empresa e-Quallity invitó a Méxi-co al reconocido gurú del testing Martin Pol, fundador de Pol-tec (empresa holandesa de consultoría y certificación) y co-autor del modelo europeo Test Process Improvement (TPI). Martin Pol impartió la conferencia “Global Trends in Software Testing” en Guadalajara, Monterrey y Ciudad de México, en-focando su plática en la importancia que tiene el uso de las pruebas de software para incrementar las capacidades de evitar los riesgos empresariales.

Information Management & BI 2.0 Conference 2009

Con una visión de BI mucho más predictiva, que no se limita en analizar el pasado, sino que ayuda a entender el futuro, el pasado mes de febrero IDC presentó exitosamente el In-formation Management & BI 2.0 Conference, foro diseñado considerando las principales industrias de crecimiento para el 2009 en el mercado de TI: Gobierno, Servicios y Manufactura, enfocado en aterrizar los beneficios del Manejo Estratégico de la Información y el BI para dichos sectores.

20 y 21 de mayo 20095a. Conferencia Anual de TI Service ManagementPink ElephantHotel Maria Isabel Sheraton, Ciudad de MéxicoInfo: www.pinkelephant.comContacto: [email protected]

10 a 12 de junio 2009XVIII Reunión Nacional de Directores de Escuelas y Facultades de Informática y ComputaciónANIEITepic, NayaritInfo: www.aniei.org.mx

14 al 16 de junio 2009GITMA - ITESM Congreso Mundial de TITecnológico de Monterrey, Campus Santa Fe.Info: www.gitma-la.orgContacto: [email protected]

22 y 23 de junio 20095a. Cumbre de Gobierno y TecnologíaIDC MéxicoHacienda de los Morales, Ciudad de MéxicoInfo: www.idclatin.com/eventsContacto: [email protected]

14 y 15 de Julio 2009X Encuentro Iberoamericano de Ciudades DigitalesGobierno del Estado de VeracruzWorld Trade Center, Veracruz.Info: www.ciudades.gob.mx

15 y 16 de julio 2009Agile Project Management: Innovation in ActionCutter ConsortiumHotel Marriott, Ciudad de MéxicoInfo: www.cutter.com.mxContacto: [email protected]

Eventos de software libreEl mes de abril fue bastante agitado para los entusiastas del software libre, ya que en menos de dos semanas se realizaron cuatro eventos importantes.

Empezamos con el 4to Congreso de Software Libre or-ganizado por los estudiantes del CCH Naucalpan el 13 y 14 de abril.

Seguimos con la edición 2009 del Consol, que este año se llevó a cabo en la UAM Azcapotzalco del 14 al 17 de abril, con la participación de conferencistas como Fer-nando Romo, Sandino Araico y Palmira Granados.

Posteriormente, del 21 al 23 tuvo lugar el 2do Coloquio Universitario de Software Libre PUMASOL organizado por el Laboratorio de Investigación en Software Libre (LIDSoL) en coordinación con la Facultad de Ingeniería de la UNAM.

Por último, el 25 de abril fue el día del Festival Latino-americano de Software Libre (FLISOL) 2009, el cual con-juntó sedes en más de 200 ciudades en 18 países.

MAY-JUL 2009 www.sg.com.mx1606

// INDUSTRIA

Software en Nuevo León

Nuevo León es un estado de gran importancia en términos de la in-dustria de software en nuestra región. Aquí residen algunas de las empresas de servicios de TI más grandes, y se ha convertido en una sede preferida para empresas que ofrecen servicios tipo Nearshore para el mercado norteamericano. En los últimos años, incluso gran-des empresas de la India como Infosys, Sasken y Wipro han estable-cido centros de operación en esta entidad.

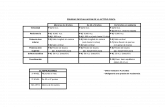

Algunos números para comenzarLa industria de software en Nuevo León está compuesta por más de 300 empresas que emplean más de 7 mil personas y generan ingre-sos por más de 300 millones de dólares anuales.

La distribución de empresas en base a su cantidad de empleados es la siguiente:• Micro (1 a 10) 43%• Pequeña (11 a 50) 31%• Mediana (50 a 100) 17%• Grande (más de 100) 9%

En Nuevo León existen 24 empresas certificadas en Moprosoft y 12 en CMMI, es la segunda entidad con más empresas con certificacio-nes de calidad después del Distrito Federal.

CSOFTMTYEl Consejo de Software de Nuevo León (CSOFTMTY) es el organismo que coordina lo que se denomina la triple hélice: academia, empre-sas y gobierno. Esta asociación civil es la responsable de desarrollar y asegurar el cumplimiento de las estrategias para el fortalecimiento de la industria de software en esta región.

Para ello, CSOFTMTY se enfoca en siete líneas de acción:1. Desarrollo de mercado2. Desarrollo de profesionales de software3. Desarrollo de empresas y empresarios4. Desarrollo de infraestructura5. Sustentabilidad y alto valor agregado6. Accesibilidad a programas y fondos económicos

Existen 22 miembros de los cuales 12 son empresas, 3 organismos empresariales (AETI, CANIETI y ORIGO), 5 universidades (ITESM, TEC Milenio, UANL, UDEM y UR), un representante del Gobierno de Nuevo León y uno del Instituto de Innovación y Transferencia de Tecnología (I2T2).

Una característica fundamental de CSOFTMTY es que no es un or-ganismo gubernamental, sino que es un organismo independien-te que vincula a la triple hélice: Empresas, Academia y Gobierno para lograr un propósito común.

Desarrollo de Capital HumanoEn términos de capital humano, Nuevo León enfrenta una proble-mática similar a la de otros estados: la matrícula de estudiantes en carreras relacionadas con TI ha disminuido en los últimos años, y por otro lado los recién egresados no poseen las habilidades que demandan las empresas. Sin embargo, en el caso de Nuevo León esta situación se agudiza debido a que en los últimos años existió un alto crecimiento de la industria en la región y se han estable-cido aquí empresas internacionales, especialmente de India, que demandan una gran cantidad de personal calificado en TI. Ante esta situación, el desarrollo de capital humano tiene un lugar pre-ponderante en la agenda de CSOFTMTY y para ello ha establecido diversas iniciativas.

Guillermo Safa, director del CSOFTMTY, nos comenta sobre el factor de éxito más importante en esta iniciativa es el contar con el Capital Humano en suficiencia y con las capacidades requeri-das por los mercados internacionales.

Es por esto que esta es la línea estratégica de mayor prioridad dentro del plan de trabajo de CSOFTMTY; dentro de la cual hay dos iniciativas concretas en las que se está trabajando: • Una campaña de promoción entre los jóvenes para que estudien carreras relacionadas con las TIC’s• La creación del Instituto de Desarrollo de Talento de TI, único en su tipo en México

Instituto de Desarrollo de Talento de TIEl Instituto de Desarrollo de Talento de TI (IDETI) tiene como finali-dad el incrementar, en el corto plazo, el capital intelectual disponible para la industria de software con certificaciones internacionales. En veintidós semanas se prepara para el trabajo a recién egresados de las carreras de TI, actualiza a profesionistas y reconvierte a profe-sionistas de otras ingenierías para integrarlos a la fuerza laboral de la industria. Los cursos son tomados en una de las 5 universidades vinculadas: ITESM, Tec Milenio, Universidad Regiomontana, Univer-sidad Autónoma de Nuevo León y Universidad de Monterrey.

Los programas de estudio de este Instituto se refieren específicamente a la certificación en:• Conceptos de hardware y software de sistemas• Fundamentos de programación• Bases de datos• Metodologías de desarrollo de software• Análisis de algoritmos• Conceptos de desarrollo orientado a objetos• Diseño de interfaces• Tecnologías Web• Conceptos Cliente – Servidor

MAY-JUL 2009www.sg.com.mx

Solo para TI“Solo para TI” es una campaña para fomentar que los jóvenes próxi-mos a entrar a la universidad elijan estudiar carreras relacionadas a las tecnologías de información. Asimismo, se ha iniciado una es-trategia pre-universitaria en la que a través de centros de compu-tación aplicada y la capacitación de maestros de escuelas públicas de primaria y secundaria se fomente el conocimiento y gusto por las tecnologías de información y comunicaciones.

Vinculación con universidadesPor su parte, las empresas y universidades también llevan a cabo actividades de vinculación que resulten en disponibilidad de más ca-pital humano y con mayor especialización y experiencia:• Las universidades ofrecen espacio de ubicación a nuevas empre-sas que llegan a la entidad, lo que les permite acceso directo a nuevo talento así como a infraestructura temporal para iniciar sus operaciones (softlanding).• Las empresas realizan convenios con las universidades para la ab-sorción directa de talento, así como para la realización de proyectos con clientes actuales en sus instalaciones. Esta práctica permite a la empresa reducir sus costos mientras prepara talento con conoci-mientos de los actuales requerimientos de los usuarios de TIC.• Las empresas de la India, que en años recientes han realizado inversiones en la entidad, tienen convenios con las principales uni-versidades del estado para que estudiantes y profesores visiten sus centros de capacitación en la India. Durante la visita se identifican las brechas existentes entre las necesidades actuales de la industria y el sistema educativo de la entidad y se recibe un entrenamiento en las capacidades que se necesitan desarrollar dentro del sistema educativo estatal actual.

Desarrollo de mercadoEl mercado local de software y servicios TI en Nuevo León se en-cuentra bastante consolidado, siendo el segundo mercado local en importancia en el país. Las grandes empresas usuarias enfrentan una competencia globalizada y están conscientes de que para des-tacar en este ámbito es crucial tener un buen aprovechamiento de las TICs. Por otro lado, se están presentando nuevas oportunidades de penetración en el mercado gracias a una dinámica de desarrollo económico que ve al software como coadyuvante en la innovación de productos y procesos. Para catalizar esto se realizan diferentes acciones tales como:• Planes para fomentar la transferencia de tecnología (productos y servicios de las empresas de TI y de los centros de investigación y desarrollo) hacia los sectores más estratégicos de la entidad y hacia los nuevos sectores que están siendo impulsados.• Promoción entre las empresas más grandes de la entidad para la contratación de servicios y productos de TI de empresas locales.• Se está persiguiendo que el gobierno local sea un potencial consu-

midor de los productos y servicios de las empresas locales. Se pro-mueve la participación de pequeñas y medianas empresas locales de TI en proyectos, a través de convenios de integración con grandes proveedores y a través de la incorporación de la evaluación de pro-veedores locales en la ley de adquisiciones.

InnovaciónDentro del Consejo, entró en operación un nuevo comité de innovación en el cual se busca desarrollar la alta especialización del sector basa-do en innovación y las mejores prácticas mundiales en este concepto. Este nuevo comité llevará la tarea de homologar en la triple hélice el concepto de innovación en TI ya que actualmente se tienen diferen-tes definiciones del concepto. De igual manera, se buscará desarro-llar innovación en los productos y servicios para obtener márgenes más grandes en la industria.

InfraestructuraEn Nuevo León existe el Parque de Investigación e Innovación Tec-nológica (PIIT) el cual tiene una superficie total de 70 hectáreas disponibles para centros de investigación y desarrollo de empresas en las áreas de salud, mecatrónica, tecnología de información, bio-tecnología y nanotecnología.

Dentro del PITT esta por inaugurarse el Monterrey IT Cluster, un con-junto de 42 empresas que compartirán un edificio e infraestructura desde el inicio de sus operaciones, para posteriormente trabajar en conjunto e incursionar a mercados internacionales.

Más información en: [www.csoftmty.org] [www.ti.org.mx] [www.piit.com.mx]

1707

MIT Cluster en el PIIT

MAY-JUL 2009 www.sg.com.mx08

Picando piedra: Primera ParteRecoRdando a las peRsonas que apoRtaRon su gRanito de aRena paRa elevaR la calidad del softwaRe mexicano

/*TEJIENDO NUESTRA RED*/// COLUMNA

Escribir la columna número 25 para Software Gurú me puso nostálgica. A lo largo de casi veintiséis años de trabajo en México he conocido mucha gente, que desde sus espacios, han impulsado la adopción de buenas prácticas en la industria de software. Para hacer un pequeño reconocimiento de su labor, decidí hacer un recuento de sus aportaciones para que las nue-vas generaciones no piensen que las cosas salen de la nada y para que se animen a participar.

• 1983, Lupita Ibargüengoitia consigue la primera edición del libro de Ingeniería de Software de Pressmann y aunque en la especialización en Computación de la carrera de Matemáticas de la UNAM no existía materia bajo este nombre, decide impar-tirla. Tal vez este fue el primer curso de Ingeniería de Software en México.

• 1983, su servidora llega a México y ofrece el curso sobre Simu-la 67 en la Maestría en Ciencias de la Computación de la UNAM. Tal vez fue el primer curso de un lenguaje Orientado a Objetos.

• 1992, Carlos Vizcaíno inicia la publicación de la revista Solu-ciones Avanzadas, una revista semejante a lo que hoy es SG. Esta revista fue un excelente medio de transferencia de conoci-miento y comunicación entre la academia y la industria. Aquí se publicaron los primeros artículos sobre diversos paradigmas de lenguajes de programación, OO, UML, modelos, así como están-dares de procesos y muchos temas más. Desgraciadamente la revista dejo de existir en 1999.

• 1992, su servidora empezó a dar las primeras conferencias so-bre ¿Por qué está de moda OO? en los foros de Instituto Mexica-no de Petróleo, COMDEX y Día Borland, inventando el ejemplo de ¿cómo se hacen chilaquiles al estilo OO?, para poder llamar la atención del público.

• 1994, Arnoldo Díaz de la empresa certum comienza a partici-par en un proyecto de la ISO llamado SPICE (Software Process Improvement and Capability dEtermination), hoy mejor conocido como el estándar ISO/IEC 15504 Software Process Assessment. Llegó a fungir como Project Editor y Miembro del Consejo de Ad-ministración del proyecto SPICE. La herramienta de Evaluación de Procesos de Software desarrollada por certum fue denomina-

da Official SPICE Assessment Instrument. Según mi conocimien-to fue el primer directivo de la industria y tal vez último hasta la fecha, quien se involucró personalmente en desarrollar un es-tándar internacional para poder tener una ventaja competitiva en el mercado nacional.

• 1997, Gloria Quintanilla y Hanna Oktaba convocan a la primera reunión del Circulo de Calidad de Software en las instalaciones de IBM-Technosys. La primer conferencia que se ofrece es de Francisco López Lira sobre SW-CMM. Asistieron 22 personas, lo que nos obligó a continuar con reuniones mensuales, una de ellas en enero de 1998 en Guadalajara con apoyo de la empresa mexicana Compac. Por la creciente asistencia las reuniones ha-bían cambiado de sede a un espacio de INEGI (apoyo de Pablo Noriega y Natalia Volkov) y luego a Infonavit (apoyo de Víctor Baez). Los conferencistas fueron nuestros colegas académicos o de la industria y los temas abarcados fueron SW-CMM, PMBoK, ISO/IEC 15504 (SPICE), Function Points, PSP y muchos más. En-tre 1998 y 1999 organizamos cuatro seminarios de calidad de software con el apoyo de AMITI y Soluciones Avanzadas, en los cuales contamos con la presencia de Watts Humphrey hablando de TSP, Suz García y Mark Paulk hablando de SW-CMM y William Hetzel de proceso de pruebas.

• 1997-1998, empezamos a tener las primeras empresas de la industria de software evaluadas en ISO 9000:1995, tales como Gedas, Certum, EDS, e IBM-Technosys y la primera en SW-CMM nivel 2 fue IBM-Technosys.

• 1998, Luis Castro profesor de la UAM-I crea el primer Labora-torio de Ingeniería de Software en la academia y se convierte pronto en uno de los primeros instructores PSP.

• 1998, Lupita Ibargüengoitia y Hanna Oktaba abren en la Maestría en Ciencia e Ingeniería de Software de la UNAM un área de especialización en ingeniería de software con cursos de Tecnología Orientada a Objetos y modelos de procesos de Ingeniería de Software (12207, 15504, SW-CMM, PSP, TSP). En los últimos años estos cursos fueron enriquecidos con la participación de las instructoras: Ana Briseño (consultora inde-pendiente), Cecilia Pérez (IBM de México) y Elsa Ramírez (Praxis). Hasta la fecha Lupita y yo hemos dirigido 48 tesis de maestría relacionadas con diversos temas de calidad en procesos de software.

La Dra. Hanna Oktaba es profesora de la UNAM a nivel licenciatura y posgrado. Sus áreas de interés son Ingeniería de Software, Tecnología Orientada a Objetos, Modelos de Procesos de Software y Mejora de Procesos. Actualmente es miembro de International Process Research Group (IPRC). También es Directora Técnica del proyecto COMPETISOFT.

MAY-JUL 2009www.sg.com.mx

de software basados en las tesis de maestría. En los últimos años de la actividad de la AMCIS se crearon sus capítulos en Jalisco (Luis Vinicio León), Nuevo León (Héctor González), Veracruz (Agustín La-gunes) y Chihuahua (Joaquín Gálvez).

• 1999, Carlos Montes de Oca llega al CIMAT, Guanajuato, y empieza a formar el grupo de investigación en Ingeniería de Software y Calidad más dinámico del país.

Esta es la primera parte de mis recuerdos, que abarca principalmente los años noventas. Quiero subrayar que este recuento está basado solamen-te en mis recuerdos personales usando mi memoria de viejita. Invito a todos mis colegas y a los lectores de SG para que complementen la infor-mación y que corrijan los datos erróneos.

» Por Hanna Oktaba

09

• 1999, Gloria Quintanilla, Francisco López Lira, Lupita Ibargüengoitia y su servidora fundan la Asociación Mexicana para la Calidad en In-geniería de Software (AMCIS). A mitad de 1999 el Círculo de Calidad de Software, tuvo tantos adeptos que se decidió formalizar su exis-tencia a través de la AMCIS. Durante sus 8 años de existencia varias personas dedicaron su tiempo para que la asociación funcionara. Me llegan a la mente los nombres de: Ana Vázquez, Jorge Palacios, Agustín Gutiérrez, Ana Briseño, Luis Castro, Mariana Pérez-Vargas, José Manuel Milanés, Carlos Pérez, Maria Julia Orozco, Claudia Al-quicira, Angélica Sú, Héctor González y muchos más cuyos nombres se me escapan en este momento. Continuamos con las reuniones mensuales gracias al Grupo SETI, que nos ofreció el espacio, orga-nizamos cinco seminarios de calidad de software con invitados ex-tranjeros y nacionales. Armamos el primer Diplomado de Calidad de Software que entre 2002 y 2006 fue ofrecido en el Distrito Federal y en el interior del país. También, editamos cuadernos de calidad

MAY-JUL 2009 www.sg.com.mx10

/*MEJORA CONTINUA*/// COLUMNA

ve, cero defectos implica ser perfecto. Así en las culturas occidentales no podemos hablar de cero defectos sino de mejora continua. No podemos aspirar a ser perfectos, pero sí a mejorar continuamente.

2) Si el occidental valora que las cosas fun-cionen entonces existe un gran valor en las áreas de soporte y de servicio. Si se descom-pone mi coche lo que quiero es que lo repa-ren inmediatamente aunque no tenga ningún plan de salir en él. Si mi programa de soft-ware falla no hay nada más importante que el hecho de que funcione nuevamente. Estas son áreas que normalmente relegamos pero deberían ser parte de los procesos básicos de nuestra compañía.

3) Aunque para el occidental la calidad se ve en el hecho de que algo funcione correc-tamente, esto lo podríamos ver como un algo que simplifica nuestro trabajo pero es un arma de dos filos, ya que esto se vuelve una característica dada en el producto. Si de veras quiero maravillar a mi cliente requiero que mi diseño me haga impresionante.

4) La mejora continua requiere de un trabajo arduo que toma tiempo, constancia y discipli-na, pero estas características son tan raras en una organización que podemos contar con el hecho que de ese trabajo nos diferencia de nuestros competidores, muchos hablan de calidad pero no todos tienen el temperamen-to para lograrlo.

Es interesante entender estos rasgos culturales para así vender mejor nuestras ideas, y hacer de nuestras organizaciones la fuerza competidora que logrará en forma consistente los resultados que nuestros clientes están buscando.

Tomemos el reto, es hora de crear nuestra propia cultura de calidad.

» Por Luis Cuellar

La Cultura de Calidadtomemos el Reto

Luis R. Cuellar es director de calidad a nivel mundial de Softtek Information Services. Luis es reconocido por la American Society for Quality (ASQ) como Certified Quality Manager, Certified Software Engineer, y Six Sigma Black Belt. En los últimos cinco años ha estado a cargo de la definición e implantación de la estrategia para CMMI5 y Six Sigma a través de las diferentes áreas del centro de desarrollo de Softtek.

La semana pasada terminé un libro llama-do The Culture Code (El Código de la Cultu-ra). El libro está enfocado principalmente en el área de mercadeo y desarrollo de nuevos productos. Expone el hecho de que para ha-cer un buen trabajo no es suficiente hacer entrevistas enfocadas para averiguar los gustos específicos de un grupo de personas, pues el entrevistado al tratar de explicar se ve rodeado de prejuicios e ideas sociales que se interponen en su definición. Si por ejemplo preguntamos ¿qué quieres ver en un automóvil? las respuestas se enfocan en su velocidad, bajo consumo de gasolina, poco mantenimiento y demás elementos que defi-nen a los automóviles actuales. Pero, si pre-guntamos más a nivel subconsciente a través de dinámicas de roles, manejo de recuerdos y demás, las respuestas son totalmente dife-rentes. Un ejemplo de dinámica sería el aden-trarse a preguntar tus primeros recuerdos de un automóvil y las emociones que estos re-cuerdos te traen, al hacer esto se descubre que en realidad lo que buscamos de un auto es la libertad e identidad que nos proporcio-na, cómo el automóvil nos hace únicos.

El libro da un compendio de lo que el autor ha encontrado en sus estudios y resume esta in-formación tratando de encontrar una palabra que define en la mente de los americanos si-tuaciones como: sexo, trabajo, salud, etc. Lo que se me hizo realmente fascinante es que entre sus estudios se encuentran las defini-ciones de términos como “calidad” y “cero defectos” y cómo se compara con la calidad en la cultura japonesa. De acuerdo al autor los norteamericanos ligan la palabra calidad con el hecho de que un producto haga lo que fue diseñado para hacer sin problemas. En otras palabras, en norteamérica calidad significa: “¡FUNCIONA!”. Esto contrasta con la cultura japonesa en donde la calidad es mucho más. En esta cultura la calidad está ligada con el he-cho de que el producto funcione, pero adicio-nalmente tiene que ver con la pureza y eficien-

cia del diseño y cómo lograr, en grupo, cero defectos. Yo creo que esto se ve claramente ejemplificado con los problemas que el día de hoy enfrenta la industria automotriz america-na. En Detroit la preocupación siempre ha sido entregar automóviles que funcionen, desde los tiempos de Henry Ford y su famosa frase “Te lo podemos dar de cualquier color siem-pre y cuando sea negro”. El enfoque siempre ha sido una máquina que te lleve de un lado a otro. Al mismo tiempo la industria automo-triz japonesa está en pleno auge liderado por Toyota. Los japoneses no sólo se preocupan porque el automovil funcione, sino cómo per-feccionar todo proceso que involucre al auto. Hace poco escuché una historia de como la persona encargada de diseñar la Sienna se pasó viajando por minivan en Estados Unidos durante un año para identificar qué debería y qué no debería contener la camioneta. Es interesante como nunca se me hubiera ocurri-do decir que lo que quería de mi auto es una buena área de mantenimiento y servicio que me entregue el coche cuando se me dijo y me costara la tercera parte. Nunca pensé que fue-ra posible. Ahora después de dos años con mi Toyota es lo mínimo que espero.

¿Y esto a mí qué?Bueno, ¿por qué es importante hablar de esto ahora? Yo creo que este pasaje tiene muchos puntos de valor para el área de cambio de una organización. Si suponemos que por ser la nuestra una cultura occidental hay alguna posibilidad de parentesco en el ámbito de ca-lidad con la cultura japonesa, analicemos los siguientes puntos:

1) El trabajo de un área de cambio es 30% crear y 70% vender. Por lo que para un vende-dor esta es información muy importante. Un punto que no mencioné es que el americano valora mucho el movimiento, por lo que no puede asimilar la idea de la perfección, sólo Dios es perfecto. Ser perfecto implica ya no moverse, y solamente lo muerto no se mue-

MAY-JUL 2009 www.sg.com.mx

IBM WebSphere CloudBurst ApplianceHabilitación de nubes privadas

IBM dio a conocer su estrategia de cómputo en la nube, haciendo ver que su estrategia no está orientada a la nube pública (como Amazon o Google), sino a nubes privadas para corporativos. Las nu-bes privadas consisten en proveer recursos de cómputo y datos vir-tualizados para ambientes corporativos controlados por el personal de TI de la organización.

Como parte de esta estrategia, IBM lanzó WebSphere CloudBurst Appliance, un hardware appliance que integra imágenes virtualiza-das de aplicaciones sobre servidores xSeries. Cuando los clientes están listos, las aplicaciones se habilitan en las nubes privadas para que puedan atender peticiones bajo demanda.

Con CloudBurst, los equipos de desarrollo pueden tener a su entera disposición los recursos de cómputo del appliance durante el ciclo de desarrollo, y una vez que todo esté listo y probado se configura para que los recursos formen parte de la nube privada, administra-dos por el departamento de TI de la organización.

CloudBurst se integra con el nuevo Rational Automation Framework for WebSphere para automáticamente optimizar la configuración y habilitación de aplicaciones. La administración de recursos también se facilita significativamente por medio de la integración con el Tivo-li Service Automation Manager.

Dryad y DryadLINQProcesamiento de datos en cluster

Dryad y DryadLINQ son dos proyectos de Microsoft Re-search orientados a facilitar el procesamiento de gran-des cantidades de datos en clusters de alto desempeño (high performance clusters).

El primer elemento, Dryad, es una infraestructura que habilita programas secuenciales y los optimiza para que puedan ser ejecutados de forma paralela en clus-ters distribuidos.

Por su parte, DryadLINQ es un compilador que traduce programas LINQ a instrucciones de cómputo distribuido que se pueden ejecutar en un cluster. Para lograr esto, DryadLINQ particiona de forma distribuida los objetos de datos de LINQ y convierte las sentencias de LINQ y métodos de C# en tareas distribuidas de Dryad.

DryadLINQ soporta todas las librerías de .Net y se inte-gra con Visual Studio para facilitar el desarrollo.

Más información en: research.microsoft.com/en-us/projects/dryadresearch.microsoft.com/en-us/projects/dryadlinq

MoblinLinux atómico

Moblin es una edición de Linux optimizada para eje-cutarse en sistemas basados en la tecnología Atom de Intel. La visión es proveer una plataforma comple-ta para aplicaciones enriquecidas que aprovechen las capacidades de dispositivos tales como NetBooks, MIDs (mobile internet devices), sistemas de informa-ción/entretenimiento para vehículos, y otros disposi-tivos embebidos.

El proyecto se encuentra en etapas tempranas y to-davía no está listo para producción, pero puede ser una opción atractiva para quienes estén conside-rando iniciarse en el desarrollo de aplicaciones para este segmento.

Más información en moblin.org

12

/* LO QUE VIENE*/// PRODUCTOS

RubyMinePor fin un IDE para Ruby

Como evidencia de la popularidad que está cobrando el len-guaje Ruby, la empresa JetBrains lanzó RubyMine 1.0, un am-biente de desarrollo para Ruby y Rails.

RubyMine mantiene el alto estándar de calidad de los productos de Jetbrains. Entre sus características destacan:• Editor inteligente que analiza el código e infiere los tipo de datos conforme escribes. • Capacidades integradas para aplicar el framework Rails. • Pruebas unitarias con TestUnit y Rspec.

Más información en: www.jetbrains.com/ruby

MAY-JUL 2009 www.sg.com.mx14

Web Testing Utilizando Visual Studio Team Edition for Software Testers cReando web tests de maneRa Rápida, sencilla y eficientePor Benjamín Ruvalcaba

/*HERRAMIENTAS*/// PRODUCTOS

Con la llegada de Visual Studio 2005 Team System, Microsoft intentó crear un ambiente integrado de desarrollo de software en el cual todas las actividades del ciclo pudieran tomar lugar. Para satisfacer las necesi-dades de pruebas del desarrollo de software, Microsoft creó Visual Stu-dio 2005 Team Edition for Software Testers. Desde aquel lanzamiento, Microsoft ha puesto en el mercado la versión 2008 de su Team System suite. Además, existen planes para lanzar la versión 2010 en un futuro cercano. Esta versión tendrá un énfasis en las actividades e integración de testing. A diferencia de la mayoría de los productos comerciales, el objetivo de Test Edition no es la captura de las actividades del teclado o mouse. La herramienta se enfoca en la captura de las interacciones http y https entre el cliente y los servidores web. Este enfoque alivia en algo la frustración que viene con el uso de las herramientas basadas en la grabación de eventos en la interface gráfica del usuario.

Este artículo proporciona información acerca de conceptos básicos de la herramienta. El objetivo es dar a los lectores una idea de cómo implemen-tar la herramienta en poco tiempo y sin los dolores de cabeza comúnmen-te asociados con el comienzo de la automatización de pruebas.

Creando web testsYa que los web test solamente están disponibles en Proyectos Test, el primer paso hacia la creación de un web test es la creación del proyecto. Nótese que el tipo de proyecto Test solo existe como com-ponente del Test Edition de Team System. Puedes agregar el proyec-to a una solución existente o crear una nueva. Selecciona New > Project desde el menú File para aparecer el dialogo de New Project. Selecciona el tipo de proyecto Test, su nombre, .Net Framework que deseas, y la solución que de deseas utilizar.

Una vez creado el proyecto, debes agregar el web test. Para agregar el web test puedes oprimir el ícono de New Test o seleccionar New Test desde el menú de Test. Los diferentes tipos de prueba aparecen en el dialogo de Add New Test. Los tipos de pruebas que existen incluye: Ge-neric, Web, Load, Manual, Ordered, y Unit. Selecciona Web Test y captu-ra el nombre para la prueba y el proyecto que vas a comenzar. Una vez que hayas presionado OK aparecerá una sesión en blanco de Internet Explorer lista para iniciar la grabación de actividad del navegador. Los controles de grabación te permiten comenzar, detener, parar, comentar o borrar la grabación. Estoy utilizando www.sg.com.mx como dirección para este ejemplo. Nótese que en cuanto comienza la actividad http se empieza a grabar. Esto se puede ver en el árbol jerárquico de las requi-siciones http que aparece bajo los controles de grabación.

Benjamín Ruvalcaba Alonso tiene más de 18 años de experiencia en proyectos de informática. Ha trabajado en Microsoft, GE y otras empresas públicas y privadas. Ha dedicado los últimos seis años al testing de diversas aplicaciones web.

Captura1. Creación de nuevo proyecto

Captura 2. Despliegue de la prueba y el árbol

Mientras estoy grabando actividad, entro a mi cuenta en el sitio utilizan-do el link ‘Actualizar Datos’ y reviso información personal. Para finalizar la grabación oprimo el botón Stop en los controles correspondientes. Al hacer esto, la herramienta comienza la detección automática de pará-metros dinámicos. Los parámetros dinámicos son aquellos que se utili-zan de manera subsecuente al primer uso en la grabación. Una vez iden-tificados los parámetros dinámicos, el sistema ofrece la oportunidad de promoverlos para que sean utilizados en corridas posteriores.

MAY-JUL 2009www.sg.com.mx 15

Captura 3. Prueba con validaciones

Al completar el paso anterior, el sistema despliega la prueba y el árbol de llamadas http(s). Este es el resultado de la grabación con los parámetros utilizados para mi acceso al sitio. Advertencia: La herramienta no utiliza encriptado. Por lo tanto, todo el tráfico es visible. Yo oculte mi clave para este ejercicio.

Como buena práctica, corre el web test para asegurarte que fun-ciona adecuadamente. Al terminar la prueba, el sistema te desple-gará un panel de resultados. Para verificar las razones de fallas puedes oprimir el link de ‘Test run completed’. Esto mostrará una lista detallada de la corrida de la prueba. Procedamos a agregar validaciones propias.

Agregando validaciones propiasLa herramienta agrega muchas validaciones propias. Asegura que la página se muestre, verifica que las redirecciones http que ocu-rrieron durante la grabación sean válidas al momento de ejecu-ción, etc. Sin embargo, el usuario aún querrá agregar validaciones propias. Para esto es necesario identificar la llamada http que se desea validar. Para agregar validaciones a la página de Actualizar Datos solo hay que dar click derecho en la validación y seleccionar ‘Add Validation Rule’ del menú. Un caja de diálogo aparece con las validaciones suministradas por la herramienta. Los tipos de valida-ciones posibles incluyen: Form Field, Find Text, Maximum Request Time, Required Attribute Value, Required Tag, y Response URL.

La validación de Form Field verifica que un campo en la página ten-ga el valor esperado. Un buen uso par esta validación se presenta en los campos defaults. La validación de Find Text verifica la exis-tencia o inexistencia de determinado texto en la página. Yo lo utili-zo buscando con la opción “fallar si encuentra el texto”, para bus-car mensajes de texto comunes en errores de programación. Hay que recordar que la búsqueda solamente se hace a nivel HTML, así que puede haber texto embebido en la página sin ser visible.

La última validación nos permite fijar estándares de desempeño. Puedes definir cuánto es el tiempo máximo permisible para que cargue una página de tu aplicación. ‘Level’ es una propiedad co-mún entre todas las reglas de validación. Cualquier web test puede utilizarse durante pruebas de carga (load testing). Esta propiedad determina cuando se incluirán en un escenario de pruebas de car-ga. Como un bono, la herramienta de pruebas de carga (Load Tes-ting) es incluida como parte del paquete de Test Edition.

Ejecutando la prueba con validaciones Para ejecutar la prueba con validaciones, selecciona el botón de ejecutar para que la prueba corra. El sistema proporciona informa-ción para saber si la prueba pasa o falla. Para obtener un reporte detallado de los resultados hay que seleccionar el link de ‘Test run pass / fail’. Al hacer esto, el sistema proporciona el detalle de todas las llamadas http con información acerca del estado del navegador, datos de la requisición, respuesta obtenida, contexto y detalles. Los detalles de nuestras validaciones se encuentran en la tableta de detalles. En la muestra, una de las validaciones falló. El sistema suministra el detalle de la falla. La presencia de una sola falla de validación marcará toda la prueba como fallida.

Es posible tener mayor control sobre la creación de Web Tests mediante la utilización de Coded Web Tests. Estos son Web Tests que se crean y existen en código. Para crearlos se puede utilizar del botón designado o comenzando en blanco, haciendo uso de las programación utilizando las librerías de WebTesting que vienen con el paquete. También es posible programar extensio-nes al producto, tales como reglas propias para la extracción y validación del sistema.

ConclusiónLa creación de Web Tests utilizando Microsoft Test Edition es rápida, sencilla y eficiente. Debido a su dependencia en lla-madas http e información HTML, es posible obtener resulta-dos consistentes al ejecutar las pruebas minimizando así el tiempo dedicado a la modificación de pruebas existentes.

La herramienta también proporciona la capacidad de ejecutar pruebas de carga y performance sin ningún costo adicional. Además de tener tremenda sinergia al utilizarse con Team Foun-dation Server. Al utilizarse apropiadamente, los beneficios que se pueden obtener con esta herramienta son muchos.

Espero la oportunidad de escribir más acerca de esto en artículos futuros.

Si tienes alguna duda o sugerencia puedes comunicarte conmigo en el correo [email protected]

Con la integración de Team Foundation Server, podrías tomar los resultados y publicarlos para tener control de todas las pruebas ejecutadas. También es posible la creación de bugs mediante la utilización de estos resultados.

MAY-JUL 2009 www.sg.com.mx16

Aplicaciones en la Nube con AzurecompRendiendo como funciona este nuevo esquemaPor Miguel Angel Morán y Misael Monterroca

/*TUTORIAL*/// PRODUCTOS

El cómputo en la nube o cloud computing es una de las tendencias que mayor impacto están teniendo en nuestra industria actualmente y hacia el futuro próximo. A pesar de que en el número 22 de SG ya se habló bastante sobre este tema, consideramos pertinente re-pasar algunos puntos, y aprovechar para familiarizarnos con Azure, que es la propuesta de Microsoft para una plataforma y sistema ope-rativo para la nube.

Entendiendo la nubeDesde hace mucho tiempo, en la iconografía utilizada dentro de los diagramas de topologías de redes, los trayectos donde viajan datos a través de internet se representan como nubes para enmascarar la complejidad del viaje a través de la red de redes. Derivado de esto, la nube es una alegoría de internet y representa precisamente toda la infraestructura que requiere internet para operar.

Cuando abstraemos este concepto e imaginamos la nube como una unidad y no como cada una de sus piezas (protocolos, conexiones, software, servidores, switches y un largo etcétera) tenemos el concep-to al que actualmente se refiere la industria: Ver a internet como un todo, donde dejan de ser importantes los detalles exactos para que se logre echar a andar un aplicativo en internet, y conceptualizar a la nube como una constante, como una infraestructura de facto con la que podemos contar para utilizarla como plataforma de cómputo.

Por lo tanto, podemos definir el cómputo en la nube como la utili-zación de internet (como un todo y no por piezas) para almacenar, ofrecer y consumir servicios tanto de hardware como de software a quien lo requiera.

El cómputo en la nube cuenta con varias características comúnmen-te aceptadas:• Tanto el hardware como el software son servicios. En los esque-mas tradicionales es necesario hacer grandes inversiones para tener un servidor en internet. En el esquema basado en la nube se renta el hardware y el software donde se aloja nuestra aplicación, lo que evita desembolsos iniciales.

• Infraestructura dinámica y autoadministrable. Del mismo modo, en una plataforma no orientada a la nube, es necesario realizar la ad-ministración de toda la infraestructura, desde el hardware, sistema operativo, base de datos. Si se desea escalar la aplicación es nece-sario hacer nuevas inversiones para ampliar o actualizar el hardware para que soporte nuevas cargas además de tener que monitorear el funcionamiento del hardware y de la red, actividades que usualmen-te requieren de personal especializado, lo cual representa un costo. En contraste, en la nube todo esto se ofrece como servicio y el pro-veedor se encarga de hacer todo esto de una manera automatizada, utilizando generalmente tecnologías de virtualización.

• Uso de estándares. Los estándares son importantes para lograr un ecosistema eficiente en la nube y una interoperabilidad maximizada. XML, SOAP y últimamente REST son hasta el momento los estánda-res preferidos.

• Esquemas de pago basados en el consumo. Generalmente el soft-ware se adquiere mediante licenciamiento al hacer un pago, usemos o no usemos el software, el desembolso de dinero debe hacerse de cualquier manera. En el modelo de precios de la nube se propone que los pagos deben estar basados en datos del consumo real, por ejemplo: porcentaje de utilización de los procesadores, accesos a la base de datos, cantidad de hits por tiempo etc.

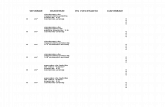

Como podemos apreciar, el objetivo del cómputo en la nube es dis-minuir la complejidad y los costos asociados al generar aplicaciones en Internet. Este concepto, a su vez hace uso de diferentes términos ya utilizados en la industria. (Figura 1)

Clientes. Son los dispositivos que consumen los servicios de la nube. Generalmente acceden a ellos mediante smart clients o pá-ginas web.

Software como servicio. Se refiere a las aplicaciones de negocio en sí. Son las aplicaciones que los desarrollares crean y exponen a través de la nube. Es decir, cuando desarrollamos para la nube, debemos exponer nuestro software como servicio (comúnmente mediante web services y estándares web).

Plataforma como servicio: Se refiere a todo el software y herramien-tas de administración que otorga el proveedor de servicios en la nube para desarrollar y administrar las aplicaciones. Esto incluye los SDKs, las consolas web para la administración de los recursos, y las APIs (que a su vez, también son servicios) para comunicarse con la infraestructura etc.

Figura 1. Conceptos que retoma el cómputo en la nube.

MAY-JUL 2009www.sg.com.mx 17

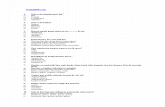

Figura 2. El stack de tecnologías que ofrece Azure

Infraestructura como servicio: Es como tal el hardware que el pro-veedor de servicios en la nube administra y facilita para el procesa-miento y hospedaje de nuestra aplicación.

La plataforma de Servicios Azure: Una solución completa para la nube:La plataforma de Servicios Azure representa una propuesta integral para resolver los retos que conlleva la implementación del cómputo en la nube. La figura 2 representa los mismos conceptos que la figura 1, pero en base al stack de tecnologías que conforman a Azure.

Las aplicaciones de negocio conforman el software como servi-cio (SaaS) que creamos específicamente para la plataforma Azu-re. Microsoft provee SDKs para diversas plataformas, como .NET, Java o Ruby que contienen ejemplos y todo lo necesario para de-sarrollar en la Azure, lo que permite utilizar todo el conocimiento de los desarrolladores al utilizar lenguajes y sintaxis familiares. Además existen herramientas para Visual Studio que permiten integrar completamente la experiencia de programación al IDE de Microsoft, que permite emular el ambiente de la nube, trabajando de forma local. Al terminar el desarrollo el programador accede al portal de administración de Azure y actualiza el proyecto para que quede publicado.

Los servicios de Azure corresponden a la plataforma como servicio (PaaS) lista para ser consumida que ofrece Microsoft para facilitar enormemente las tareas comunes para desarrollar en la nube. Esta plataforma ofrece los siguientes servicios:

• Live Services: Expone los servicios de Microsoft Live tales como identidad, comunicación, presencia, búsqueda, sincronización, ubi-cación geoespacial, etcétera.

• .NET Services: Proporciona bloques de código hospedados en la nube listos para usarse. Es como tener la biblioteca de clases del .NET

Framework, sólo que expuesta en la nube. Proporciona servicios como control de acceso, bus de servicios, flujos de trabajo entre otros.

• SQL Services: Proporciona una base de datos relacional consumi-ble vía REST o SOAP expuesta en la nube.

• SharePoint Services: Otorga servicios de colaboración y persona-lización para ser usados en la nube.

• Dynamics CRM: Da acceso por medio de la nube a los servicios de Microsoft Dynamics.

Windows AzureWindows Azure es el sistema operativo para la nube que se ejecuta exclusivamente en los Dataservers de Microsoft. No es posible des-cargarlo ni instalarlo en un servidor local. Windows Azure proporcio-na abstracción de hardware, almacenamiento, monitoreo y actuali-zación de los servicios, interoperabilidad de plataformas (.NET, Java, Ruby, PHP, COM etc.) y representa la infraestructura como servicio (IaaS) de Microsoft. Windows Azure asegura una disponibilidad 24/7 y se basa en reglas. La plataforma se encarga de la inmensa mayoría de las tareas de mantenimiento y administración.

Windows Azure encapsula la plataforma con la cual se ejecuta, la cual consiste de servidores virtualizados que ejecutan .Net 3.5 SP1, IIS 7 y Windows Server 2008 64 bits en full trust. Es decir, los usua-rios de Azure no tienen acceso directo al core de las máquinas vir-tuales sino que acceden al sistema operativo mediante los servicios expuestos por Windows Azure, mientras que Azure administra auto-máticamente todo el hardware (redes, DNS, almacenamiento, balan-ceo de carga, etcétera). Windows Azure además provee un servicio básico de almacenamiento basado en blobs, tablas y colas hospe-dadas en la nube. Podríamos decir que es el “sistema de archivos” de Windows Azure.

La tecnología de Windows Azure ha sido probada ya en diferentes servicios que ofrece Microsoft como Live Hotmail, es una plata-forma madura que ha sido ahora expuesta a los desarrolladores para su explotación.

Creando un “Hola SG”Para empezar a trabajar de inmediato con Azure sólo es necesario obtener e instalar las herramientas de Visual Studio para Azure. No hay necesidad de registro en el sitio de Azure a menos de que se desee publicar el servicio.

En este breve ejemplo crearemos un web cloud service básico.1. Iniciemos Visual Studio 2008 (si se desarrolla en Windows Vista o Windows 7, entonces es necesario ejecutarlo en modo administrador)2. Dentro de Visual Studio 2008 seleccionar File -> New -> Project3. En Project Types seleccionar “Cloud Service” y en los templates seleccionar “Web Cloud Service”.

MAY-JUL 2009 www.sg.com.mx18

/*TUTORIAL*/// PRODUCTOS

Miguel Angel Morán (Twitter: @SrBichi) y Misael Monterroca (Twitter: @mmonterroca) son Microsoft Most Valuable Professionals (MVP) en C#. Cuentan con 13 años de experiencia desarrollando y lidereando soluciones de software de misión crítica en las más diversas industrias. Participan activamente en conferencias, comunidades de desarrollo y divulgación tecnológica. Actualmente son consultores en emLink, empresa especializada en soluciones de software en las áreas de movilidad, comercio electrónico y colaboración.

4. El template seleccionado, creará dos proyectos: SGServicioEnLa-Nube que básicamente contiene los archivos de configuración de la aplicación (las reglas que seguirá Azure para entregar el servicio) y SGServicioEnLaNube_WebRole que simplemente es un proyecto web tradicional (Asp.Net Web Project)

5. El siguiente paso será abrir la página asp.net creada por default y crear un control tipo “Label” al cual le agregaremos un mensaje desde el code-behind:

<form id=“form1” runat=“server”> <div> <asp:Label runat=“server” id=“lblMensaje”></asp:Label> </div></form>

6. Abrimos el code-behind y en el evento Page_Load agregaremos un mensaje a nuestro Label:

8. Mientras la aplicación se ejecuta, el systray muestra un ícono que representa al programa “Development Fabric” que es un emulador que simula el ambiente de hospedaje real de Azure, aunque lo hace de manera local.

9. Para hospedar el servicio en Azure, debemos publicar el proyecto y posteriormente seleccionar con el menú contextual “Browse to Portal”.

protected void Page_Load (object sender, EventArgs e) { lblMensaje.Text = “Hola lectores de Software Guru”;}

7. Antes de realizar la depuración de nuestro sitio, es necesario establecer como proyecto de inicio el proyecto web (SGServicio-EnLaNube_WebRole ). Finalmente realizamos la depuración de nuestro proyecto, presionando F5 nuestro sitio web será desple-gado en nuestro navegador predeterminado, como cualquier otra aplicación ASP.NET

Figura 1. Creación de un nuevo proyecto para Azure en Visual Studio.

Figura 2. Arbol de elementos del proyecto.

Figura 3. Creación de un nuevo proyecto para Azure en Visual Studio.

10. Esto nos llevará al portal de Azure en internet (es necesario regis-trarse previamente, y para poder publicar aplicaciones primero hay que obtener un token). Seleccionamos New Project y posteriormen-te Hosted Services

11. El portal de Azure posteriormente solicitará un nombre único para la aplicación (único a nivel mundial).

Figura 4. Publicando la aplicación en Azure.

MAY-JUL 2009www.sg.com.mx 19

12. Como podemos ver, Azure muestra los servidores de staging (preproducción) y Producción. Al oprimir el botón Deploy el sis-tema nos preguntará la ruta en el disco duro local en la cual se encuentran los archivos generados en el paso 9 (con extensión . cscfg y .cspkg) Al terminar de subirse dichos archivos, el sistema publicará el proyecto y mostrará la ruta para acceder a la aplica-ción en la nube.

13. Posteriormente dentro del portal es posible promover el sitio de staging a producción.

Referencias:SDKs [microsoft.com/azure/sdk.mspx]Services [microsoft.com/azure/services.mspx]Herramientas de Azure para VS http:[is.gd/p3GV]FAQs de Azure [microsoft.com/azure/faq.mspx]Documentación para el desarrollo con Azure: [msdn.microsoft.com/azure]

Conclusiones:La plataforma de servicios Azure provee una poderosa y efectiva solución para desarrollar, administrar y hospedar aplicaciones basadas en la nube, en cualquiera de sus capas (software, plataforma e infraestructura), es una alternativa real para generar aplicaciones escalables, interoperables y con alta disponibilidad reduciendo significativamente la inversión de tiempo y los costos. Proporciona además un ambiente amigable para los desarrolladores, aumentando su productividad derivado de los servicios “out of the box” que la plataforma ofrece.

Figura 5. Escogiendo el ambiente correspondiente.

MAY-JUL 2009 www.sg.com.mx2020

// ENTREVISTA

Jorge Zavala es un viejo lobo de mar en la creación y desarrollo de empresas de tecnología. Fue por ello que en el 2004 la Fundación México Estados Unidos para la Ciencia (FUMEC) lo invitó para dirigir la oficina de TechBA en Silicon Valley, donde se dedica a apo-yar a empresas mexicanas de tecnología que buscan penetrar el mercado global. Recientemente tuvimos oportunidad de platicar con él para tratar de entender en qué consiste el DNA de Silicon Valley, y qué es lo que necesitan los empresarios mexicanos para competir y trascender en este contexto.

MAY-JUL 2009www.sg.com.mx 2121

¿En qué consisten tus actividades en TechBA?Básicamente tenemos tres actividades. La primera es estar en contacto con la indus-tria y los medios para identificar problemas que pueden significar oportunidades de negocio. En base a eso, buscamos empre-sas mexicanas que potencialmente puedan proveer soluciones para esos problemas y hacer negocio. Por último, buscamos los re-cursos de inversión para habilitar el negocio en cuestión. Estos recursos pueden consistir en fondos de los distintos programas de go-bierno, o también capital de riesgo.

¿Cómo ha sido la experiencia de estar en Silicon Valley?Es un ambiente con características fabulo-sas. Todos están buscando hacer el próximo Google y las cosas suceden a una velocidad impresionante. La gente quiere salir lo antes posible con un producto en donde no nece-sariamente está 100% terminado, pero tiene una primera etapa que es suficientemente útil y con perspectivas para desarrollarlo de una manera efectiva. Aquí la gente no tiene miedo a fracasar. Se utiliza un concepto que me fascina denominado “fail fast” (falla rápi-do). Es decir que si tienes una idea, la prue-bes en el mercado lo antes posible; si la idea es valiosa, corre a lograr el siguiente paso; si la idea es mala o tiene que ser mejorada, falla rápidamente y aprende de los errores.

¿Es viable replicar este modelo en otro lugar?Muchos ya lo han intentado. Yo creo que a final de cuentas el concepto sí es replicable. Sin embargo, lo primero que necesitas es la gente. Un error que se ha cometido en varios países es que ponen los recursos financieros por delante de la gente. Primero necesitas a la gente con mentes frescas que genere ideas y eso atraerá recursos.

¿Alguna decepción de Silicon Valley?Pues no es una decepción de Silicon Valley como tal, pero aquí me he dado cuenta que en México perdí grandes oportunidades por aferrarme a ideas por más tiempo del que debía o por no tener una visión más am-plia. Me he dado cuenta que es importante ver las cosas en grande, y que los negocios son para venderse, no para quedarse toda la vida con ellos.

¿A qué te refieres con que los negocios son para venderse?Como empresarios debemos tener la actitud de decir: “yo voy a arrancar esta idea, la voy

a llevar hasta donde llegan mis capacidades y esas capacidades van a tener que ser releva-das por alguien mas”. Pretender mantenerse como fundador, dueño y director es un error común en México. Por ejemplo en el caso de Yahoo! los dos fundadores hoy tienen uno el 3% y otro el 6% de la empresa, pero ese pequeño porcentaje representa miles de mi-llones de dólares. Pocas personas son un Bill Gates que tiene la capacidad de tener una buena idea, desarrollarla, llevarla al mercado y administrarla por 30 años.

¿Cómo hacemos que las empresas en Méxi-co sean atractivas para capital de riesgo?Justamente esa es la razón por la que empe-zó TechBA. La conclusión a la que hemos lle-gado es que la razón por la que no tenemos esas inversiones en México es porque no nos ponemos metas tan grandes y no buscamos esas grandes oportunidades.

Creo que hay tres elementos a considerar. El primero es tener una visión global. Tene-mos que salir a vender no lo que se vende en México, sino lo que el mundo necesita en to-dos lados. El segundo punto es que debemos aprender a hacer un posicionamiento y dife-renciación, encontrar nichos. Lo importante no es hacer el producto más avanzado, sino satisfacer una necesidad no resuelta. El tercer punto es aprender a integrarse a una cadena de valor. Hay que estar conscientes de que difí-cilmente nosotros solos podemos llevar nues-tro producto a todo el mercado.

Por otro lado, debemos romper el paradigma de querer ser un país barato. Si volteamos a ver, los iPod y los iPhones no son los más baratos y aun así están causando estragos en el mercado. Hay que buscar cómo posicionar nuestros productos en un mercado donde ge-neremos suficiente utilidad, y esa utilidad va a atraer inversionistas. Si buscamos solamente quedarnos con empresas de outsourcing de TI que compitan por precio con las empresas de India y China, pues vamos a tener un pro-blema muy serio, porque somos más caros (el costo de vida en México es más alto) y la capacidad de generar utilidad va a ser menor, y por lo tanto la inversión para empresas de este tipo seguirá yéndose a otros países.

¿Cómo podemos fomentar la innovación?Primero debemos entender que la innova-ción no solamente se da en condiciones científicas complejas, sino que se da en la vida diaria. La innovación inicia cuando las

personas identifican problemas cotidianos y platican al respecto con otras personas, ge-nerando nuevas ideas. Este componente de la discusión es muy importante y debemos fomentar este tipo de interacción.

En TechBA llevamos a cabo “espacios de in-novación”, que son sesiones en las que nos juntamos con 20 ó 30 empresas y discutimos sobre algún tema para generar alternativas de solución y oportunidades de negocio.

Otro ejemplo son los eventos como los Super Happy Dev Houses que ya se están haciendo en México, donde un grupo de programado-res se juntan y aprenden a hacer algo, pero también discuten sobre cómo mejorarlo. De un evento de estos salió la idea para el pro-yecto Twirex (www.twirex.com), de una dis-cusión sobre la dificultad en twitter para dar seguimiento a temas específicos. Este tipo de proyectos no necesariamente requiere de gigantescos recursos tecnológicos, sino de la habilidad de comunicación, de síntesis y de crear nuevos conceptos.

En México todavía creemos que cuando te-nemos una nueva idea o producto, la forma de mantener la ventaja competitiva es es-conderlo de los demás. Esto es una pérdida porque al esconderlo le quitamos la posibi-lidad de probarlo y fallar rápido. He tenido discusiones con empresarios mexicanos que han venido a verme y me dicen “es que no te puedo decir la idea que traigo, porque no sé si me la vas a copiar”. La verdad es que si en una plática de diez minutos alguien puede copiar tu idea y hacerla mejor, entonces tu idea no vale nada, y lo mejor es que te ente-res antes de dedicarle muchos recursos. ¿Qué mensaje le dejas a los lectores de SG?Lo que más deseo ver en los lectores de SG es un abierto interés por conquistar nuevos mundos y demostrar la gran capacidad que hay en los emprendedores mexicanos para conquistar nuevos mercados. México está lleno de problemas que se pueden convertir en grandes oportunidades para satisfacer necesidades que atañen no solo a los mexi-canos sino a personas de todo el mundo.

Es hora de alimentar nuestras propias moti-vaciones y transformar las inquietudes que todos tenemos dentro y que al liberarlas se conviertan en oportunidades invaluables donde podemos dejar nuestra huella y lograr nuestra realización personal.

MAY-JUL 2009 www.sg.com.mx22

MAY-JUL 2009www.sg.com.mx 23

Si eres uno de tantos desarrolla-dores que lleva años queriendo aprender a hacer aplicaciones para teléfonos móviles pero no

ha tenido oportunidad de hacerlo, más vale que no dejes pasar más tiempo.

En los últimos meses se han conjuntado distintos factores que han detonando la importancia (y por lo tanto la rentabilidad) de las aplicaciones de software en dispositivos móviles, especialmente el segmento de smartphones. Algunos factores tienen que ver con avances tecnológicos, otros con estandarización, y otros más con nuevos modelos de negocio.

Es así que en esta época de conectividad de banda an-cha, servicios de localización, plataformas multi-dis-positivo y tiendas de aplicaciones en línea, el momen-to ha llegado para desarrollar aplicaciones para estos dispositivos y debes aprovechar la oportunidad.

En las siguientes páginas te presentamos distintos artículos que van desde un repaso histórico de las tecnologías, a artículos técnicos para plataformas específicas y análisis de oportunidades de negocio.

MAY-JUL 2009 www.sg.com.mx24

Un vistazo al pasado y presente del smartphonepor Germán Domínguez

Aunque los smartphones parezcan un ícono de apenas los últimos años, en realidad estos dispositivos tienen ya bastante camino recorri-do. Conozcamos un poco sobre su evolución y cómo hemos llegado a lo que tenemos ahora.

En 1983 Casio lanzó el PF-3000, que fue el pri-mer “diario digital”. Esta era una calculadora digital que incluía capacidades para agenda telefónica, calendario y memo (notas).

Por otro lado, desde 1987 las comunicaciones celulares se activaron en México. En esos mo-mentos teléfonos como el Motorola DynaTac de dimensiones similares a un ladrillo y pantalla de una línea abrían el camino en esta industria.

En el 1992, IBM presentó el primer smar-tphone, conocido como IBM Simon Personal Communicator; vendido en Estados Unidos por BellSouth. Este dispositivo ya incluía ca-pacidades de agenda, calendario, calculado-ra, correo electrónico, envío/recepción de fax, pantalla táctil y escritura predictiva. Era un dispositivo muy avanzado para su época.

Referencias:www.wikipedia.comwww.palmsource.comwww.byte.com

MAY-JUL 2009www.sg.com.mx 25

El Apple Newton, lanzado en 1992, es conside-rado como el primer PDA (Personal Digital Assi-tant). De hecho, fue Apple quien acuñó este tér-mino para referirse al Newton. Este dispositivo contaba con un sistema operativo desarrollado en C++ e integraba funciones para envío e im-presión de documentos, procesador de pala-bras, agenda, calendario y calculadora. Adicio-nalmente, permitía el desarrollo de aplicaciones personalizadas mediante un lenguaje de pro-gramación propietario llamado NewtonScript. El ambiente de desarrollo para aplicaciones en Newton tenía un costo inicial de $1,000 dólares y sólo era soportado en sistemas Macintosh, lo cual limitó su popularidad. Eventualmente fue licenciado como shareware y finalmente sin costo, soportando adicionalmente Windows.

En 1996 Palm Computing lanza su línea Pilot. Éstos eran dispositivos monocromáticos, al-gunos sin iluminación en la pantalla ni puerto de comunicaciones infrarrojo, con capacidad de almacenamiento que fluctuaba desde los 128kb hasta 1Mb de memoria. Las “Pilot” rá-pidamente se hicieron populares por su precio y el sistema de reconocimiento de escritura conocido como Graffitti. Las funcionalidades esenciales de los PDAs empezaban a estan-dardizarse: todos deberían de incluir cuando menos agenda, calendario, bloc de notas y cal-culadora. Durante estos tiempos, el desarrollo de aplicaciones estaba basado en C; el IDE preferido para Palm era CodeWarrior de Me-trowerks, un ambiente de desarrollo original-mente creado para Macintosh que fue portado posteriormente a Windows.

En 1998 se acelera la carrera de los PDAs con la incursión en el mercado de HP y su línea Jor-nada. Estos dispositivos estaban basados en el sistema operativo Windows CE y tenían capa-cidades iniciales de 16MB de RAM, pantalla a color VGA y modem integrado. Las aplicaciones se desarrollaban en lenguajes de programa-ción como Embedded Visual Basic (eVB) y Em-bedded Visual C++ (eVC) usando un ambiente basado en Visual Studio conocido como Micro-soft Embedded Tools.

Los primeros esfuerzos para integrar comuni-caciones inalámbricas en los PDAs se dieron a principios de esta década. En 2001, el Hands-pring Visor ya soportaba un módulo de ex-tensión llamado VisorPhone que lo habilitaba como teléfono usando la red GSM. En el 2002 Handspring lanzó el Treo 180, que ya integraba capacidades de teléfono celular sin necesidad de dispositivos externos.

En el 2002 Research in Motion introduce al mer-cado los primeros dispositivos BlackBerry que incorporaban correo electrónico y telefonía ce-lular. Esta capacidad integrada de correo elec-trónico y telefonía móvil, hizo del BlackBerry el primer dispositivo completamente integrado y optimizado para comunicaciones inalámbricas.

Como consecuencia del incremento de pla-taformas y funcionalidades, durante este periodo los lenguajes de programación y ambientes de desarrollo para smartpho-nes aumentaron significativamente. Surgen RADs (Rapid Application Development) para dispositivos móviles, el más destacado: Sa-tellite Forms que permite el diseño visual de formas y pantallas para PalmOS y Windows Mobile. Los lenguajes tradicionales de desa-rrollo para dispositivos móviles se consoli-dan, pero también los lenguajes modernos comienzan a permear: Java 2 Micro Edition, .Net Compact Framework, Python. Esto trae como consecuencia que el universo de desa-rrolladores para dispositivos móviles crezca significativamente, y con ello la cantidad de aplicaciones disponibles.

Durante los años 2003-2007, los fabricantes tradicionales de PDAs pasaron por momentos de silencio, seguían produciendo dispositivos con las mismas características, aunque incre-mentaban las capacidades de procesamiento y almacenaje. Palm produce nuevas versiones de Treo, algunas con el sistema operativo Pal-mOS y otras con Windows Mobile. HP tampoco incorpora grandes innovaciones, más allá de incorporar lectores de huella digital. BlackBe-rry se consolida en el mundo corporativo con su integración segura con el correo corporativo mediante su BlackBerry Enterprise Server. Por el lado de los fabricantes de teléfonos, Nokia incursiona en el sector de smartphones con la serie N iniciada con el modelo N70, basado en el sistema operativo Symbian, incorporaba pantalla a color, cámara fotográfica, soporte de aplicaciones Java, mensajes multimedia, nave-gador Opera, radio y tonos polifónicos. Con esto se inicia una carrera entre los fabricantes de te-léfonos celulares para brindar cada vez mayor convergencia en sus dispositivos. Por su parte, durante esta etapa los proveedores de redes ce-lulares se dedicaron a madurar sus tecnologías y prepararse para la migración hacia GSM y 3G.

El letargo se rompe en 2007 cuando Apple lanza al mercado el iPhone, el cual asombró al vender más de 270,000 dispositivos en las pri-meras 30 horas. Una de las características mas

importantes del iPhone es su sistema operativo propietario con una interfaz de usuario única y un acelerómetro integrado, que permite cam-biar la posición de la imagen en la pantalla de acuerdo con la posición física del teléfono. Adicionalmente, el teléfono reconoce “gestos” realizados con los dedos sobre la pantalla, para ejecutar acciones.

En 2008 en México los principales proveedores de telefonía celular habilitan su red para sopor-tar GSM / 3G lo cual abre el camino para nuevos dispositivos y servicios.

Apple libera el iPhone SDK, a través del cual se pueden desarrollar aplicaciones para el iPhone usando el ambiente de desarrollo XCode. Asi-mismo, Apple abre su “App Store”, una tienda de aplicaciones en línea donde los desarrolladores pueden ofrecer sus aplicaciones para que sean compradas y descargadas por los usuarios. En poco más de 9 meses de existencia, el iPhone App Store acumula más de 35,000 aplicaciones y ha superado el billón (mil millones) de descar-gas. Queda claro que el impacto de este modelo para ofertar aplicaciones. Tanto así que el resto de los proveedores, desde Microsoft hasta Re-search in Motion, ya han anunciado sus propios “app stores”.

También en el 2008 se libera Android, una plataforma “open source” para smartphones. Detrás de éste lanzamiento están Google, In-tel, eBay y otros que forman el Open Headset Alliance. Android está basado en el sistema operativo Linux y las aplicaciones se progra-man en Java, lo que lo hace atractivo a una gran cantidad de desarrolladores.

En el 2009, el ritmo se ha acelerado aun más. Apple ya liberó el beta del iPhone SDK 3.0, Android ya se encuentra en versión 1.5, y para cuando leas estas líneas Microsoft ya habrá liberado la versión 6.5 de Windows Mobile, la cual incorpora capacidades de cómputo en la nube. Antes de que termine el verano Palm lan-zará el Palm Pre con el nuevo sistema operativo WebOS, en el cual las aplicaciones se desarro-llan usando tecnologías sencillas y conocidas como HTML, Javascript y CSS.

Aún hay mucho material adicional que cubrir, tecnologías, productos y nuevos lanzamien-tos. Pero al final nuestra labor como desa-rrolladores es mantenernos actualizados. El reto es encontrar la aplicación del billón de dólares que por más de 10 años se ha busca-do para esta industria.

Germán Domínguez es Licenciado en Informática Administrativa de UNITEC con más de 13 años de experiencia en el desarrollo de aplicaciones de negocio y aplicaciones Web. Ahora pertenece al equipo de IT de IBM de México, especialista para la marca de software Rational, y puede ser contactado en [email protected]

MAY-JUL 2009 www.sg.com.mx26

Un modelo con alto potencial en aplicaciones móvilespor Héctor Obregón

Hace varios años el concepto de aplicacio-nes peer to peer en Internet se popularizó y dio origen a una amplia variedad de solu-ciones que ya forman parte de nuestra vida diaria, tales como Messenger, Windows Live Sync, Skype y BitTorrent entre otras.

¿Qué es peer to peer?En un modelo peer to peer necesariamente participan dos o más colegas (peers) co-rriendo en dispositivos –la mayor parte de las veces una PC– que se comunican direc-tamente entre si en un modelo uno a uno o muchos a muchos, sin pasar a través de un servidor central para la parte medular de la interacción entre ellos.

En la mayoría de las aplicaciones peer to peer un servidor central actúa únicamen-te como un directorio que le permite a los diferentes peers encontrarse entre sí. Por ejemplo, cuando quiero llamar a alguien a través de Skype, mi PC obtiene las di-recciones de mis contactos de un servidor central que conoce las ubicaciones de todos. Sin embargo, una vez que inicio la

llamada todos los datos de esta se inter-cambian mediante una conexión directa entre mi PC y la del contacto con el que estoy hablando. Los datos de la llamada ya no fluyen a través del servidor central. Este esquema se conoce como peer-to-peer “suave”.

En un modelo peer to peer puro o completo, no hay distinción entre cliente y servidor y todas las funciones de indexación y localiza-ción están a cargo de los mismos clientes. Las principales ventajas de este modelo son su escalabilidad y resistencia a fallas. Dado que cada peer funge tanto como cliente como servidor, agregar nodos a la red impli-ca incrementar casi linealmente los recursos disponibles de cómputo y comunicaciones. Adicionalmente, como ningún nodo juega un rol especial, la pérdida o falla de uno normal-mente no afecta el funcionamiento de la red global que sostiene a la aplicación. BitTorrent es un excelente ejemplo de un protocolo peer to peer que es altamente escalable, resisten-te y prácticamente imposible de controlar por una autoridad central.

El escenario móvilHoy existen pocas aplicaciones móviles con un modelo de este tipo que verdaderamente aprovechen los diferenciadores de un dispo-sitivo móvil. Es cierto que hay versiones móvi-les de Skype o Messenger, pero en mi opinión hay un amplio terreno sin explotar en aplica-ciones móviles peer to peer.

Cuando hablamos de soluciones para movili-dad, tenemos que ir más allá de hacer lo mismo que hacíamos en la PC pero ahora en pequeño. El diferenciador obvio de un dispositivo móvil es….. ¡que se mueve! La ubicación se vuelve relevante para que pensemos en aplicaciones móviles peer to peer que verdaderamente ha-gan sentido.

La ubicación tiene dos connotaciones:1. ¿Dónde estamos ubicados en el planeta? De-finido por nuestras coordenadas – latitud, longi-tud y altura – obtenidas mediante alguna forma de posicionamiento – GPS, trangulación, etc. –2. ¿Quién está cerca de mi? En este caso no es necesario conocer nuestra posición absoluta, el simple hecho de poder identificar qué es lo

MAY-JUL 2009www.sg.com.mx 27

que está cerca de mí puede proveerme con información interesante.

Es en la convergencia del modelo peer to peer con la información de nuestra ubicación absolu-ta y relativa donde está el verdadero potencial de innovación en aplicaciones móviles. Pense-mos en algunos ejemplos ...

Un automóvil podría comunicar a cualquier otro cercano que ha sufrido un accidente. Es-tos a su vez podrían retransmitir esta informa-ción a otros de tal forma que conductores que se acercan al punto del problema sean adver-tidos. Podría funcionar incluso para compartir información de las condiciones de tráfico que nos ayuden a elegir mejores rutas.