r66951

-

Upload

guadalupe-hurtado -

Category

Documents

-

view

29 -

download

1

Transcript of r66951

-

UNIDAD 4: CADENAS DE MARKOV

INSTITUTO TECNOLOGICO SUPERIOR DE CALKINI EN EL ESTADO DE

INVESTIGACIN DE OPERACIONES II INC

INVESTIGACION DE OPERACIONES II

UNIDAD 4: CADENAS DE MARKOV

INSTITUTO TECNOLOGICO SUPERIOR DE CALKINI EN EL ESTADO DE CAMPECHE

INGENIERIA INDUSTRIAL

MATERIA: INVESTIGACIN DE OPERACIONES II INC-1019

TRABAJO DOCUMENTAL

PROFRE:

GOMEZ KU RICARDO

7 SEMESTRE GRUPO: A

CALKINI, CAMP., 20 DE SEPTIEMBRE DE

INVESTIGACION DE OPERACIONES II

1

INSTITUTO TECNOLOGICO SUPERIOR DE CALKINI EN EL ESTADO DE

CALKINI, CAMP., 20 DE SEPTIEMBRE DE 2010

-

INVESTIGACION DE OPERACIONES II

UNIDAD 4: CADENAS DE MARKOV 2

NDICE

CAPITULO I

OBJETIVOS Y/O COMPETENCIAS....3

CAPITULO II

INTRODUCCIN.4

CAPITULO III

4. CADENAS DE MARKOV6

4.1. INTRODUCCIN A LAS CADENAS DE MARKOV...6

4.2. PROBABILIDAD DE TRANSICIONES ESTACIONARIAS DE N PASOS.9

4.3. ESTADO ESTABLE16

4.4. ESTADOS ABSORBENTES..23

4.5. USO DE SOFTWARE

CONCLUSIN..28

BIBLIOGRAFIA.29

-

INVESTIGACION DE OPERACIONES II

UNIDAD 4: CADENAS DE MARKOV 3

CAPITULO I

UNIDAD 4: CADENAS DE MARKOV

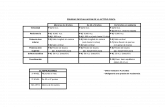

Competencia especifica a desarrollar Actividades de Aprendizaje

Utilizar las cadenas de Markov para la resolucin de problemas.

Utilizacin de software

Identificar las caractersticas de los modelos y problemas de Cadenas de Markov.

Formular y resolver problemas en sistemas que se pueden modelar por el mtodo de cadenas de Markov.

Establecer y explicar las conclusiones y recomendaciones para sistemas de este tipo.

-

INVESTIGACION DE OPERACIONES II

UNIDAD 4: CADENAS DE MARKOV 4

CAPITULO II

INTRODUCCIN En las cadenas de Markov considera ciertos puntos discretos en el tiempo , para toma valores de 1, 2, 3,. Y la variable aleatoria que caracteriza al sistema . Y la familia de las variables aleatorias forma un proceso llamado proceso estocstico. Entonces las cadenas de Markov se usan para estudiar ciertos comportamientos de largo y cortos plazos de sistemas estocsticos.

Para un proceso de Markov es un sistema estocstico siempre que cumpla con la propiedad Markoviana.

Los estados en el tiempo representan situacin exhaustiva y mutuamente excluyentes del sistema en un tiempo especfico. Adems el nmero de estado puede ser finito o infinito. Un ejemplo es el juego de lanzar la moneda. Por lo general una cadena de Markov describe el comportamiento de transicin de un sistema en intervalos de tiempo igualmente espaciados. Sin embargo, existen situaciones donde los espaciamientos temporales dependen de las caractersticas del sistema y por ello, pueden no ser iguales entre s. Estos casos se denominan cadenas de Markov incrustadas.

Con las probabilidades absolutas y de transicin podremos hacer predicciones de comportamientos futuros como las que se observaron en las situaciones anteriores. As, si llamamos estados a cada una de estas posibilidades que se pueden presentar en un experimento o situacin especfica, entonces podemos visualizar en las Cadenas de Markov una herramienta que nos permitira conocer a corto y largo plazo los estados en que se encontraran en periodos o tiempos futuros y tomar decisiones que afectarn o favorecern nuestros intereses. Las probabilidades absolutas y de transicin son exhaustivas y mutuamente excluyentes de un experimento aleatorio en cualquier tiempo.

Las cadenas de Markov son modelos probabilsticos que se usan para predecir la evolucin y el comportamiento a corto y a largo plazo de determinados sistemas. Ejemplos: reparto del mercado entre marcas; dinmica de las averas de mquinas para decidir poltica de mantenimiento; evolucin de una enfermedad.

Las cadenas de Markov se pueden aplicar en reas como la educacin, comercializacin, servicios de salud, finanzas, contabilidad y produccin. En este captulo se analizan las ideas bsicas necesarias para entender las cadenas de Markov.

-

INVESTIGACION DE OPERACIONES II

UNIDAD 4: CADENAS DE MARKOV 5

Muchas de las aplicaciones interesantes de las cadenas de Markov tienen que ver con cadenas en las que algunos de los estados son absorbentes y el resto son estados transitorios

Estado estable es una matriz de transicin de una cadena ergodiga, en la cual existe un vector, [ ]npipipipi 21 ,= que tambin es llamado distribucin de estado estable o distribucin de equilibrio, para la cadena de Markov. Cuenta con interpretacin intuitiva de probabilidades el cual se obtiene restando de ambos lados de la ecuacin de probabilidad.

-

INVESTIGACION DE OPERACIONES II

UNIDAD 4: CADENAS DE MARKOV 6

CAPITULO III

4. CADENAS DE MARKOV

4.1-. INTRODUCCIN A LAS CADENAS DE MARKOV LAS CADENAS DE MARKOV

Considere los puntos discretos en el tiempo para 1,2 y sea la variable aleatoria que caracteriza el estado del sistema . La familia de variables aleatorias forma un proceso estocstico. Los estados en el tiempo representan realmente las situaciones (exhaustiva y mutuamente excluyentes) del sistema en ese tiempo especfico. El nmero de estados puede ser entonces finito o infinito.

Por ejemplo, la distribucin de Poissn !

Representa un proceso estocstico con un nmero infinito de estados. Variable aleatoria n representa aqu el numero de sucesos entre o y t (suponiendo que el sistema comienza en el tiempo 0). Los estados del sistema en cualquier tiempo t estn dados por 0,1,2 Otro ejemplo: es el juego de lanzar la moneda con k lanzamientos. cada lanzamiento se puede interpretar como un punto en el tiempo. La secuencia resultante de lanzamientos constituye un proceso estocstico. El estado del sistema en cualquier lanzamiento es guila o sol, o bien, cara o cruz.

Una cadena de Markov es en realidad un caso especial de procesos de Markov. Se usa para estudiar el comportamiento a corto y largo plazo de ciertos sistemas estocsticos.

PROCESOS DE MARKOV

Un proceso de Markov es un sistema estocstico en el que la ocurrencia de un estado futuro depende del estado inmediatamente precedente y slo de l. As, si 0,1,2, representa puntos en el tiempo, la familia de variables aleatorios es un proceso de Markov, si sta posee la siguiente propiedad Markoviana:

"#$ , , % " "#$ "&

-

INVESTIGACION DE OPERACIONES II

UNIDAD 4: CADENAS DE MARKOV 7

Para todos los valores posibles de % , $ , , . La probabilidad '& ," "#$ "& se llama probabilidad de transicin. Representa la probabilidad condicional de que el sistema est en " en , dado que estaba en "& en &. Esta propiedad tambin se denomina probabilidad de transicin de un paso, ya que describe al sistema entre & y . Una propiedad de transicin de m pasos se define entonces como: ','() *+ "*+# " CADENAS DE MARKOV

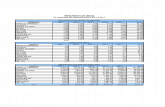

Sean ,, ,-, , ,./ 0,1,2, los estados exhaustivos y mutuamente excluyentes de un sistema en un tiempo cualquiera. Inicialmente, en el tiempo , el sistema puede estar en cualquiera de esos estados. Sean 0./ 0,1,2, las probabilidades absolutas de que el sistema se encuentra en el estado ,. en . Suponga adems que el sistema es Markoviana. Definimos 1. /#$ 2 Como la probabilidad de transicin de un paso, de pasar del estado 2 en & al estado / en , suponemos que esas probabilidades de transicin del estado E4 al estado E5 se pueden arreglar ms conveniente en forma de matriz como sigue:

P 789ppp-p;