REGRESIÓN..[1] faltamnte

-

Upload

edgar-garcia-guerrero -

Category

Documents

-

view

215 -

download

2

description

Transcript of REGRESIÓN..[1] faltamnte

![Page 1: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/1.jpg)

INTRODUCCIÓN

Como la Estadística Inferencial nos permite trabajar con una variable a nivel de intervalo o razón, así también se puede comprender la relación de dos o más variables y nos permitirá relacionar mediante ecuaciones, una variable en relación de la otra variable llamándose Regresión Lineal y una variable en relación a otras variables llamándose Regresión múltiple.Casi constantemente en la práctica de la investigación estadística, se encuentran variables que de alguna manera están relacionados entre sí, por lo que es posible que una de las variables puedan relacionarse matemáticamente en función de otra u otras variables.La Regresión se define como un procedimiento mediante el cual se trata de determinar si existe o no relación de dependencia entre dos o más variables. Es decir, conociendo los valores de una variable independiente, se trata de estimar los valores, de una o más variables dependientes.La regresión en forma gráfica, trata de lograr que una dispersión de las frecuencias sea ajustada a una línea recta o curva.Como sabemos la estadística inferencial es muy importante en nuestra vida cotidiana ya que veremos los dos tipos de estadística ya sea descriptiva o inferencial y cuál es su importancia y abarca lo que son los tipos de regresiones lineales que a continuación vamos a ver.

![Page 2: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/2.jpg)

REGRESIÓN LINEAL SIMPLE

El análisis de regresión es una técnica estadística para investigar la relación funcional entre dos o más variables, ajustando algún modelo matemático. La regresión lineal simple utiliza una sola variable de regresión y el caso más sencillo es el modelo de línea recta.

En muchos problemas hay dos o más variables inherentes relacionados, y es necesario explorar la naturaleza de esta relación. El análisis de regresión es una técnica estadística para modelar e investigar la relación entre dos o más variables.

Deseamos determinar la relación entre una sola variable regresiva X y una variable de repuesto Y. La variable regresiva X se supone como una variable matemática continua, controlable por el experimentador. Supóngase que la verdadera relación entre Y y X es una línea recta, y que la observación Y en cada nivel de X es una variable aleatoria. Luego, el valor esperado de Y para cada valor de X es:

EC.1 Donde:La ordenada de origen 0 y la pendiente 1 son constantes desconocidas.Suponemos que cada observación Y, puede describirse mediante el modelo siguiente: EC.2 Donde:E = error aleatorio con media cero y varianza 2 .

Por medio del método de mínimos cuadrados estimaremos 0 y 1 de manera que la suma de los cuadrados de las desviaciones entre las observaciones y la línea de regresión sean mínimas.Empleando la EC. 2, podemos escribir:

i = 1 , 2 , 3 , … , n EC.3

Y la suma de los cuadrados de las desviaciones de las observaciones respecto a la línea de regresión verdadera es:

EC.4

Los estimadores de mínimos cuadrados de 0 y 1, digamos deben satisfacer:

EC.5

La simplificación de estas dos ecuaciones produce:

EC.6

Las ecuaciones 6 se denominan ecuaciones normales de mínimos cuadrados.La solución para la ecuación normal es:

EC.7

![Page 3: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/3.jpg)

EC.8

Donde:

Por lo tanto, las ecuaciones 7 y 8 son los estimadores por mínimos cuadrados, de la ordenada al origen y la pendiente, respectivamente. El modelo de regresión lineal simple ajustado es:

EC.9

Respecto a la notación, es conveniente dar símbolos especiales al numerador y al denominador de la ecuación 8, esto es:

EC.10

EC.11

Llamaremos a Sxx la suma corregidora de cuadrados de “x” y a Sxy la suma corregida de productos cruzados de “x” y “y”. Los datos del extremo derecho de las ecuaciones 10 y 11 son las fórmulas de cómputo usuales.Al emplear esta nueva notación, el estimador de mínimos cuadrados de la pendiente es:

EC.12

Ejemplo 1:Un ingeniero químico está investigando el efecto de la temperatura de operación de proceso en el rendimiento del producto. El estudio da como resultado los siguientes datos:

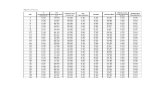

Temperatura Rendimiento°C “X” % “Y” XjYj Xj2 Yj2

100 45 4500 10000 2025

![Page 4: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/4.jpg)

110 51 5610 12100 2601120 54 6480 14400 2916130 61 7930 16900 3721140 66 9240 19600 4356150 70 10500 22500 4900160 74 11840 25600 5476170 78 13260 28900 6084180 85 15300 32400 7225190 89 16910 36100 7921

∑ 1450 673 101570 218500 47225

El examen de este diagrama de dispersión indica que hay una fuerte relación entre el rendimiento y la temperatura, y la suposición tentativa del modelo de línea recta parece razonable.n = 10

Sustituyendo en EC.10 y EC.11

Los estimadores de mínimos cuadrados de la pendiente y la ordenada al origen son:

El modelo de regresión lineal simple ajustado es:

Suele ser necesario obtener una estimación de . La diferencia entre la observación Yj y el

correspondiente valor predicho , la diferencia digamos ej = Yj - , se denomina un residuo. La suma

de los cuadrados de los residuos, o la suma de cuadrados del error, sería:

SSE = ej2 SSE = (Yj – )2 EC. 14

![Page 5: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/5.jpg)

Una fórmula de cálculo más conveniente para SSE puede encontrarse sustituyendo el modelo ajustado

en la EC. 14 y simplificando considerando que (Yj – )2 entonces podemos escribir SSE como:

SSE = Syy - Sxy EC. 15

El valor esperado de la suma de cuadrados del error E(SSE) = (n-2), por lo tanto:

el cual es un estimador de .

PRUEBA DE HIPÓTESIS EN LA REGRESIÓN LINEAL SIMPLE.

Una parte importante de la evaluación de la suficiencia del modelo de regresión lineal simple es la prueba de hipótesis estadística en torno a los parámetros del modelo y la construcción de ciertos intervalos de confianza. Para probar la hipótesis con respecto a la pendiente y la ordenada al origen del modelo de regresión, debemos de hacer la suposición adicional de que la componente del error “ej” se distribuye normalmente. Por consiguiente, las suposiciones completas son que los errores son NIP (0, 2). Después analizaremos como pueden verificarse estas suposiciones mediante el análisis residual.

Supóngase que deseamos probar la hipótesis de que la pendiente es igual a una constante, digamos , las hipótesis apropiadas son:

EC. 16

![Page 6: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/6.jpg)

Donde hemos supuesto una alternativa de dos lados (bilateral). Como resultado de la suposición de normalidad, el estadístico es:

EC. 17

Sigue la distribución t con n-2 grados de libertad bajo

Rechazaríamos H0 sí: EC. 18

Donde se calcula a partir de la EC. 17 puede emplearse un procedimiento similar para probar la hipótesis respecto a la ordenada al origen. Para probar

EC. 19

Usaríamos el estadístico:

EC. 20

Y se rechaza la hipótesis nula si ; un caso especial muy importante de la hipótesis de la ecuación es:

EC. 21Esta hipótesis se relaciona con la significación de la regresión. El procedimiento de prueba para puede desarrollarse a partir de desplazamientos. El primer planteamiento se inicio con la siguiente división.

+ EC. 22

Las dos componentes Syy miden, respectivamente, el tamaño de la variabilidad en la “yj,” explicada por la línea de regresión y la variación residual dejada sin explicar por la línea de regresión, solemos llamar a:

n

SSE = ∑ (Yj – j)2 la suma de los cuadrados del error, j =1

nSSR = ∑ (Yj – Yj)2 la suma de regresión de cuadrados. j =1

Por consiguiente la EC. 22 puede escribirse como: Syy = SSR + SSE EC. 23

Al comparar la EC. 23 con la EC. 15, notaremos que la suma de regresión de cuadrados SSR es :SSR = 1Sxy EC. 24Syy tiene n-1 grados de libertad, y SSR y SSE tiene 1 y n-2 grados de libertad respectivamente. Podemos mostrar que:

E SSE = σ2

(n-2) y E(SSR)= σ2 + β12Sxx

Y que SSE y SSR son independientes. Por tanto, si Ho: β1 = 0; es verdadera, entonces el estadístico:

SSR

F0 = 1 = MSR EC. 25 SSE MSE

![Page 7: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/7.jpg)

(n-2)

Sigue la distribución F1, n-2, y rechazaríamos H0 si F0 >

El procedimiento de prueba suele arreglarse en una tabla de análisis de varianza, tal como la tabla 1.Análisis de varianza para probar la significancia de la regresión:

Fuente de Variación

Suma de cuadrados

Grados de Libertad

Media cuadrática F0

Regresión SSR = 1Sxy 1 MSR MSR / MSE

Error Residual SSE = Syy - 1Sxy n-2 MSE

Total de Grados Syy n-1

La prueba para la significancia de la regresión puede desarrollarse también a partir de la EC. 17 con B1,0 = 0, digamos:

EC. 26

Al elevar al cuadrado ambos lados de la Ec. 26, obtenemos:

t02 = 1

2 Sxx = 1Sxy = MSR EC. 27 MSE MSE MSE

Nótese que t02 en la Ec. 27 es idéntico a F0 en la EC. 25, es cierto en general, que el cuadrado de una variable

aleatoria t con f grados de libertad es una variable aleatoria F, con uno y f grados de libertad en el numerador y el denominador, respectivamente. En consecuencia, la prueba que utiliza t 0 es equivalente a la prueba basada en F0.

Ejemplo 2: Probablemente el modelo desarrollado en el ejemplo 1 en lo que se refiere a la significación de regresión. El modelo ajustado es:

= -2.73939 + 0.480303X, y Syy se calcula como:

Tabla 2: Prueba para la significancia de la regresión, ejemplo 2.

Fuente de variación Suma de los cuadrados

Grados de libertad Media cuadrática Fo

RegresiónErrorTotal

1924.877.23

1932.10

189

1924.870.90

2138.74

F01, 1, 8 = 11.26 F0.025, 8, 1 = 7.57 Tabla 5

La suma de regresión de cuadrados es: SSR = 1Sxy = (0.4830303)(3,985) = 1924.87

Y la suma de cuadrados de 1 error es: SSE = Syy-SSR = 1932.10-1924.87 = 7.23

![Page 8: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/8.jpg)

El análisis de varianza para probar H0 = B1 = 0 se resume en la tabla 2. Al notar que F0 = 2138.74 > F01,1,8 = 11.26, rechazamos Ho y concluimos que H1: B1 0.

ESTIMACIÓN DE INTERVALOS EN LA REGRESIÓN LINEAL SIMPLE.

Además de la estimación puntual de la pendiente y la ordenada al origen, es posible obtener estimaciones del intervalo de confianza de estos parámetros. El ancho de estos intervalos de confianza es una media de calidad total de la línea de regresión. Si las “ej” se distribuyen normal e independientemente, entonces:

y

Se distribuye como t con n-2 grados de libertad, en consecuencia, un intervalo de confianza del 100% (1-) por ciento en la pendiente B1 esta dada por:

EC.28

De manera que similar a un intervalo de confianza del 100% (1-) en la ordenada del origen es:

EC.29

Ejemplo 3: Determinemos un intervalo de confianza del 95% en la pendiente de la línea de regresión

empleando los datos en el ejemplo 1. Recuérdese que =0.48303, Sxx =8250 y MSE =0.90 de la tabla 2.

Sustituyendo obtenemos:

Puede construirse un intervalo de confianza del 100% (1-) alrededor de la línea de regresión verdadera de X = Xo puede calcularse a partir de:

EC.30El intervalo de confianza para E (y / X0)es una función de X0. El ancho de un intervalo es un mínimo para Xo = X y se ensancha conforme l X0-X l aumenta.

X0

yj LIMITES DE INTERVALO 95% INTERVALO E(Y/X0)

100 45 45.56 -1.29 1.29 44.27 A 46.84 -0.56 0.3136

![Page 9: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/9.jpg)

110 51 50.39 1.09 1.09 49.29 A 51.48 0.61 0.3721120 54 55.22 0.92 0.92 54.30 A 56.14 -1.22 1.4884130 61 60.05 0.78 0.78 59.27 A 60.83 0.95 0.9025140 66 64.88 0.7 0.7 64.18 A 65.58 1.12 1.2544150 70 69.72 0.7 0.7 69.02 A 70.42 0.28 0.0784160 74 74.55 0.78 0.78 73.77 A 75.33 -0.55 0.3025170 78 79.38 0.92 0.92 78.46 A 80.30 -1.38 1.9044180 85 84.21 1.09 1.09 83.12 A 85.30 0.79 0.6241190 89 89.04 1.29 1.29 87.75 A 90.33 -0.04 0.0016

0.00 7.2420Ejemplo 4: Construimos un intervalo de confianza del 95% en torno a la línea de regresión para los datos en el ejemplo 1. El modelo ajustado es Y 0 = - 2.73939 + 0.48303 X. X0 y el intervalo de confianza en E (y/X0).

ó :

Los valores ajustados de y los correspondientes limites de confianza del 95% para los puntos Xo = Xj, j =

1, 2, . . . ,10, se representan en la tabla 3, podemos encontrar el intervalo de confianza del 95% en la media real del proceso en Xo = 140° C.

![Page 10: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/10.jpg)

REGRESION LINEAL MULTIPLE

En la regresión lineal múltiple tratamos de determinar la relación existente entre la variable dependiente (Y) y dos o más variables independientes ( X1, X2, X3, ..., XK ) también llamadas variables regresoras.En este caso la variable dependiente se ve afectada por los cambios que se le hagan a las variables independientes en conjunto.La relación entre las variables regresoras y la variable dependiente se establece mediante el modelo general de regresión lineal múltiple:

kk XXXXY 3322110

Donde 0, 1, 2, ..., k son los parámetros del modelo ( se tienen k variables independientes y p parámetros ).En este caso 0 representa la ordenada en el origen, es decir, el punto donde el hiperplano corta al aje Y (al haber más de dos variables independientes la relación queda representada por medio de un hiperplano).

En general i representa el cambio esperado en Y por cada incremento unitario en X i, siempre y cuando las demás variables independientes permanezcan constantes.Por comodidad en la simplicidad de las operaciones, emplearemos en esta ocasión sólo dos variables independientes. Quedará al lector utilizar más de dos variables independientes para futuras aplicaciones.

Al utilizar dos variables independientes, el modelo general de regresión lineal múltiple queda representado por:

22110 XXY

Donde:

0 representa el punto donde el plano corta al eje Y (ahora la relación entre las dos variables independientes y Y está representada por un plano).

1 representa el cambio esperado en Y por cada incremento unitario en X1, siempre y cuando X2 permanezca constante.

2 representa el cambio esperado en Y por cada incremento unitario en X2, siempre y cuando X1 permanezca constante.

![Page 11: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/11.jpg)

La figura siguiente muestra la relación entre las variables independientes y Y.

ESTIMACION DE PARAMETROS

Para encontrar los estimadores de los parámetros del modelo, partiremos de una muestra aleatoria de tamaño n para valores de X1, X2 y Y:

X1i X2i Yi

X11 X21 Y1

X12 X22 Y2

X13 X23 Y3

.

.

.

.

.

.

.

.

.

X1

X2

Y

22110 XXY

![Page 12: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/12.jpg)

X1n X2n Yn

Al utilizar una muestra aleatoria para estimar los parámetros, incurriremos en un error en la estimación. Debemos agregar dicho error al modelo de regresión lineal múltiple:

22110 XXY

Donde es un error aleatorio con media 0 y varianza 2.

Cada una de las observaciones de Y se puede representar mediante el modelo anterior:

iiii XXY 22110

Si utilizamos el enfoque de vectores y matrices, las observaciones de Y quedarán representadas mediante:

XY

donde:

nY

YY

.

.

.2

1

Y

nn XX

XXXX

21

2212

2111

1

11

.

.

.

.

.

.

.

.

.X

2

1

0

β

n

.

.

.2

1

ε

El método a utilizar en la estimación de los parámetros del modelo es el método de mínimos cuadrados. Dicho método consiste en minimizar la función de mínimos cuadrados.

La función de mínimos cuadrados está dada por la letra L y es igual a la suma de todos los errores elevados al cuadrado:

n

iiL

1

2

Si multiplicamos la transpuesta del vector por el mismo vector obtendremos la suma de los errores elevados al cuadrado:

n

ii

1

2εε

La función de mínimos cuadrados quedará como:

εε L

![Page 13: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/13.jpg)

Ahora bien, si de la ecuación vectorial del modelo de regresión anterior despejamos el error:

XβYε Sustituyéndolo en L:

XβYXβYεε L

Al realizar las operaciones anteriores y simplificando se llega a lo siguiente:

22 XβXYβXYY L

Derivando la función anterior con respecto de β , evaluando para β̂ e igualando a cero:

0 βXXYXβ β

ˆˆ

L

Despejando β̂ :

YXXXβ 1ˆ

Donde:

2

1

0

ˆˆˆ

β̂

n

ii

n

iii

n

ii

n

iii

n

ii

n

ii

n

ii

n

ii

XXXX

XXXX

XXn

1

22

121

12

121

1

21

11

12

11

XX

n

iii

n

iii

n

ii

YX

YX

Y

12

11

1

YX

De esta manera, el modelo de regresión lineal múltiple ajustado queda definido por:

22110 XXY ˆˆˆˆ

![Page 14: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/14.jpg)

PRUEBAS DE HIPOTESIS EN LA REGRESION LINEAL MULTIPLE

PRUEBA DE SIGNIFICANCIA

La prueba de significancia del modelo nos permite determinar estadísticamente si las variables independientes (en conjunto) tienen efecto o no sobre la variable dependiente.

Para realizar esta prueba se requiere descomponer la suma total de cuadrados, representada por Syy, en dos componentes: SSR y SSE

Syy = SSR + SSEDonde:

Syy es la suma total de cuadradosSSR es la suma de cuadrados de la regresiónSSE es la suma de cuadrados del error

Las ecuaciones apropiadas para calcular las expresiones anteriores son:

Partimos de las hipótesis:

Utilizamos la tabla de análisis de varianza:

![Page 15: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/15.jpg)

Fuente de Variación

Suma de cuadrados

Gradosde libertad

Media de cuadrados Estadístico de prueba

Regresión SSR k

Error SSE n – p

Total Syy n – 1

El estadístico de prueba F0 tiene una distribución F (Fisher) con v1 = k y v2 = n – p grados de libertad en el numerador y el denominador, respectivamente.

En este caso, si el estadístico de prueba es mayor que el valor de tablas F , k, n – p, se rechaza la hipótesis nula; concluiremos que la variable independiente está relacionada con al menos una de las variables independientes.

PRUEBAS SOBRE COEFICIENTES INDIVIDUALES

En la prueba de significancia determinamos si existe o no relación entre la variable dependiente y las variables independientes en conjunto, es decir, no se puede determinar la relación entre Y y cada una de las variables independientes.

Se pueden realizar pruebas individuales para analizar la relación entre la variable dependiente y cada una de las variables independientes.

Partimos de las hipótesis siguientes:

para j = 1, 2, ..., k

El estadístico de prueba apropiado es:

Donde es el valor de la diagonal principal de la matriz inversa ( (X´X)-1 ):

![Page 16: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/16.jpg)

El estadístico de prueba t0 anterior sigue una distribución t-student con v = n – p grados de libertad.

Entonces, si el valor absoluto del estadístico de prueba es mayor que el valor de tablas t /2, n – p, se rechaza la hipótesis nula. Como conclusión diremos que la variable independiente Y sí está relacionada con la variable independiente Xj.

CONCLUSION

Como ya vimos en los temas anteriores son muy importantes ya que podemos ver los tipos de regresiones y

para que nos sirven ya que son una herramienta que hoy en día necesitamos para resolver cualquier

problema también debemos de saber los conceptos de regresiones.

Dentro de estos análisis encontramos diagramas de dispersión, también debemos de saber para que nos

sirven las pruebas de hipótesis y donde debemos de aplicarla estos análisis de regresión tanto como la

prueba de hipótesis debemos aplicarla para cada problema y darle solución como dice la palabra hay una

hipótesis y esa hipótesis debemos de resolverla como vimos estos temas son de muy gran importancia para

cada uno de nosotros en nuestra vida laboral.

![Page 17: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/17.jpg)

![Page 18: REGRESIÓN..[1] faltamnte](https://reader036.fdocuments.es/reader036/viewer/2022083012/563dba21550346aa9aa2fc0c/html5/thumbnails/18.jpg)