Resumen_I..

-

Upload

kevin-batz -

Category

Documents

-

view

29 -

download

4

Transcript of Resumen_I..

PSGT 08 Introducción Básica a I.T

1

Distribuidora Electrónica S.A. Exposición Técnica/Capacitación

Introducción Básica a I.T.

Autores: David Quinto

Michael Miranda Stuardo Sagastume

Willmar Tecun Edy Arevalo Esdras Sales

Practicantes PSGT 08

Guatemala, 07-05-2008

PSGT 08 Introducción Básica a I.T

2

\ÇàÜÉwâvv|™Ç Las TIC se encargan del diseño, desarrollo, fomento, mantenimiento y administración de la información por medio de sistemas informáticos y de comunicación. Esto incluye todos los sistemas informáticos no solamente las computadoras, éstas son sólo un medio más, el más versátil, pero no el único; también las redes de telecomunicaciones, telemática, los teléfonos celulares, la televisión, la radio, los periódicos digitales, faxes, dispositivos portátiles, etc. Todas esas herramientas electrónicas de primera mano son de carácter determinante en la vida de todo profesional, sobre todo en el docente pues es él, el que se encargará de difundir la importancia de esta nueva tecnología. Las TIC se conciben como el universo de dos conjuntos, representados por las tradicionales Tecnologías de la Comunicación (TC) - constituidas principalmente por la radio, la televisión y la telefonía convencional - y por las Tecnologías de la información (TI) caracterizadas por la digitalización de las tecnologías de registros de contenidos (informática, de las comunicaciones, telemática y de las interfaces)”.

PSGT 08 Introducción Básica a I.T

3

gxvÇÉÄÉz•tá wx Ät \ÇyÉÜÅtv|™Ç EL COMPUTADOR

El procesador (también llamado Unidad central de procesamiento o CPU) consta de:

Un típico símbolo esquemático para una ALU: A y B son operandos; R es la salida; F es la entrada de la unidad de control; D es un estado de la salida

• La unidad lógica y aritmética o ALU es el dispositivo diseñado y construido para llevar a cabo las operaciones elementales como las operaciones aritméticas (suma, resta), operaciones lógicas (Y, O, NO), y operaciones de comparación o relacionales. En esta unidad es en donde se hace todo el trabajo computacional.

• La unidad de control sigue la dirección de las posiciones en memoria que contienen la instrucción que el computador va a realizar en ese momento; recupera la información poniéndola en la ALU para la operación que debe desarrollar. Transfiere luego el resultado a ubicaciones apropiadas en la memoria. Una vez que ocurre lo anterior, la unidad de control va a la siguiente instrucción (normalmente situada en la siguiente posición, a menos que la instrucción sea una instrucción de salto, informando al ordenador de que la próxima instrucción estará ubicada en otra posición de la memoria).

• Los dispositivos E/S sirven a la computadora para obtener información del mundo exterior y/o comunicar los resultados generados por el computador al exterior. Hay una gama muy extensa de dispositivos E/S como teclados, monitores, unidades de disco flexible o cámaras web.

UCP (UNIDAD CENTRAL DE PROCESAMIENTO)

Los datos en la memoria central se pueden leer (recuperar ) , o escribir.

1. Dirige y controla el proceso de información. 2. Procesa y manipula la información almacenada en la memoria 3. Recupera la información de la memoria: datos o instrucciones 4. almacena los resultados de los procesos en memoria

PSGT 08 Introducción Básica a I.T

4

� Un ordenador es una máquina capaz de ejecutar programas formados

por instrucciones. � El procesador lee una a una las instrucciones de memoria y las ejecuta. � El procesador lee las instrucciones y lee o escribe los datos de la

memoria. � La CPU se compone de UC, ALU y registros.

UNIDAD DE CONTROL

1. Coordina las actividades 2. Determina, ordena y sincroniza los procesos que realiza la computadora.

� Unidad encargada de leer instrucciones de memoria, interpretarlas

controlando el funcionamiento de las otras unidades. � Secuencia:

� Toma instrucción indicada por el PC � La decodifica y toma los operandos � La ejecuta

� Utiliza para ello el PC, la instrucción leída, el registro de estado y un reloj interno.

CPU

Memoria

Instrucciones

Datos

UC

Relo

ALU

Registros

PC

Instrucciones

Datos

Memoria

PSGT 08 Introducción Básica a I.T

5

UNIDAD ARITMÉTICO-LÓGICA

1. Realiza las operaciones aritméticas y Lógicas . � Unidad encargada de realizar las operaciones aritméticas y lógicas. � Opera con datos de los registros y el resultado va a otro registro. � La UC controla la ALU. � Se realizan operaciones muy simples. � Se modifica el registro de estado.

LA MEMORIA

� Una memoria es un dispositivo capaz de almacenar información. � Operaciones:

� Escritura: Introducir información en una posición determinada de la memoria

� Lectura: Obtener información existente en una posición determinada de la memoria

� Palabra de memoria � Unidad de almacenamiento típica. Contienen números binarios. � La capacidad es el número de palabras: C � El tamaño el número de bytes.

� Direcciones de memoria � Cada palabra se identifica por un número que llamamos dirección. � El tamaño de las direcciones el número de bits de las

direcciones:B � El espacio direccionable es D=2B. Se ha de cumplir D>=C.

Registros

Estado

ALU

Operandos

Resultado

PSGT 08 Introducción Básica a I.T

6

ENTRADA-PROCESO-SALIDA

BLOQUES DE UN COMPUTADOR

El mapa conceptual muestra, en forma básica, como funciona el flujo de los datos en una computadora, para luego convertirse en información útil para el usuario. Podemos notar que los datos comúnmente fluyen según esta secuencia. Existe también la entrada de datos directamente a la RAM, sin la intervención previa del microprocesador; este modo de acceso se denomina acceso directo a memoria. La memoria RAM está en constante comunicación con el microprocesador (en el diagrama, procesamiento), de forma mucho más rápida que cualquier otro dispositivo de almacenamiento. Finalmente la información

Unidades de Entrada(Teclado, Mouse, Scanner)

Unidades de Salida(Monitor, Impresora,

Parlantes)

Memoria Interna

Unidad AritméticoLógica

Unidad de Control

Unidad Central de Proceso

PSGT 08 Introducción Básica a I.T

7

(los datos procesados) es almacenada en algún disco, o bien, sale directamente de forma analógica o digital de la computadora, ya sea hacia el monitor, los altavoces la impresora o cualquier otro dispositivo que reciba y proyecte la información. ESQUEMA DE UN COMPUTADOR

1: Monitor 2: Placa base 3: Procesador 4: Puertos ATA 5: Memoria principal (RAM) 6: Placas de expansión 7: Fuente eléctrica 8: Unidad de almacenamiento óptico 9: Disco duro 10: Teclado 11: Mouse DISPOSITIVOS DE ENTRADA

Tipos de Mouse: Mecánico: es una unidad de ingreso de datos equipada con uno o más botones y una pequeña esfera en su parte inferior, del tamaño de una mano y

PSGT 08 Introducción Básica a I.T

8

diseñado para trabajar sobre una tabla o mouse-pad ubicada al lado del teclado. Al mover el mouse la esfera rueda y un censor activa la acción. Óptico: es el que emplea la luz para obtener sus coordenadas y se desplaza sobre una tabla que contiene una rejilla reflectante, colocada sobre el escritorio. Mecánicos: Son los más utilizados por su sencillez y bajo coste. Se basan en una bola de silicona que gira en la parte inferior del ratón a medida que desplazábamos éste. Dicha bola hace contacto con dos rodillos, uno perpendicular al ratón y otro transversal, de forma que uno recoge los movimientos de la bola en sentido horizontal y el otro en sentido vertical Los ratones opto-mecánicos trabajan según el mismo principio que los mecánicos, pero aquí los cilindros están conectados a codificadores ópticos que emplean pulsos luminosos al ordenador, en lugar de señales eléctricas. El modo de capturar el movimiento es distinto. Los tradicionales rodillos que giran una rueda radiada ahora pueden girar una rueda ranurada, de forma que un haz de luz las atraviesa. De esta forma, el corte intermitente del haz de luz por la rueda es recogido en el otro lado por una célula fotoeléctrica que decide hacia donde gira el ratón y a que velocidad. Los ratones ópticos carecen de bola y rodillos, y poseen unos foto-sensores o sensores ópticos que detectan los cambios en los patrones de la superficie por la que se mueve el ratón. Antiguamente, estos ratones necesitaban una alfombrilla especial, pero actualmente no. Microsoft ha denominado a este sistema IntelliEye en su ratón IntelliMouse y es capaz de explorar el escritorio 1500 veces por segundo, sobre multitud de superficies distintas como madera plástico o tela. La ventaja de estos ratones estriba en su precisión y en la carencia de partes móviles, aunque son lógicamente algo más caros que el resto. Funciones del teclado: - Teclado alfanumérico: es un conjunto de 62 teclas entre las que se encuentran las letras, números, símbolos ortográficos, Enter, alt...etc. - Teclado de Función: es un conjunto de 13 teclas entre las que se encuentran el ESC, tan utilizado en sistemas informáticos, más 12 teclas de función. Estas teclas suelen ser configurables pero por ejemplo existe un convenio para asignar la ayuda a F1. - Teclado Numérico: se suele encontrar a la derecha del teclado alfanumérico y consta de los números así como de un Enter y los operadores numéricos de suma, resta,... etc.

PSGT 08 Introducción Básica a I.T

9

- Teclado Especial: son las flechas de dirección y un conjunto de 9 teclas agrupadas en 2 grupos; uno de 6 (Inicio y fin entre otras) y otro de 3 con la tecla de impresión de pantalla entre ellas. Tipos de Teclado: De Membrana: Fueron los primeros que salieron y como su propio nombre indica presentan una membrana entre la tecla y el circuito que hace que la pulsación sea un poco más dura. Mecánico: Estos nuevos teclados presentan otro sistema que hace que la pulsación sea menos traumática y más suave para el usuario. Teclado para internet: El nuevo Internet Keyboard incorpora 10 nuevos botones de acceso directo, integrados en un teclado estándar de ergonómico diseño que incluye un apoya manos. Los nuevos botones permiten desde abrir nuestro explorador Internet hasta ojear el correo electrónico. El software incluido, IntelliType Pro, posibilita la personalización de los botones para que sea el teclado el que trabaje como nosotros queramos que lo haga. Teclados inalámbricos: Pueden fallar si están mal orientados, pero no existe diferencia con un teclado normal. En vez de enviar la señal mediante cable, lo hacen mediante infrarrojos, y la controladora no reside en el propio teclado, sino en el receptor que se conecta al conector de teclado en el PC. Si queremos conectar a nuestro equipo un teclado USB, primero debemos tener una BIOS que lo soporte y en segundo lugar debemos tener instalado el sistema operativo con el "Suplemento USB". Un buen teclado USB debe tener en su parte posterior al menos un conector USB adicional para poderlo aprovechar como HUB y poder conectar a él otros dispositivos USB como ratones, altavoces, etc

Tipos de Escáner: Flatbed: significa que el dispositivo de barrido se desplaza a lo largo de un documento fijo. En este tipo de escáneres, como las fotocopiadoras de oficina, los objetos se colocan boca abajo sobre una superficie lisa de cristal y son barridos por un mecanismo que pasa por debajo de ellos. Otro tipo de escáner flatbed utiliza un elemento de barrido instalado en una carcasa fija encima del documento. Escáner de mano: también llamado hand-held, porque el usuario sujeta el escáner con la mano y lo desplaza sobre el documento. Estos escáneres tienen la ventaja de ser relativamente baratos, pero resultan algo limitados porque no pueden leer documentos con una anchura mayor a 12 o 15 centímetros. Lector de código de barras: dispositivo que mediante un haz de láser lee dibujos formados por barras y espacios paralelos, que codifica información mediante anchuras relativas de estos elementos. Los códigos de barras

PSGT 08 Introducción Básica a I.T

10

representan datos en una forma legible por el ordenador, y son uno de los medios más eficientes para la captación automática de datos. Tipos de Cámaras: Cámara de fotos digital: Toma fotos con calidad digital, casi todas incorporan una pantalla LCD (Liquid Cristal Display) donde se puede visualizar la imagen obtenida. Tiene una pequeña memoria donde almacena fotos para después transmitirlas a un ordenador. Cámara de video: Graba videos como si de una cámara normal se tratara, pero las ventajas que ofrece en estar en formato digital, que es mucho mejor la imagen, tiene una pantalla LCD por la que ves simultáneamente la imagen mientras grabas. Se conecta al PC y este recoge el video que has grabado, para poder retocarlo posteriormente con el software adecuado. Lápiz Óptico: Dispositivo señalador que permite sostener sobre la pantalla (fotosensible) un lápiz que está conectado al ordenador con un mecanismo de resorte en la punta o en un botón lateral, mediante el cual se puede seleccionar información visualizada en la pantalla. Cuando se dispone de información desplegada, con el lápiz óptico se puede escoger una opción entre las diferentes alternativas, presionándolo sobre la ventana respectiva o presionando el botón lateral, permitiendo de ese modo que se proyecte un rayo láser desde el lápiz hacia la pantalla fotosensible. MICRÓFONOS Los micrófonos son los transductores* encargados de transformar energía acústica en energía eléctrica, permitiendo, por lo tanto el registro, almacenamiento, transmisión y procesamiento electrónico de las señales de

PSGT 08 Introducción Básica a I.T

11

audio. Son dispositivos duales de los altoparlantes, constituyendo ambos transductores los elementos mas significativos en cuanto a las características sonoras que sobre imponen a las señales de audio. No existe el micrófono ideal, debido a la sencilla razón que no se tiene un solo ambiente acústico o un solo tipo de música. Es por ello que, el ingeniero de sonido tiene a su disposición una amplia gama de micrófonos, cada uno de los cuales sirve para ciertos casos particulares. Existen los llamados micrófonos de diadema que son aquellos, que, como su nombre lo indica, se adhieren a la cabeza como una diadema cualquiera, lo que permite al usuario mayor comodidad ya no necesita sostenerlo con las manos, lo que le permite realizar otras actividades.

DISPOSITIVOS DE SALIDA

Impresoras de impacto (matriciales) Fueron las primeras que surgieron en el mercado. Se las denomina "de impacto" porque imprimen mediante el impacto de unas pequeñas piezas (la matriz de impresión) sobre una cinta impregnada en tinta, la cual suele ser fuente de muchos problemas si su calidad no es la que sería deseable. Impresoras de tinta Por supuesto, las impresoras matriciales utilizan tinta, pero cuando nos referimos a impresora de tinta nos solemos referir a aquéllas en las que la tinta se encuentra en forma más o menos líquida, no impregnando una cinta como en las matriciales. La tinta suele ser impulsada hacia el papel por unos mecanismos que se denominan inyectores, mediante la aplicación de una carga eléctrica que hace saltar una minúscula gota de tinta por cada inyector, sin necesidad de impacto. De todas formas, los entresijos últimos de este proceso varían de una a otra marca de impresoras (por ejemplo, Canon emplea en exclusiva lo que denomina "inyección por burbuja") y no son realmente significativos a la hora de adquirir una u otra impresora. Impresora laser. El único problema de importancia de las impresoras láser es que sólo imprimen en blanco y negro. En realidad, sí existen impresoras láser de color, que dan unos resultados bastante buenos, pero su precio es absolutamente desorbitado. Los láser son muy resistentes, mucho más rápidas y mucho más silenciosas que las impresoras matriciales o de tinta, y aunque la inversión inicial en una láser es mayor que en una de las otras, el tóner sale más barato a la larga que los cartuchos de tinta, por lo que a la larga se recupera la inversión. Por todo

PSGT 08 Introducción Básica a I.T

12

ello, los láser son idóneas para entornos de oficina con una intensa actividad de impresión, donde son más importantes la velocidad, la calidad y el escaso coste de mantenimiento que el color o la inversión inicial. Impresoras para fotos Constituyen una categoría de reciente aparición; usan métodos avanzados como la sublimación o las ceras o tintas sólidas, que garantizan una pureza de color excepcional, si bien con un coste relativamente elevado en cuanto a consumibles y una velocidad baja. Impresoras de gran formato Resulta un calificativo tan bueno como cualquier otro para definir a las impresoras, casi exclusivamente de tinta, que imprimen en formatos hasta el A2 (42x59,4 cm). Son impresoras que asocian las ventajas de las impresoras de tinta en cuanto a velocidad, color y resolución aceptables junto a un precio bastante ajustado. Impresoras para grupos Son impresoras de gran capacidad, preparadas para funcionar en una red incluso sin depender de un ordenador de la misma. Suelen ser impresoras láser, en ocasiones con soporte para color, con bandejas para 500 hojas o más, velocidades de más de 12 ppm (reales!!) y memoria por encima de 6 MB. Últimamente se tiende a que tengan funciones de fotocopiadora o capacidad para realizar pequeñas tiradas sin necesidad de emplear una fotocopiadora, e incluso clasifican y encuadernan. Plóters. Un plóter es un dispositivo que conectado a una computadora puede dibujar sobre papel cualquier tipo de gráfico mediante el trazado de líneas gracias a las plumillas retraibles de las que dispone. La limitación fundamental respecto a una impresora está en la menor velocidad del plóter y en lo limitado de los colores que puede ofrecer, que se ven limitados por el número de plumillas, bien es cierto que se pueden crear mezclando puntos de distintas plumillas, pero el proceso alargaría aún más la obtención de resultados. HPGL es un conjunto de comandos en el ROM de plóters de pluma para reducir el trabajo requerido por los programadores de las aplicaciones que ejecutan salida en ploteo. HPGL usa dos cartas de nemotécnica como instrucciones para dibujar líneas, círculos, texto y símbolos simples. Existe una desventaja primaria: HPGL es más abultado que otros lenguajes de ploteo lo cual significa que toma más tiempo transmitir un archivo HPGL que en cualquier otro.

PSGT 08 Introducción Básica a I.T

13

Según la forma en que se realiza el dibujo, los plóters se pueden clasificar en tres tipos: Pluma. Electrostáticos. Inyección Plóters de pluma Los primeros plóters, aún en pleno uso, fueron los de plumillas. Son los que más tardan en realizar un dibujo complejo, pero también son los que ofrecen una calidad y suavidad en las curvas absolutamente perfectas. Normalmente disponen de un soporte para seis u ocho plumillas, del cual el cabezal de dibujo las irá tomando según las necesite. Plóters electrostáticos Otro tipo de plóters son los plóters electrostáticos, térmicos o láser. Suelen ser más caros que cualquier otro tipo de trazador y aunque con tecnologías distintas entre sí, todos ellos ofrecen una calidad de dibujo similar. Casi ninguno de ellos dibuja en color, y la calidad del resultado final se asemeja mucho a la impresión de un fax, aunque el tamaño del punto es menor y el trazado resiste mejor el paso del tiempo y la acción de la luz. Inyección de tinta. Un tipo de trazador que está teniendo mucho éxito en los últimos años es el de chorro de tinta. Realmente es una impresora de chorro de tinta de gran formato, y la mayoría de ellos pueden producir impresiones con 16.7 millones de colores. Se les puede llamar plóters, porque son capaces de entender las instrucciones de lenguajes específicos de los plóters (HP-GL, RD-GL, DMPL, etc.), aunque internamente tienen que realizar la conversión de formato vectorial (líneas) a formato ráster (puntos de color). Un plóter de corte es básicamente igual que uno de dibujo. La diferencia estriba en que además de dibujar esta diseñado principalmente para cortar vinilo adhesivo, que es el que utilizan los profesionales de la rotulación para decorar y rotular vehículos, luminosos, o escaparates. Algunos pueden cortar también materiales más gruesos, como cartulina, cartón, etc. Bocinas:

PSGT 08 Introducción Básica a I.T

14

Algunas bocinas son de mesas, similares a la de cualquier aparato de sonidos y otras son portátiles (audífonos). Existen modelos muy variados, de acuerdo a su diseño y la capacidad en watts que poseen. Tarjeta de sonido. La tarjeta de sonido es la encargada de convertir la información digital procesada por nuestro equipo (1s y 0s) en datos analógicos, o sonidos, para que sean reproducidos por unos altavoces conectados a la propia tarjeta de sonido. Dispositivos por los cuales se emiten sonidos procedentes de la tarjeta de sonido. Actualmente existen bastantes ejemplares que cubren la oferta más común que existe en el mercado. Se trata de modelos que van desde lo más sencillo (una pareja de altavoces estéreo), hasta el más complicado sistema de Dolby Digital, con nada menos que seis altavoces, pasando por productos intermedios de 4 o 5 altavoces.

La gran mayoría de las tarjetas de sonido incluyen un amplificador interno de 4W por canal, lo que nos permite conectar a la salida "speakers" de la tarjeta unos altavoces sencillos como los utilizados en el walkman.

AURICULARES Son dispositivos colocados en el oído para poder escuchar lo que la tarjeta de sonido envía. Presentan la ventaja de que no pueden ser escuchados por otra persona, solo la que los utiliza. Equipos empleados para audición. Los audífonos son el equipo básico empleado para escuchar los sonidos propios de un ambiente virtual: Audífonos convencionales Son los audífonos de uso más corriente, a través de estos se escucha el sonido simulado de los objetos sin identificar auditivamente el punto de ubicación de los mismos. Convolvotrón Estos audífonos además de simular el sonido propio de los objetos, simulan la ubicación de los mismos dentro del ambiente virtual.

PSGT 08 Introducción Básica a I.T

15

Fax: Dispositivo mediante el cual se imprime una copia de otro impreso, transmitida o bien, vía teléfono, o bien desde el propio fax. Se utiliza para ello un rollo de papel que cuando acaba la impresión se corta. MONITOR: El monitor o pantalla de computadora, es un dispositivo de salida que, mediante una interfaz, muestra los resultados del procesamiento de una computadora. DISPOSITIVOS DE ENTRDA Y SALIDA

Disco Flexible (Floppy Disk) Es un dispositivo de almacenamiento de información de acceso directo, que consiste en un disco de material flexible llamado `Mylar´ recubierto de un material magnético y con el mismo sistema de grabación y lectura que un disco duro. Este disco flexible, también conocido como `floppy disk´ esta protegido por una funda de plástico en la que aparecen tres ventanas: una para el arrastre del disco, otra para la sincronía y una última para la lectura y grabación de la información. También, posee una o más aberturas para protección contra escritura y borrado o para definir la densidad de grabación, y una etiqueta donde se representa alguna identificación de la información contenida en el disco.

PSGT 08 Introducción Básica a I.T

16

El proceso de preparar los discos flexibles para guardar información, se conoce como formatear. Y consiste en organizar la superficie del disco en pistas y sectores, actualmente la mayoría de los discos flexibles disponibles en el mercado ya vienen formateados de fábrica por lo que no es necesario formatearlos sino que vienen listos para usarse. Pantalla táctil Una pantalla táctil (touchscreen en inglés) es una pantalla que mediante un contacto directo sobre su superficie permite la entrada de datos y órdenes al dispositivo. A su vez, actúa como periférico de salida, mostrando los resultados introducidos previamente. Este contacto también se puede realizar con lápiz u otras herramientas similares. Actualmente hay pantallas táctiles que pueden instalarse sobre una pantalla normal. Así pues, la pantalla táctil puede actuar como periférico de entrada y periférico de salida de datos. Comunicación inalámbrica La comunicación inalámbrica (inglés wireless, sin cables) es el tipo de comunicación en la que no se utiliza un medio de propagación físico alguno esto quiere decir que se utiliza la modulación de ondas electromagnéticas, las cuales se propagan por el espacio sin un medio físico que comunique cada uno de los extremos de la transmisión. En ese sentido, los dispositivos físicos sólo están presentes en los emisores y receptores de la señal, como por ejemplo: Antenas, Laptops, PDAs, Teléfonos Celulares, etc.

PSGT 08 Introducción Básica a I.T

17

Bluetooth: es una especificación industrial para Redes Inalámbricas de Área Personal (WPANs) que posibilita la transmisión de voz y datos entre diferentes dispositivos mediante un enlace por radiofrecuencia segura y globalmente libre (2,4 GHz.). Los principales objetivos que se pretende conseguir con esta norma son: Facilitar las comunicaciones entre equipos móviles y fijos. Eliminar cables y conectores entre éstos. Ofrecer la posibilidad de crear pequeñas redes inalámbricas y facilitar la sincronización de datos entre nuestros equipos personales. Los dispositivos que con mayor intensidad utilizan esta tecnología son los de los sectores de las telecomunicaciones y la informática personal, como PDAs, teléfonos móviles, computadoras portátiles, ordenadores personales, impresoras y cámaras digitales. Bluetooth se utiliza principalmente en un gran número de productos tales como teléfonos, impresoras, módems y auriculares. Su uso es adecuado cuando puede haber dos o más dispositivos en un área reducida sin grandes necesidades de ancho de banda. Su uso más común está integrado en teléfonos y PDA's, bien por medio de unos auriculares Bluetooth o en transferencia de ficheros. Bluetooth tiene la ventaja de simplificar el descubrimiento y configuración de los dispositivos, ya que éstos pueden indicar a otros los servicios que ofrecen, lo que redunda en la accesibilidad de los mismos sin un control explícito de direcciones de red, permisos y otros aspectos típicos de redes tradicionales.

MICROPROCESADOR

El microprocesador es un circuito integrado que contiene todos los elementos necesarios para conformar una "unidad central de procesamiento", también es conocido como CPU (por sus siglas en inglés: Central Process Unit). En la actualidad este componente electrónico está compuesto por millones de transistores, integrados en una misma placa de silicio. Suelen tener forma de prisma chato, y se instalan sobre un elemento llamado zócalo (en inglés, socket). También, en modelos antiguos solía soldarse directamente a la placa madre (motherboard). Aparecieron algunos modelos donde se adoptó el formato de cartucho, sin embargo no tuvo mucho éxito. Actualmente se dispone de un zócalo especial para alojar el microprocesador y el sistema de enfriamiento, que comúnmente es un disipador de aluminio con un ventilador adosado (conocido como microcooler). Desde el punto de vista lógico y funcional, el microprocesador está compuesto básicamente por: varios

PSGT 08 Introducción Básica a I.T

18

registros; una Unidad de control, una Unidad aritmético-lógica; y dependiendo del procesador, puede contener una unidad en coma flotante. HISTORIA DEL MICROPROCESADOR

o La Evolución del Microprocesador.

El microprocesador es un producto de la computadora y con tecnología semiconductora. Se eslabona desde la mitad de los años 50's; estas tecnologías se fusionaron a principios de los años 70`'s, produciendo el llamado microprocesador.

La computadora digital hace cálculos bajo el control de un programa. La manera general en que los cálculos se han hecho es llamada la arquitectura de la computadora digital. Así mismo la historia de circuitos de estado sólido nos ayuda también, porque el microprocesador es un circuito con transistores o microcircuito LSI (grande escala de integración), para ser más preciso.

El mapa de la figura, mostrada al final de esta sección, muestra los sucesos importantes de éstas dos tecnologías que se desarrollaron en las últimas cinco décadas. Las dos tecnologías iniciaron su desarrollo desde la segunda guerra mundial; en este tiempo los científicos desarrollaron computadoras especialmente para uso militar. Después de la guerra, a mediados del año de 1940 la computadora digital fue desarrollada para propósitos científicos y civiles.

La tecnología de circuitos electrónicos avanzó y los científicos hicieron grandes progresos en el diseño de dispositivos físicos de Estado Sólido. En 1948 en los laboratorios Bell crearon el Transistor.

En los años 50's, aparecen las primeras computadoras digitales de propósito general. Éstas usaban tubos al vacío (bulbos) como componentes electrónicos activos. Tarjetas o módulos de tubos al vacío fueron usados para construir circuitos lógicos básicos tales como compuertas lógicas y flip-flops (Celda donde se almacena un bit). Ensamblando compuertas y flip-flops en módulos, los científicos construyeron la computadora ( la lógica de control, circuitos de memoria, etc.). Los bulbos también formaron parte de la construcción de máquinas para la comunicación con las computadoras. Para el estudio de los circuitos digitales, en la construcción de un circuito sumador simple se requiere de algunas compuertas lógicas.

La construcción de una computadora digital requiere de muchos circuitos o dispositivos electrónicos. El principal paso tomado en la computadora fue hacer que el dato fuera almacenado en memoria como una forma de palabra digital. La idea de almacenar programas fue muy importante.

PSGT 08 Introducción Básica a I.T

19

La tecnología de los circuitos de estado sólido evolucionó en la década de los años 50's. El uso del material silicio de bajo costo y con métodos de producción masiva, hicieron al transistor ser el más usado para el diseño de circuitos. Por lo tanto el diseño de la computadora digital fue un gran avance del cambio para remplazar al tubo al vacío (bulbo) por el transistor a finales de los años 50's. A principios de los años 60's, el arte de la construcción de computadoras de estado sólido se incrementó y surgieron las tecnologías en circuitos digitales como: RTL (Lógica Transistor Resistor), DTL (Lógica Transistor Diodo), TTL (Lógica Transistor Transistor), ECL (Lógica Complementada Emisor). A mediados de los años 60's se producen las familias de lógica digital, dispositivos en escala SSI y MSI que corresponden a pequeña y mediana escala de integración de componentes en los circuitos de fabricación. A finales de los años 60's y principios de los años 70's surgieron los LSI (gran escala de integración ). La tecnología LSI fue haciendo posible más y más circuitos digitales en un circuito integrado. Pero pocos circuitos LSI fueron producidos, los dispositivos de memoria fueron un buen ejemplo. Las primeras calculadoras electrónicas requerían de 75 a 100 circuitos integrados. Después se dio un paso importante en la reducción de la arquitectura de la computadora a un circuito integrado simple, resultando un circuito que fue llamado el microprocesador. El primer microprocesador fue el Intel 4004, producido en 1971. Se desarrolló originalmente para una calculadora, y resultaba revolucionario para su época. Contenía 2.300 transistores en un microprocesador de 4 bits que sólo podía realizar 60.000 operaciones por segundo. El primer microprocesador de 8 bits fue el Intel 8008, desarrollado en 1979 para su empleo en terminales informáticos. El Intel 8008 contenía 3.300 transistores. El primer microprocesador realmente diseñado para uso general, desarrollado en 1974, fue el Intel 8080 de 8 bits, que contenía 4.500 transistores y podía ejecutar 200.000 instrucciones por segundo. Los microprocesadores modernos tienen

PSGT 08 Introducción Básica a I.T

20

una capacidad y velocidad mucho mayores. Entre ellos figuran el Intel Pentium Pro, con 5,5 millones de transistores; el UltraSparc-II, de Sun Microsystems, que contiene 5,4 millones de transistores; el PowerPC 620, desarrollado conjuntamente por Apple, IBM y Motorola, con 7 millones de transistores, y el Alpha 21164A, de Digital Equipment Corporation, con 9,3 millones de transistores.

FUNCIONAMIENTO

El microprocesador ejecuta instrucciones almacenadas como números binarios organizados secuencialmente en la memoria principal. La ejecución de las instrucciones se puede realizar en varias fases:

• PreFetch, Pre lectura de la instrucción desde la memoria principal, • Fetch, envío de la instrucción al decodificador, • Decodificación de la instrucción, es decir, determinar qué instrucción es

y por tanto qué se debe hacer, • Lectura de operandos (si los hay), • Ejecución,(Lanzamiento de las Máquinas de estado que llevan a cabo el

procesamiento). • Escritura de los resultados en la memoria principal o en los registros.

Cada una de estas fases se realiza en uno o varios ciclos de CPU, dependiendo de la estructura del procesador, y concretamente de su grado de segmentación. La duración de estos ciclos viene determinada por la frecuencia de reloj, y nunca podrá ser inferior al tiempo requerido para realizar la tarea individual (realizada en un solo ciclo) de mayor coste temporal. El microprocesador se conecta a un oscilador, normalmente un cristal de cuarzo capaz de generar pulsos a un ritmo constante, de modo que genera varios ciclos (o pulsos) en un segundo.

PROCESADORES DEL PRESENTE

Procesadores Intel Core™2 Duo

Características y beneficios Ofrece un desempeño general óptimo y excepcional. Ahora podrá obtener lo mejor de lo mejor con los procesadores Intel Core 2 Duo más recientes, que se han diseñado con la tecnología de 45 nm de Intel y circuitos infundidos por hafnio a fin de proporcionarle las más modernas tecnologías de alto desempeño.

PSGT 08 Introducción Básica a I.T

21

Estos increíbles procesadores nuevos incluyen hasta 6 MB de caché L2 compartida, un bus frontal de hasta 1333 MHz para equipos de desktop y un bus frontal de hasta 800 MHz para equipos portátiles. Por lo tanto, usted tiene el futuro de la computación en sus manos hoy mismo y como sólo Intel puede ofrecerlo: Ejecución dinámica ampliada Intel®, que permite proporcionar una mayor cantidad de instrucciones por ciclo de reloj a fin de mejorar el tiempo de ejecución y la eficiencia en el consumo de energía. Función Intel® para gestión inteligente de la energía, que, por sus características de diseño, incrementa la eficiencia en el consumo de energía y la duración de la batería de su equipo portátil. Acceso Intel® a memoria inteligente, que mejora el desempeño del sistema mediante la optimización del uso del ancho de banda de datos disponible. Caché Intel® inteligente avanzada, que proporciona un subsistema de caché con un desempeño más elevado y una mayor eficiencia. Viene optimizada para procesadores multi-core y dual-core. Intel® Advanced Digital Media Boost, que acelera una amplia gama de aplicaciones, tales como video, voz e imagen, procesamiento de fotografías, cifrado, aplicaciones financieras, técnicas y científicas. Ahora mejorados en las versiones de 45 nm con Intel® HD Boost que utilizan las nuevas instrucciones SSE4 para aumentar aún más el desempeño en aplicaciones de multimedia.

El microprocesador Core 2 DuoCore 2 DuoCore 2 DuoCore 2 Duo de Intel es la continuación de los Pentium D y Core Duo. Su distribución comenzó el 27 de julio de 2006.

PSGT 08 Introducción Básica a I.T

22

El Core 2 Duo es un procesador con un pipeline de 14 etapas lo que le permite escalar más en frecuencia que su antecesor directo: el Core 1, que tenía 12 etapas al igual que el Athlon 64. Tiene, además, un motor de ejecución ancho con tres ALUs, cuatro FPUs, y tres unidades de SSE de 128 bits. Estas dos características hacen que sea el procesador x86 que más instrucciones por ciclo puede lograr.

Entre otras características destacan arquitectura de 64 bits EM64T (no disponible en su predecesor Core Duo), Virtualization Technology, LaGrande Technology, Intel Enhanced SpeedStep Technology, Active Management Technology (iAMT2), MMX, SSE, SSE2, SSE3, SSSE3, y XD bit.

Existen versiones de sobremesa y para portátiles, a diferencia de la división existente desde 2003 entre Pentium M para portátiles y Pentium 4 para ordenadores de sobremesa, unificando el nombre de Core 2 Duo para todas los procesadores de gama media dejando además el nombre Pentium, utilizado desde 1993, para los procesadores de gama baja (y menor rendimiento) basados en la arquitectura de Core 2 con un caché reducido llamado Pentium Dual Core, quienes a su vez vienen a reemplazar a la familia Celeron en este rol.

Una llamativa característica de esta familia es su particular facilidad para aplicar overclock, llegando muchos de estos procesadores a ganancias superiores al 50% en su frecuencia de trabajo

Otra diferencia es la forma como trabajan sus núcleos: en el dual core sus núcleos trabajan de manera alterna, mientras que en el core 2 dúo sus núcleos trabajan de manera simultanea dando un mayor rendimiento.

Durante un tiempo se dijo que el core 2 dúo poseía 4 núcleos cosa que es errónea. Solo posee 2 pues es un tipo especial de dual core.

PSGT 08 Introducción Básica a I.T

23

Procesadores de escritorio

Core 2 Duo "Conroe" (dual core, 65 nm) (gama media) E6750 y E6850 Gama Alta

Los procesadores ConroeConroeConroeConroe están etiquetados como "E6x00" o "E6x20" o "E6x50" o "E65x0". Están destinados a ordenadores de sobremesa.

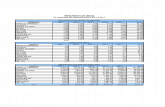

Nombre del modelo Frecuencia

Front Side Bus

Mult. Cache

L1 Cache

L2 TDP Socket Fecha de

salida

Core 2 Duo E6850

3,00 GHz 1333 MT/s

9 x 2×32 kb

4 Mb 65 W LGA 775

22/07/2007

Core 2 Duo E6750

2,66 GHz 1333 MT/s

8 x 2×32 kb

4 Mb 65 W LGA 775

22/07/2007

Core 2 Duo E6700

2,66 GHz 1066 MT/s

10 x 2×32 kb

4 Mb 65 W LGA 775

27/07/2006

Core 2 Duo E6600

2,40 GHz 1066 MT/s

9 x 2×32 kb

4 Mb 65 W LGA 775

27/07/2006

Core 2 Duo E6550

2,33 GHz 1333 MT/s

7 x 2×32 kb

4 Mb 65 W LGA 775

22/07/2007

Core 2 Duo E6540

2,33 GHz 1333 MT/s

7 x 2×32 kb

4 Mb 65 W LGA 775

22/07/2007

Core 2 Duo E6420

2,13 GHz 1066 MT/s

8 x 2×32 kb

4 Mb < 65 W

LGA 775

xx/xx/2007

Core 2 Duo E6320

1,86 GHz 1066 MT/s

7 x 2×32 kb

4 Mb < 65 W

LGA 775

xx/xx/2007

PSGT 08 Introducción Básica a I.T

24

Intel Core 2 Duo CPU

Intel Core 2 Duo E6600 "Conroe"

Producción: 2006 -

Fabricante: Intel

Velocidad de CPU: 1.60 GHz a 3.33 GHz

Velocidad de FSB: 667 MT/s a 1333 MT/s

Procesos: (Longitud de canal del MOSFET)

0.065 µm a 0.040 µm

Conjunto de instrucciones:

EM64T

Microarquitectura: Intel Core Microarchitecture

Sockets:

• Socket T • Socket M

Número de Cores: 1, 2, o 4 (2x2)

Cores:

• Conroe-L • Allendale • Conroe • Merom • Kentsfield • Yorkfield • Wolfdale

PSGT 08 Introducción Básica a I.T

25

Procesadores Intel Core™2 Quad

El procesador líder en desempeño, no busque más. Gracias a sus cuatro núcleos, el procesador Intel® Core™2 Quad permite ejecutar a gran velocidad tareas de alto nivel de procesamiento en exigentes entornos de multitarea y aprovecha al máximo las aplicaciones de varios subprocesos. Ya sea que esté creando multimedia, aniquilando a sus enemigos en un videojuego o ejecutando aplicaciones exigentes a la vez, el nuevo procesamiento quad-core cambiará la manera de hacer todo. Sea el primero en entrar en el nuevo mundo de quad-core y libere la potencia de la tecnología de varios subprocesos. Características y beneficios Alto nivel superado. Presentamos los nuevos miembros de la familia Core 2 Quad desarrollados con la tecnología de 45 nm de Intel y circuitos infundidos por hafnio. Estos nuevos procesadores proporcionan un sorprendente desempeño y una extraordinaria eficacia en el consumo de energía. Ya sea que se trate de codificar, presentar, editar o distribuir, saque el máximo provecho de sus aplicaciones multimedia profesionales con una PC equipada con el procesador Intel® Core™2 Quad. Con cuatro núcleos y hasta 12MB de caché L2 compartida y un bus frontal de hasta 1333 MHz, contará con una usina para multimedia en su casa y disfrutará de entretenimientos más intensos y de mayor capacidad multitarea.

PSGT 08 Introducción Básica a I.T

26

Ejecución dinámica ampliada Intel®, que permite proporcionar una mayor cantidad de instrucciones por ciclo de reloj a fin de mejorar el tiempo de ejecución y la eficacia en el consumo de energía. Función Intel® para gestión inteligente de la energía, que, por sus características de diseño, incrementa el desempeño con un consumo eficaz de energía. Acceso Intel® a memoria inteligente, que mejora el desempeño del sistema mediante la optimización del uso de todo el ancho de banda de datos disponible. Caché Intel® inteligente avanzada, que proporciona un subsistema de caché con un desempeño más elevado y una mayor eficacia. Viene optimizada para procesadores multi-core y dual-core. Intel® Advanced Digital Media Boost, que acelera una amplia gama de aplicaciones, tales como video, voz e imagen, procesamiento de fotografías, cifrado, aplicaciones financieras, técnicas y científicas. Ahora mejorados en las versiones de 45 nm con Intel® HD Boost que utilizan las nuevas instrucciones SSE4 para aumentar aún más el desempeño en aplicaciones de multimedia.

Permite ejecutar aplicaciones de varios subprocesos con simplicidad. Aproveche la creciente cantidad de programas de varios subprocesos con la tecnología quad-core de Intel. Con cuatro núcleos de procesamiento, una PC equipada con el procesador Intel Core 2 Quad permitirá disfrutar de entretenimientos más intensos y ejecutar más multitareas de medios como nunca antes.

PSGT 08 Introducción Básica a I.T

27

Intel Core 2 QuadIntel Core 2 QuadIntel Core 2 QuadIntel Core 2 Quad o Intel Quad CoreIntel Quad CoreIntel Quad CoreIntel Quad Core son una serie de procesadores de Intel con 4 núcleos y de 64 bits. Según el fabricante, estos procesadores son un 65% más rápidos que los Core 2 Duo. La realidad es que son dos procesadores Core 2 Duo encapsulados en un mismo zócalo, formando así los 4 núcleos reales.

Intel tiene en mente lanzar los procesadores de 4 núcleos para portátiles en el primer semestre de 2008, con el nombre de "Penryn" y será una actualización de los denominados Intel Santa Rosa que se utilizan actualmente.

Modelos

Tecnología de

fabricación

Nombre del

modelo Frecuencia

Front Side Bus

Mult. Cache

L0 Cache

L1 TDP Socket Fecha de

salida

45 nm Core 2 Quad Q9300

2.50 GHz 1333 MT/s

7.5 x 2×32 kb

6MB L2

105 - 95 W

LGA 775

01/02/2007

65 nm Core 2 Quad Q6600

2,40 GHz 1066 MT/s

9 x 2×32 kb

8 Mb 105 - 95 W

LGA 775

07/01/2007

65 nm Core 2 Quad Q6700

2,66 GHz 1066 MT/s

10 x 2×32 kb

8 Mb 95 W

LGA 775

22/07/2007

PSGT 08 Introducción Básica a I.T

28

Core 2™ Quad CPU

Producción: 2007

Fabricante: Intel

Velocidad de CPU: 2.40 GHz a 3.00 GHz

Velocidad de FSB: 1066 MT/s a 1333 MT/s

Procesos: (Longitud de canal del MOSFET)

0.065 µm

Conjunto de instrucciones:

EM64T

Microarquitectura: Intel Core Microarchitecture

Sockets:

• LGA 775 • Socket T

Cores:

• Kentsfield • Yorkfield

PSGT 08 Introducción Básica a I.T

29

Procesadores AMD Serie Phenom™

AMD PhenomAMD PhenomAMD PhenomAMD Phenom es la nueva familia de microprocesadores lanzada a mediados

de Noviembre del 2007 por AMD. Esta conformada por el Phenom (series FX), Phenom de cuádruple núcleo (series 9)y Phenom de triple núcleo (series 7). Esta familia también esta relacionada con los procesadores Athlon de doble

"Agena FX " (65 nm, quad core)

Todos los modelos soportan: MMX, SSE, SSE2, SSE3, SSE4a, Enhanced 3DNow!, NX bit, AMD64 (AMD's x86-64 implementation), Cool'n'Quiet

PSGT 08 Introducción Básica a I.T

30

Modelo Frecuencia L2-Cache

L3 cache

HT (por

dirección) Multiplicador Voltaje Socket Fecha de

Lanzamiento Numero(s)de

Parte

Phenom FX-911

2400-2600 MHz

4 x 512 KB

2 MB 1800 MHz

Socket F+

Q1 2008 ??

Phenom FX-901

2200-2400 MHz

4 x 512 KB

2 MB 1600 MHz

Socket F+

Q1 2008 ??

Phenom FX-8x2

TBD 4 x 512 KB

2 MB >=2000 MHz

Socket AM2+

Q2 2008 ??

Phenom FX-822

2600+ MHz

4 x 512 KB

2 MB 2000 MHz

Socket AM2+

Q1 2008 ??

Phenom quad-core 9-series

"Agena " (65 nm, quad core)

Todos los modelos soportan: MMX, SSE, SSE2, SSE3, SSE4a, Enhanced 3DNow!, NX bit, AMD64 (AMD's x86-64 implementation), Cool'n'Quiet

Modelo Frecuencia L2-

Cache L3

cache

HT (por

dirección) Multiplicador Voltaje Socket

Fecha de Lanzamiento

Numero(s)de Parte Precio de

Lanzamiento

Phenom 9xxx2

2xxx MHz 4 x 512 KB

2 MB >=2000 MHz

Socket AM2+

Q2 2008 ? ?

Phenom 99003 3

2600 MHz 4 x 512 KB

2 MB 2000 MHz

Socket AM2+

Q1 2008 ? ?

Phenom 97002 4

2400 MHz 4 x 512 KB

2 MB 2000 MHz

12x 1.2-1.25

Socket AM2+

Q1 2008 HD9700XAGDBOX ?

PSGT 08 Introducción Básica a I.T

31

Phenom 96002 4

2300 MHz 4 x 512 KB

2 MB 1800 MHz

11.5x 1.1-1.25

Socket AM2+

Noviembre 19 2007

HD9600WCGDBOX $283

Phenom 95002 4

2200 MHz 4 x 512 KB

2 MB 1800 MHz

11x 1.1-1.25

Socket AM2+

Noviembre 19 2007

HD9500WCGDBOX $251

Phenom triple-core 7-series

"Toliman " (65 nm, triple core)

Todos los modelos soportan: MMX, SSE, SSE2, SSE3, SSE4a, Enhanced 3DNow! NX bit, AMD64 (AMD's x86-64 implementation), Cool'n'Quiet

Modelo Frecuencia L2-Cache

L3 cache

HT (por

dirección) Multiplicador Voltaje Socket Fecha de

Lanzamiento Numero(s)de

Parte

Phenom 77005

2500 MHz 3 x 512 KB

2 MB TBD Socket AM2+

Marzo 2008 ??

Phenom 76005

2300 MHz 3 x 512 KB

2 MB TBD Socket AM2+

Marzo 2008 ??

Athlon de doble Núcleo (series 6)

Los microprocesadores Athlon de doble núcleo de serie 6 están basados en la familia Phenom en vez de estarlo en el original Athlon 64 que pertenece a la familia 0Fh de procesadores (K8).

PSGT 08 Introducción Básica a I.T

32

PhenomPhenomPhenomPhenom es el nombre que se le da a la nueva familia de procesadores de cuatro núcleos de AMD. Este nombre fue dado a conocer a finales de abril del 2007, reemplazando así a la serie de alto rendimiento de AMD.

Modelos

Código Frecuencia del Reloj (GHz)

Tamaño del L2 Caché (KB)

Tamaño del Caché L3 compartido (MB)

TDP (W)

Socket Núcleos Disponibilidad

AMD Phenom FX

2.4–2.6

2.2–2.4

AM2+

Agena FX

2.2–2.4

4x512 2 TBD

AM2+

4 Q3 2007

AMD Phenom X4

2.4

Agena

2.2

4x512 2 89 AM2+ 4 Q3 2007

AMD Phenom X2

2.8 89

2.6 Kuma

2.4

2x512 2

65

AM2+ 2 Q4 2007

PSGT 08 Introducción Básica a I.T

33

Características

Como característica común todos los Phenom tienen tecnología de 65 nanómetros y utilizarán el socket AM2+ (cuya principal novedad es la integración de la última versión de HyperTransport, la 3.0), excepto los Phenom FX que utilizarán el Socket F o el F+ (el mismo que algunos Opteron).

Salen junto con la nueva serie AMD DirectX 10 ATI Radeon HD 2000 (RV600). AMD espera la disponibilidad de los ordenadores de escritorio basadas en Phenom dual y quad-core para finales de 2007.

En San Francisco, la empresa mostró una plataforma de ocho núcleos, donde se pudo ver la primera plataforma de ocho núcleos de próxima generación de silicio. Ésta incluye dos procesadores Phenom de cuatro núcleos, la nueva DirectX 10 ATI Radeon HD 2900 XT y el chipset RD790 que será lanzado en la segunda mitad del año 2007.

PSGT 08 Introducción Básica a I.T

34

Los procesadores Phenom están diseñados para facilitar el uso inteligente de energía y recursos del sistema, listos para la virtualización, generando un óptimo rendimiento por watt.

Todos los procesadores Phenom poseerán características como controlador de memoria DDR2 integrado, tecnología HyperTransport y unidades de punto flotante de 128 bits, para incremento de la velocidad y rendimiento de los cálculos de punto flotante.

Con el diseño de cuatro núcleos real ofrecido por los procesadores Phenom, los núcleos se comunican dentro del mismo sustrato de silicio prescindiendo de un front side bus externo al procesador, lo que genera un cuello de botella en otros productos que unen dos chips de doble núcleo para conformar procesadores de cuatro núcleos.

La arquitectura Direct Connect asegura que los cuatro núcleos tengan un óptimo acceso al controlador integrado de memoria y la tecnología HyperTransport, de manera que las escalas de rendimiento mejoren con el número de núcleos.

PSGT 08 Introducción Básica a I.T

35

Tiene caché L3 compartida para un acceso más rápido de datos y compatibilidad de infraestructura del socket AM2, AM2+ y AM3 para permitir un camino de actualización sin sobresaltos.

Velocidad y Ancho de Banda Actualmente se habla de frecuencias de Gigaherzios (GHz.), o de Megaherzios (MHz.). Lo que supone miles de millones o millones, respectivamente, de ciclos por segundo. El indicador de la frecuencia de un microprocesador es un buen referente de la velocidad de proceso del mismo, pero no el único. La cantidad de instrucciones necesarias para llevar a cabo una tarea concreta, así como el ancho de banda ó cantidad de instrucciones ejecutadas por ciclo ICP, son los otros dos factores que determinan la velocidad de la CPU. La cantidad de instrucciones necesarias para realizar una tarea depende directamente del juego de instrucciones disponible, mientras que el índice ICP depende de varios factores, como el grado de supersegmentación y la cantidad de unidades de proceso o "pipelines" disponibles, entre otros. La cantidad de instrucciones necesarias para realizar una tarea depende directamente del juego de instrucciones.

Bus de datos El microprocesador lee y escribe datos en la memoria principal y en los dispositivos de entrada/salida. Estas transferencias se realizan a través de un conjunto de conductores que forman el bus de datos. El número de conductores suele ser potencia de 2. Hay buses de 4, 8, 16, 32, 64, ... conductores. Los modelos de la familia x86, a partir del 80386, trabajan con bus de datos de 32 bits, y a partir del Pentium con bus de 64 bits. Pero los

PSGT 08 Introducción Básica a I.T

36

microprocesadores de las tarjetas gráficas, que tienen un mayor volumen de procesamiento por segundo, se ven obligados a aumentar este tamaño, y así tenemos hoy en día microprocesadores gráficos que trabajan con datos de 128 ó 256 bits. Estos dos tipos de microprocesadores no son comparables, ya que ni su juego de instrucciones ni su tamaño de datos son parecidos y por tanto el rendimiento de ambos no es comparable en el mismo ámbito. La arquitectura x86 se ha ido ampliando a lo largo del tiempo a través de conjuntos de operaciones especializadas denominadas "extensiones", las cuales han permitido mejoras en el procesamiento de tipos de información específica. Este es el caso de las extensiones MMX y SSE de Intel, y sus contrapartes, las extensiones 3DNow! de AMD. A partir de 2003, el procesamiento de 64 bits fue incorporado en los procesadores de arquitectura x86 a través de la extensión AMD64 y posteriormente con la extensión EM64T en los procesadores AMD e Intel respectivamente.

Puertos de entrada y salida El microprocesador tiene puertos de entrada/salida en el mismo circuito integrado. El chipset es un conjunto de circuitos integrados que se encarga de realizar las funciones que el microprocesador delega en ellos. El conjunto de circuitos integrados auxiliares necesarios por un sistema para realizar una tarea suele ser conocido como chipset, cuya traducción literal del inglés significa conjunto de circuitos integrados. Se designa circuito integrado auxiliar al circuito integrado que es periférico a un sistema pero necesario para el funcionamiento del mismo. La mayoría de los sistemas necesitan más de un circuito integrado auxiliar; sin embargo, el término chipset se suele emplear en la actualidad cuando se habla sobre las placas base de los IBM PCs. FABRICACIÓN DE MICROPROCESADORES

Los microprocesadores se fabrican empleando técnicassimilares a las usadas para otros circuitos integrados, como chips de memoria. Generalmente, los microprocesadores tienen una estructura más compleja que otros chips, y su fabricación exige técnicas extremadamente precisas.

La fabricación económica de microprocesadores exige su producción masiva. Sobre la superficie de una oblea de silicio se crean simultáneamente varios cientos de gruposde circuitos. El proceso de fabricación de microprocesadores consiste en una sucesión de deposición y eliminación de capas finísimas de materiales conductores, aislantes y semiconductores, hasta que después de cientos de pasos se llega a un complejo "bocadillo" que contiene todos los circuitos interconectados del microprocesador. Para el circuito electrónico sólo se emplea la superficie externa de la oblea de silicio, una capa de unas 10 micras de espesor (unos 0,01 mm, la décima parte del espesor de un cabello humano). Entre las etapas del proceso figuran la creación de sustrato, la oxidación, la litografía, el grabado, la implantación iónica y la deposición de capas.

La primera etapa en la producción de un microprocesador es la creación de un sustrato de silicio de enorme pureza, una "rodaja" de silicio en forma de una oblea redonda pulida hasta quedar lisa como un espejo. En la actualidad, las obleas más grandes empleadas en la industria tienen 200 mm de diámetro.

PSGT 08 Introducción Básica a I.T

37

En la etapa de oxidación se coloca una capa eléctricamente no conductora, llamada dieléctrico. El tipo de dieléctrico más importante es el dióxido de silicio, que se "cultiva" exponiendo la oblea de silicio a una atmósfera de oxígeno en un horno a unos 1.000 ºC. El oxígeno se combina con el silicio para formar una delgada capa de óxido de unos 75 angstroms de espesor (un ángstrom es una diezmilmillonésima de metro).

Casi todas las capas que se depositan sobre la oblea deben corresponder con la forma y disposición de los transistores y otros elementos electrónicos. Generalmente esto se logra mediante un proceso llamado fotolitografía, que equivale a convertir la oblea en un trozo de película fotográfica y proyectar sobre la misma una imagen del circuito deseado. Para ello se deposita sobre la superficie de la oblea una capa fotosensible cuyas propiedades cambian al ser expuesta a la luz. Los detalles del circuito pueden llegar a tener un tamaño de sólo 0,25 micras.

Como la longitud de onda más corta de la luz visible es de unas 0,5 micras, es necesario emplear luz ultravioleta de baja longitud de onda para resolver los detalles más pequeños. Después de proyectar el circuito sobre la capa fotorresistente y revelar la misma, la oblea se graba: esto es, se elimina la parte de la oblea no protegida por la imagen grabada del circuito mediante productos químicos (un proceso conocido como grabado húmedo) o exponiéndola a un gascorrosivo llamado plasma en una cámara de vacío especial.

En el siguiente paso del proceso, la implantación iónica, se introducen en el silicio impurezas como boro o fósforo para alterar su conductividad. Esto se logra ionizando los átomos de boro o de fósforo (quitándoles uno o dos electrones) y lanzándolos contra la oblea a elevadas energías mediante un implantador iónico. Los iones quedan incrustados en la superficie de la oblea.

En el último paso del proceso, las capas o películas de material empleadas para fabricar un microprocesador se depositan mediante el bombardeo atómico en un plasma, la evaporación (en la que el material se funde y posteriormente se evapora para cubrir la oblea) o la deposición de vapor químico, en la que el material se condensa a partir de un gas a baja presión o a presión atmosférica. En todos los casos, la película debe ser de gran pureza, y su espesor debe controlarse con una precisión de una fracción de micra.

Los detalles de un microprocesador son tan pequeños y precisos que una única mota de polvo puede destruir todo un grupo de circuitos. Las salas empleadas para la fabricación de microprocesadores se denominan salas limpias, porque el aire de las mismas se somete a un filtrado exhaustivo y está prácticamente libre de polvo. Las salas limpias más puras de la actualidad se denominan de clase1. La cifra indica el número máximo de partículas mayores de 0,12 micras que puede haber en un pie cúbico de aire (0,028 metros cúbicos). Como comparación, un hogar normal sería de clase 1 millón.

TECNOLOGÍAS FUTURAS

La tecnología de los microprocesadores y de la fabricación de circuitos integrados está cambiando rápidamente. Se prevé que en 2010 los microprocesadores avanzados contengan unos 800 millones de transistores.

PSGT 08 Introducción Básica a I.T

38

Se cree que el factor limitante en la potencia de los microprocesadores acabará siendo el comportamiento de los propios electrones al circular por los transistores. Cuando las dimensiones se hacen muy pequeñas, los efectos cuánticos debidos a la naturalezaondulatoria de los electrones podrían dominar el comportamiento de los transistores y circuitos. Puede que sean necesarios nuevos dispositivos y diseños de circuitos a medida que los microprocesadores se aproximan a dimensiones atómicas. Para producir las generaciones futuras de microchips se necesitarán técnicas como la epitaxia por haz molecular, en la que los semiconductores se depositan átomo a átomo en una cámara de vacío ultraelevado, o la microscopía de barrido de efecto túnel, que permite ver e incluso desplazar átomos individuales con precisión.

MICROPROCESADORES ANTIGUOS

Tal como está el mundo, podríamos decir que cualquiera que tenga más de un mes en el mercado. De todas formas, aquí vamos a suponer antiguo a todo micro que no sea un Pentium o similar (K5, K6, 6x86, Celeron...). 8086, 8088, 286

Se caracterisan por ser todos prehistóricos y de rendimiento similar. Los ordenadores con los dos primeros eran en ocasiones conocidos como ordenadores XT, mientras que los que tenían un 286 (80286 para los puristas) se conocían como AT. En España se vendieron muchos ordenadores con estos micros por la firma Amstrad, por ejemplo.

Ninguno era de 32 bits, sino de 8 ó 16, bien en el bus interno o el externo. Esto significa que los datos iban por caminos (buses) que eran de 8 ó 16 bits, bien por dentro del chip o cuando salían al exterior, por ejemplo para ir a la memoria. Este número reducido de bits (un bit es la unidad mínima de información en electrónica) limita sus posibilidades en gran medida. Un chip de estas características tiene como entorno preferente y casi único el DOS, aunque puede hacerse correr Windows 3.1 sobre un 286 a 16 ó 20 MHz si las aplicaciones que vamos a utilizar no son nada exigentes; personalmente, he usado el procesador de textos AmiPro 1.2 en Windows 3.1 en un 286 y sólo era cuestión de tomármelo con calma (mucha calma cuando le mandaba imprimir, eso sí).

Sin embargo, si tiene un ordenador así, no lo tire; puede usarlo para escribir textos (con algún WordPerfect antiguo), para jugar a juegos antiguos pero adictivos (como el Tetris, Prince of Persia, y otros clásicos), o incluso para navegar por Internet, sobre todo si el monitor es VGA y tiene un módem "viejo" (por ejemplo un 14.400).

386, 386 SX

Estos chips ya son más modernos, aunque aún del Neolítico informático. Su ventaja es que son de 32 bits; o mejor dicho, el 386 es de 32 bits; el 386 SX es de 32 bits internamente, pero de 16 en el bus externo, lo que le hace hasta un 25% más lento que el original, conocido como DX.

PSGT 08 Introducción Básica a I.T

39

Resulta curioso que el más potente sea el original, el 386. La versión SX fue sacada al mercado por Intel siguiendo una táctica comercial típica en esta empresa: dejar adelantos tecnológicos en reserva, manteniendo los precios altos, mientras se sacan versiones reducidas (las "SX") a precios más bajos. La cuestión es que ambos pueden usar software de 32 bits, aunque si lo que quiere usar es Windows 95 ¡ni se le ocurra pensar en un 386! Suponiendo que tenga suficiente memoria RAM, disco, etc., prepárese para esperar horas para realizar cualquier tontería.

Su ámbito natural es DOS y Windows 3.x, donde pueden manejar aplicaciones bastante profesionales como Microsoft Word sin demasiados problemas, e incluso navegar por Internet de forma razonablemente rápida. Si lo que quiere es multitarea y software de 32 bits en un 386, piense en los sistemas operativos OS/2 o Linux (¡este último es gratis!).

486, 486 SX, DX, DX2 y DX4

La historia se repite, aunque esta vez entra en el campo del absurdo de la mano del márketing "Intel Inside". El 486 es el original, y su nombre completo es 80486 DX; consiste en:

• un corazón 386 actualizado, depurado y afinado; • un coprocesador matemático para coma flotante integrado; • una memoria caché (de 8 Kb en el DX original de Intel).

Es de notar que la puesta a punto del núcleo 386 y sobre todo la memoria caché lo hacen mucho más rápido, casi el doble, que un 386 a su misma velocidad de reloj (mismos MHz). Hasta aquí el original; veamos las variantes:

• 486 SX: un DX sin coprocesador matemático. ¿Que cómo se hace eso? Sencillo: se hacen todos como DX y se quema el coprocesador, tras lo cual en vez de "DX" se escribe "SX" sobre el chip. Dantesco, ¿verdad? Pero la teoría dice que si lo haces y lo vendes más barato, sacas dinero de alguna forma. Lo dicho, alucinante.

• 486 DX2: o el "2x1": un 486 "completo" que va internamente el doble de rápido que externamente (es decir, al doble de MHz). Así, un 486 DX2-66 va a 66 MHz en su interior y a 33 MHz en sus comunicaciones con la placa (memoria, caché secundaria...). Buena idea, Intel.

• 486 DX4: o cómo hacer que 3x1=4. El mismo truco que antes, pero multiplicando por 3 en vez de por 2 (DX4-100 significa 33x3=99 ó, más o menos, 100). ¿Que por qué no se llama DX3? Márketing, chicos, márketing. El 4 es más bonito y grande...

En este terreno Cyrix y AMD hicieron de todo, desde micros "light" que eran 386 potenciados (por ejemplo, con sólo 1 Kb de caché en vez de 8) hasta chips muy buenos como el que usé para empezar a escribir esto: un AMD DX4-120 (40 MHz por 3), que rinde casi (casi) como un Pentium 75, o incluso uno a 133 MHz (33 MHz por 4 y con 16 Kb de caché!!).

Por cierto, tanto "por" acaba por generar un cuello de botella, ya que hacer pasar 100 ó 133 MHz por un hueco para 33 es complicado, lo que hace que más que "x3" acabe siendo algo así como "x2,75" (que tampoco está mal).

PSGT 08 Introducción Básica a I.T

40

Además, genera calor, por lo que debe usarse un disipador de cobre y un ventilador sobre el chip.

En un 486 se puede hacer de todo, sobre todo si supera los 66 MHz y tenemos suficiente RAM; por ejemplo, yo hice gran parte de estas páginas, que no es poco.

MICROPROCESADORES MODERNOS

Pentium MMX

Es un micro propio de la filosofía Intel. Con un gran chip como el Pentium Pro ya en el mercado, y a 3 meses escasos de sacar el Pentium II, decidió estirar un poco más la tecnología ya obsoleta del Pentium clásico en vez de ofrecer esas nuevas soluciones a un precio razonable.

Así que se inventó un nuevo conjunto de instrucciones para micro, que para ser modernos tuvieran que ver con el rendimiento de las aplicaciones multimedia, y las llamó MMX (MultiMedia eXtensions). Prometían que el nuevo Pentium, con las MMX y el doble de caché (32 KB), podía tener ¡hasta un 60% más de rendimiento!!

Disculpen si respondo: ¡y unas narices! En ocasiones, la ventaja puede llegar al 25%, y sólo en aplicaciones muy optimizadas para MMX (ni Windows 95 ni Office lo son, por ejemplo). En el resto, no más de un 10%, que además se debe casi en exclusiva al aumento de la caché interna al doble. ¿La ventaja del chip, entonces? Que su precio final acaba siendo igual que si no fuera MMX. Además, consume y se calienta menos por tener voltaje reducido para el núcleo del chip (2,8 V). Por cierto, el modelo a 233 MHz (66 MHz en placa por 3,5) está tan estrangulado por ese "cuello de botella" que rinde poco más que el 200 (66 por 3).

Pentium II ¿El nuevo super-extra-chip? Pues no del todo. En realidad, se trata del viejo Pentium Pro, jubilado antes de tiempo, con algunos cambios (no todos para mejor) y en una nueva y fantástica presentación, el cartucho SEC: una cajita negra superchula que en vez de a un zócalo se conecta a una ranura llamada Slot 1.

Los cambios respecto al Pro son:

• optimizado para MMX (no sirve de mucho, pero hay que estar en la onda, chicos);

• nuevo encapsulado y conector a la placa (para eliminar a la competencia, como veremos);

• rendimiento de 16 bits mejorado (ahora sí es mejor que un Pentium en Windows 95, pero a costa de desaprovecharlo; lo suyo son 32 bits puros);

• caché secundaria encapsulada junto al chip (semi-interna, como si dijéramos), pero a la mitad de la velocidad de éste (un retroceso desde el Pro, que iba a la misma velocidad; abarata los costes de fabricación).

PSGT 08 Introducción Básica a I.T

41

Vamos, un chip "Pro 2.0", con muchas luces y algunas sombras. La mayor sombra, su método de conexión, el "Slot 1"; Intel lo patentó, lo que es algo así como patentar un enchufe cuadrado en vez de uno redondo (salvando las distancias, no nos pongamos puristas). El caso es que la jugada buscaba conseguir que los PC fueran todos marca Intel; ¡y decían que los sistemas propietarios eran cosa de Apple! Eso sí, durante bastante tiempo fue el mejor chip del mercado, especialmente desde que se dejó de fabricar el Pro.

AMD K6 Un chip meritorio, mucho mejor que el K5. Incluía la "magia" MMX, aparte de un diseño interno increíblemente innovador y una caché interna de 64 KB (no hace demasiado, ese tamaño lo tenían las cachés externas; casi da miedo). Se "pincha" en un zócalo de Pentium normal (un socket 7, para ser precisos) y la caché secundaria la tiene en la placa base, a la manera clásica. Pese a esto, su rendimiento es muy bueno: mejor que un MMX y sólo algo peor que un II, siempre que se pruebe en Windows 95 (NT es terreno abonado para el Pentium II).

Aunque es algo peor en cuanto a cálculos de coma flotante (CAD y juegos), para oficina es la opción a elegir en todo el mundo... excepto España. Aquí nos ha encantado lo de "Intel Pentium Inside", y la gente no compra nada sin esta frase, por lo que casi nadie lo vende y mucho menos a los precios ridículos de lugares como EEUU o Alemania. Oferta y demanda, como todo; no basta con una buena idea, hay que convencer. De todas formas, hasta IBM lo usa en algunos de sus equipos; por algo será.

6x86MX (M2) de Cyrix (o IBM)

Nada que añadir a lo dicho sobre el 6x86 clásico y el K6 de AMD; pues eso, un chip muy bueno para trabajo de oficinas, que incluye MMX y que nunca debe elegirse para CAD o juegos (peor que los AMD).

Celeron (Pentium II light)

En breve: un Pentium II sin la caché secundaria. Pensado para liquidar el mercado de placas base tipo Pentium no II (con socket 7, que se dice) y liquidar definitivamente a AMD y otras empresas molestas que usan estas placas. Esta gente de Intel no tiene compasión, sin duda... Muy poco recomendable, rendimiento mucho más bajo que el de Pentium II, casi idéntico al del Pentium MMX.

AMD K6-2 (K6-3D)

Consiste en una revisión del K6, con un núcleo similar pero añadiéndole capacidades 3D en lo que AMD llama la tecnología 3DNow! (algo así como un MMX para 3D).

Además, generalmente trabaja con un bus de 100 MHz hacia caché y memoria, lo que le hace rendir igual que un Pentium II en casi todas las condiciones e incluso mucho mejor que éste cuando se trata de juegos 3D modernos (ya que

PSGT 08 Introducción Básica a I.T

42

necesitan estar optimizados para este chip o bien usar las DirectX 6 de Microsoft).

Desarrollo De Los Microprocesadores Intel

Procesador Fecha de

presentación

Velocidad

de reloj

Ancho

de bus

Número de

transistores

Memoria

direccionable

Memoria

virtual

Breve

descripción

4004 15/11/71 108 KHz. 4 bits 2.300 (10 micras)

640 byte

Primer chip con manipulación aritmética

8008 1/4/72 108 KHz. 8 bits 3.500 16 KBytes Manipulación Datos/texto

8080 1/4/74 2 MHz. 8 bits 6.000 64 KBytes

10 veces las (6 micras) prestaciones del 8008

8086 8/6/78

5 MHz.

8 MHz.

10 MHz.

16 bits

29.000

(3 micras) 1 MegaByte

10 veces las prestaciones del 8080

8088 1/6/79 5 MHz.

8 MHz. 8 bits 29.000

Idéntico al 8086 excepto en su bus externo de 8 bits

80286 1/2/82

8 MHz.

10 MHz.

12 MHz.

16 Bits

134.000

(1.5 micras)

16 Megabytes

1 Gigabyte

De 3 a 6 veces las prestaciones del 8086

Microprocesador

Intel 386 DX® 17/10/85

16 MHz.

20 MHz.

25 MHz.

33 MHz.

32 Bits

275.000

(1 micra) 4 Gigabytes 64

Terabytes

Primer chip x86 capaz de manejar juegos de datos de 32 bits

Microprocesador 16/6/88 16 MHz. 16 Bits

275.000 4 gigabytes 64 Bus capaz de direccionar

PSGT 08 Introducción Básica a I.T

43

Intel 386 SX® 20 MHz. (1 micra) Terabytes 16 bits procesando 32bits a bajo coste

Microprocesador

Intel 486 DX® 10/4/89

25 MHz.

33 MHz.

50 MHz.

32 Bits

(1 micra, 0.8 micras en 50 MHz.)

4 Gigabytes 64

Terabytes

Caché de nivel 1 en el chip

Microprocesador

Intel 486 SX® 22/4/91

16 MHz.

20 MHz.

25 MHz.

33 MHz.

32 Bits

1.185.000

(0.8 micras)

4 Gigabytes 64

Terabytes

Idéntico en diseño al Intel 486DX, pero sin coprocesador matemático

Procesador

Pentium® 22/3/93

60 MHz.

66 MHz.

75 MHz.

90 MHz.

100 MHz.

120 MHz.

133 MHz.

150 MHz.

166 MHz.

200 MHz.

32 Bits

3,1 millones

(0.8 micras)

4 Gigabytes 64

Terabytes

Arquitectura escalable. Hasta 5 veces las prestaciones del 486 DX a 33 MHz.

Procesador

PentiumPro® 27/3/95

150 MHz.

180 MHz.

200 MHz.

64 Bits

5,5 millones

(0.32 micras)

4 Gigabytes 64

Terabytes

Arquitectura de ejecución dinámica con procesador de altas prestaciones

Procesador

PentiumII® 7/5/97

233 MHz.

266 MHz.

300 MHz.

64 Bits

7,5 millones

(0.32 micras)

4 Gigabytes 64

Terabytes

S.E.C., MMX, Doble Bus Indep., Ejecución Dinámica

PSGT 08 Introducción Básica a I.T

44

CHIPSETS

El chipset es un conjunto de circuitos integrados diseñado para trabajar conjuntamente y generalmente vendido como un único producto. En el mundo de los computadores personales se disponían muchos circuitos integrados como apoyo al microprocesador tales como el controlador de interrupciones, controlador de acceso directo a memoria, controlador de reloj, etc. Para reducir el número de circuitos se fueron creando circuitos más complejos que incluían multiples funcionalidades en su interior. Esos circuitos son los que actualmente se denominan chipset del computador y son responsables en una medida importante del rendimiento global del mismo. Se ha comparado al Chipset con la "médula espinal": "una persona puede tener un buen cerebro, pero si la médula falla, todo el cuerpo no sirve para nada". Las computadoras personales actuales tienen chipset formado por 2 circuitos auxiliares al procesador principal:

• El puente norte que se utiliza como puente de enlace entre el microprocesador y la memoria, controlando los accesos hacia y desde el microprocesador, la memoria RAM, el puerto gráfico y las comunicaciones con el puente sur.

• El puente sur que controla los dispositivos asociados, es decir se encarga de comunicar el procesador con el resto de los periféricos. (los controladores de disco, puertos de entrada y salida, como USB, etc.)

RAM (RANDOM ACCES MEMORY)

MEMORIA DE ACCESO ALEATORIO Esta se compone físicamente de uno o más chips y se utiliza como memoria de trabajo para programas y datos. Es un tipo de memoria temporal que pierde sus datos cuando se queda sin energía, por lo cual es una memoria volátil. Es un tipo de memoria a la que se puede acceder de forma aleatoria; esto es, se puede acceder a cualquier byte de la memoria sin pasar por los bytes precedentes. RAM es el tipo más común de memoria en las computadoras y en otros dispositivos, tales como las impresoras. La memoria principal o RAM es donde el computador guarda los datos que está utilizando en el momento presente. El almacenamiento es considerado temporal por que los datos y programas permanecen en ella mientras que la computadora este encendida o no sea reiniciada.

PSGT 08 Introducción Básica a I.T

45

TIPOS DE RAM

Hay dos tipos básicos de memoria RAM

• RAM dinámica (DRAM) • RAM estática (SRAM)

Los dos tipos de memoria RAM se diferencian en la tecnología que utilizan para guardar los datos, la memoria RAM dinámica es la más común. La memoria RAM dinámica necesita actualizarse miles de veces por segundo, mientras que la memoria RAM estática no necesita actualizarse, por lo que es más rápida, aunque también más cara. Ambos tipos de memoria RAM son volátiles, es decir, que pierden su contenido cuando se apaga el equipo.

MEMORIA DRAM

La memoria DRAM ("Dynamic RAM") es una memoria RAM electrónica construida mediante condensadores. Los condensadores son capaces de almacenar un bit de información almacenando una carga eléctrica. Lamentablemente los condensadores sufren de fugas lo que hace que la memoria DRAM necesite refrescarse cada cierto tiempo: el refresco de una memoria RAM consiste en recargar los condensadores que tienen almacenado un uno para evitar que la información se pierda por culpa de las fugas (de ahí lo de "Dynamic"). Entre las memorias DRAM tenemos: FPM-RAM (Fast Page Mode RAM) Memoria asíncrona, más rápida que la anterior (modo de Página Rápida) y con tiempos de acceso de 70 ó 60 ns. Esta memoria se encuentra instalada en muchos sistemas de la primera generación de Pentium. Incorpora un sistema de paginado debido a que considera probable que el próximo dato a acceder este en la misma columna, ganando tiempo en caso afirmativo. EDO-RAM (Extended Data Output RAM) Memoria asíncrona, esta memoria permite a la CPU acceder más rápido porque envía bloques enteros de datos; con tiempos de acceso de 40 ó 30 ns. BEDO-RAM (Burst Extended Data Output RAM) Es una evolución de la EDO RAM y competidora de la SDRAM. Lee los datos en ráfagas, lo que significa que una vez que se accede a un dato de una posición determinada de memoria se leen los tres siguientes datos en un solo ciclo de reloj por cada uno de ellos, reduciendo los tiempos de espera del procesador. Al igual que la EDO RAM, la limitación de la BEDO RAM es que no puede funcionar por encima de los 66 MHz. SDR SDRAM (Single Data Rate Synchronous Dynamic RAM ) Memoria síncrona (misma velocidad que el sistema), con tiempos de acceso de entre 25 y 10ns y que se presentan en módulos DIMM de 168 contactos. Fue

PSGT 08 Introducción Básica a I.T

46

utilizada en los Pentium 2 y en los Pentium III , así como en los AMD K6, K7 y Duron. Dependiendo de la frecuencia de trabajo se dividen en:

• PC66: la velocidad de bus de memoria es de 66 MHz, temporización de 15 ns y ofrece tasas de transferencia de hasta 533 MB/s.

• PC100: la velocidad de bus de memoria es de 100 MHz, temporización de 8 ns y ofrece tasas de transferencia de hasta 800 MB/s.

• PC133: la velocidad de bus de memoria es de 133 MHz, temporización de 7,5 ns y ofrece tasas de transferencia de hasta 1066 MB/s.

Está muy extendida la creencia de que se llama SDRAM a secas, y que la denominación SDR SDRAM es para diferenciarla de la memoria DDR, pero no es así, simplemente se extendió muy rápido la denominación incorrecta. El nombre correcto es SDR SDRAM ya que ambas (tanto la SDR como la DDR) son Memorias Síncronas Dinámicas. DDR SDRAM (Double Data Rate SDRAM) Memoria síncrona, envía los datos dos veces por cada ciclo de reloj. De este modo trabaja al doble de velocidad del bus del sistema, sin necesidad de aumentar la frecuencia de reloj. Se presenta en módulos DIMM de 184 contactos. Del mismo modo que la SDRAM, en función de la frecuencia del sistema se clasifican en (según JEDEC):

• PC 1600 ó DDR200: funciona a 2.5 V, trabaja a 200 MHz, es decir 100 MHz de bus de memoria y ofrece tasas de transferencia de hasta 1,6 GB/s (de ahí el nombre PC1600). Este tipo de memoria la utilizaron los Athlon XP de AMD, y los primeros Pentium 4.

• PC 2100 ó DDR266: funciona a 2.5 V, trabaja a 266 MHz, es decir 133 MHz de bus de memoria y ofrece tasas de transferencia de hasta 2,1 GB/s (de ahí el nombre PC2100).

• PC 2700 ó DDR333: funciona a 2.5 V, trabaja a 333 MHz, es decir 166 MHz de bus de memoria y ofrece tasas de transferencia de hasta 2,7 GB/s (de ahí el nombre PC2700).

• PC 3200 ó DDR400: funciona a 2.5V, trabaja a 400 MHz, es decir, 200 MHz de bus de memoria y ofrece tasas de transferencia de hasta 3,2 GB/s (de ahí el nombre PC3200).

• También existen las especificaciones DDR433, DDR466, DDR500, DDR533 y DDR600 pero según muchos ensambladores es poco práctico utilizar DDR a más de 400 MHz, por lo que está siendo sustituida por la revisión DDR2.

• PC-4200 ó DDR2-533: trabaja a 533 MHz, es decir, 133 MHz de bus de memoria y ofrece tasas de transferencia de hasta 4,2 GB/s (de ahí el nombre PC4200).